современные процессоры ru (1). Г рядущее появление графических процессоров общего назначения

Скачать 488.05 Kb. Скачать 488.05 Kb.

|

|

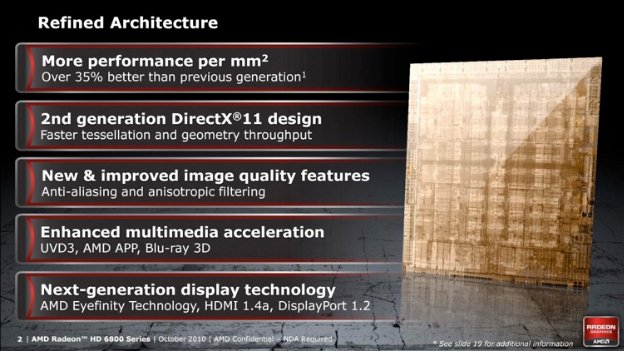

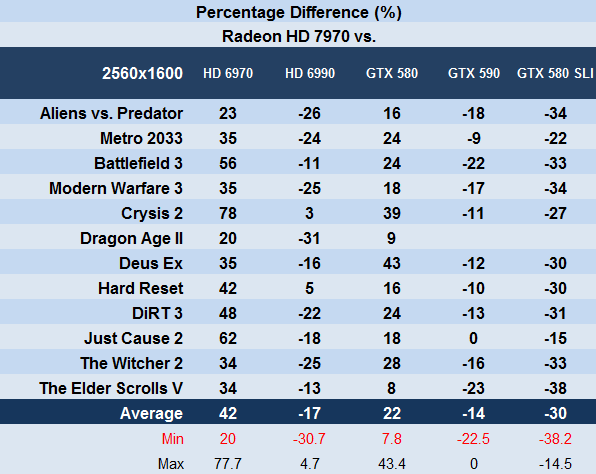

Г  рядущее появление графических процессоров общего назначения рядущее появление графических процессоров общего назначенияДо появления DirectX 10 не было смысла добавлять излишнюю сложность за счет увеличения площади кристалла, что увеличило функциональность вершинных шейдеров в дополнение к увеличению точности плавающей точки пиксельных шейдеров с 24 до 32 бит, чтобы соответствовать требованиям к вершинным операциям. С приходом DX10 вершинные и пиксельные шейдеры сохранили большое количество общих функций, поэтому переход к единой шейдерной арке устранил ненужное дублирование блоков обработки. Первым GPU, использовавшим эту архитектуру, был культовый G80 от Nvidia. Четыре года разработки и 475 миллионов долларов США позволили создать 681 миллион транзисторов, 484 мм² - первый флагман 8800 GTX и 8800 GTS 640MB 8 ноября. Разогнанная GTX, 8800 Ultra, представляла собой вершину G80 и была помещена между выпуском двух менее мощных продуктов: 320MB GTS в феврале и ограниченной серии GTS 640MB/112 Core 19 ноября 2007 года. Благодаря новому алгоритму сглаживания по образцу покрытия (CSAA), Nvidia получила удовлетворение от того, что ее GTX уничтожила всех конкурентов с одной и двумя графическими системами по производительности. Несмотря на этот успех, в четвертом квартале компания потеряла три процентных пункта доли рынка дискретной графики - очки AMD получила за счет OEM-контрактов.  Версия GeForce 8800 GTX от MSI Остальные компоненты бизнес-стратегии Nvidia в отношении G80 стали реальностью в феврале и июне 2007 года. SDK (Software Development Kit) для платформы CUDA на языке C был выпущен в бета-версии, чтобы создать экосистему, использующую высокопараллельную природу GPU. Физический движок PhysX компании Nvidia, а также проекты распределенных вычислений, профессиональная виртуализация и OptiX, движок трассировки лучей компании Nvidia, являются наиболее известными приложениями, использующими CUDA. И Nvidia, и ATI (теперь AMD) интегрировали все более широкие вычислительные функции в графический конвейер. ATI/AMD решили положиться на разработчиков и комитеты для пути OpenCL, в то время как у Nvidia были более ближайшие планы на CUDA и высокопроизводительные вычисления. С этой целью в июне Nvidia представила линейку математических сопроцессоров Tesla, изначально основанную на том же ядре G80, на котором уже работали GeForce и Quadro FX 4600/5600, а после длительной разработки, включавшей как минимум два (а возможно, и три) крупных отладочных мероприятия, AMD выпустила R600 в мае. Благодаря новому алгоритму сглаживания Coverage Sample (CSAA) компания Nvidia получила удовлетворение от того, что ее GTX обошла всех конкурентов с одной и двумя графическими системами по производительности. Из-за шумихи в прессе выпуск этой карты ожидался как ответ AMD на 8800 GTX, но то, что было представлено в виде HD 2900 XT, в значительной степени разочаровало. Это была карта верхнего среднего уровня с энергопотреблением платы для энтузиастов, потребляющая больше энергии, чем любое другое современное решение. Масштаб ошибки с R600 имел глубокие последствия для ATI, что привело к изменению стратегии для соблюдения будущих сроков и максимизации возможностей запуска. Исполнение улучшилось в RV770 (Evergreen), а также в сериях Northern и Southern Islands. Помимо того, что R600 является самым большим на сегодняшний день графическим процессором ATI/AMD с площадью 420 мм², в нем реализован целый ряд первых достижений в области GPU. Это был первый чип AMD с поддержкой DirectX 10, первый и единственный GPU с 512-битной шиной памяти, первый чип для настольных ПК с блоком тесселятора (который остался практически неиспользованным из-за безразличия разработчиков игр и отсутствия поддержки DirectX), первый GPU с интегрированной поддержкой аудио через HDMI, а также первый GPU с архитектурой VLIW, которая сохранилась в AMD до нынешней серии 8000. Кроме того, впервые после Radeon 7500 ATI/AMD не представила карту высшего уровня по отношению к цене и производительности конкурентов. AMD обновила R600 до RV670, уменьшив размеры GPU с 80-нм техпроцесса TSMC до 55-нм, а также заменив 512-битную двунаправленную кольцевую шину памяти на более стандартную 256-битную. Это позволило вдвое сократить площадь матрицы R600, в то время как в нее поместилось почти столько же транзисторов (666 миллионов против 700 миллионов в R600). AMD также обновила графический процессор для DX10.1 и добавила поддержку PCI Express 2.0. Все это было достаточно хорошо, чтобы списать серию HD 2000 и конкурировать с GeForce 8800 GT и другими менее популярными картами. В отсутствие GPU высокого класса компания AMD выпустила две карты с двумя GPU, а также бюджетные карты на базе RV620/635 в январе 2008 года. HD 3850 X2 была выпущена в апреле, а последняя карта под брендом All-In-Wonder, HD 3650, - в июне. Выпущенные с отполированным пакетом драйверов, карты с двумя GPU сразу же произвели впечатление на рецензентов и покупателей. HD 3870 X2 с комфортом стала самой быстрой картой, а HD 3850 X2 была не намного медленнее. В отличие от решения SLI от Nvidia, AMD ввела поддержку Crossfiring карт с общим ASIC.  Radeon HD 3870 X2 объединяет два графических процессора в одной карте Продолжая успех G80, 29 октября компания Nvidia выпустила G92 под названием 8800 GT, получив широкое признание на технических сайтах, в основном благодаря очень конкурентоспособной цене. Находясь в диапазоне от $199 до $249, карта с 512 Мб памяти обеспечивала производительность, которая не могла сравниться с 8800 GTS на базе G80. Она в основном превосходила HD 2900 XT и HD 3870, которые были выпущены через три недели после GT и в целом находились в пределах 80% от GTX. Неудивительно, что это привело к дефициту 8800 GT в течение нескольких недель. Высокий спрос на нового соперника Nvidia и его братьев и сестер 8600 GS/GT помог компании достичь 71% доли дискретного рынка к концу года. Вслед за GT, 11 декабря Nvidia выпустила 8800 GTS 512MB на базе G92. Хотя в целом производительность на доллар уступает GT, спасительным преимуществом GTS стало использование более производительных GPU, которые при разгоне практически сравнялись с GTX и дорогой 8800 Ultra. История серии GeForce 8 была бы неполной без добавления досадного постскриптума - использования припоя с высоким содержанием свинца в BGA некоторых графических процессоров G86, G84, G73, G72/72M, а также графических чипсетов C51 и MCP67. Это, в сочетании с низкотемпературным заполнением, неадекватным охлаждением и интенсивным режимом циклов "горячее/холодное", вызвало чрезмерное количество отказов графики. Если серия 8 была технологическим триумфом Nvidia, то серия 9 положила начало периоду стагнации. В середине 2008 года Nvidia перешла на эвтектический припой Hitachi (с высоким содержанием олова), используемый AMD, и значительно изменила однослотовый эталонный дизайн кулера 8800 GT, добавив больше лопастей вентилятора, а также изменив кожух для обеспечения более интенсивного воздушного потока. Предполагается, что проблема недозаполнения затронула и G92, хотя двухслотовый дизайн 8800 GTS 512M и карты, оснащенные нереференсным кулером, похоже, не были сильно затронуты. Компания понесла расходы в размере $475,9 млн. в связи с этой проблемой, что привело к резкому отпору со стороны потребителей в адрес производителей комплектующих для ноутбуков Nvidia, которые знали об этой проблеме еще до того, как она стала достоянием общественности. Место Nvidia в индустрии будет навсегда связано с этой самой низкой точкой в ее истории. Если серия 8 стала технологическим триумфом Nvidia, то серия 9 положила начало периоду стагнации. Изюминкой серии стала первая модель, представленная в феврале 2008 года. 9600 GT был основан на "новом" G94, который был не более чем урезанным G92 предыдущего года, построенным по тому же 65-нм техпроцессу TSMC. Агрессивное снижение цен со стороны AMD на HD 3870 и HD 3850 наряду с падением цен на собственные 8800 GS и GT от Nvidia привело к тому, что остальные модели серии 9 почти полностью перешли под знамя ребрендинга. Первые 9800 GT были переименованием 8800 GT, а 8800 GTS (G92) превратилась в 9800 GTX. Переход на 55-нм техпроцесс TSMC позволил сократить площадь на 20% по сравнению с G92 и немного увеличить тактовую частоту для выпуска 9800 GTX+, идентичной OEM GTS 150, а также GTS 250, которая поступила в розничную продажу через пятнадцать месяцев после оригинальной карты 8-й серии. Из-за позднего появления флагманской GT200 и того факта, что HD 3870 X2 от AMD стала лучшей в гонке однокарточных решений, Nvidia прибегла к проверенной временем традиции удвоения графических процессоров, соединив две 9800 GT вместе для создания 9800 GX2. Хотя она и выиграла гонку бенчмарков, большинство наблюдателей быстро заметили, что продажа двух 9800 GT по цене трех отдельных 9800 GT имеет в лучшем случае ограниченную привлекательность.  Графический процессор Nvidia G200 на плате GTX 260 В июне Nvidia выпустила GTX 260 и GTX 280 с графическим процессором GT200, деталью площадью 576 мм², которая представляет собой самую большую производственную матрицу GPU на сегодняшний день (Larrabee от Intel оценивалась в 600-700 мм²) и самый большой производственный чип любого типа, изготовленный TSMC. GT200 подтвердил стремление Nvidia вывести GPGPU в центр внимания, включив в конструкцию выделенное оборудование двойной точности (FP64) и вычислительное оборудование. Архитектурные изменения, ориентированные на игры, были более скромными, но это не помешало Nvidia установить на 280-ю модель цену в $649 или выпустить драйверы 3D Vision (3D-игры и видео) в сочетании с 3D-очками с затвором и ИК-излучателем - очень дорогой комплект. Техническая демонстрация серии Nvidia GTX 200 После появления HD 4870 и 4850 цены резко снизились: цена GTX 280 упала на 38% до 400 долларов, а GTX 260 - на 25% до 299 долларов. AMD ответила на GT200 и G92 выпуском RV770. Первая карта, HD 4730, была выпущена 8 июня, а 25 июня появились HD 4850 и 4870. Презентация потеряла определенную значимость, поскольку произошла утечка спецификаций, и магазины начали продавать HD 4850 за неделю до истечения срока действия NDA - обычное явление сейчас, но в 2008 году оно было менее распространено. Модели 4870 и 4850 стали первыми потребительскими видеокартами, использующими память GDDR5, которую Nvidia в конечном итоге внедрила восемнадцать месяцев спустя в GT 240 на базе GT215. HD 4870 и 4850 заслужили восторженные отзывы благодаря обширному списку функций, включая звук 7.1 LPCM через HDMI, общей производительности и масштабированию с несколькими GPU и, конечно же, цене. Единственным недостатком карты была ее склонность к высоким локальным температурам компонентов регулирования напряжения в референсных платах, что вызывало непропорционально высокие показатели отказов и блокировок - особенно при использовании программ для прожига, таких как Furmark. Следуя примеру предыдущего поколения и "необходимости" сократить двухмесячное правление GTX 280, AMD выпустила HD 4870 X2 в августе. Карта быстро закрепилась на вершине чартов бенчмарков в большинстве категорий, включая производительность, а также в категории шумопроизводительности и тепловыделения благодаря эталонному вентилятору.  Radeon HD 4870 X2 (вверху) и Radeon HD 4870 Январь 2009 года принес лишь незначительные изменения в линейку Nvidia, когда GT 200 перешел на 55-нм техпроцесс TSMC. 55 нм был использован в чипах ревизии B3, которые впервые увидели свет в сентябре предыдущего года в виде версии Core 216 для GTX 260. Компания предложила GTX 295, который состоял из двух урезанных (ROPs и шина памяти) GT200-B3. Вариант этой карты с одним GPU вышел в апреле под названием GTX 275. Но и AMD ответила тем же: пересмотренным HD 4890 на базе RV790XT и HD 4770 (RV740), которая также стала первой 40-нм картой AMD. HD 4770, хотя и не является самостоятельным крупным продуктом, дал AMD огромный опыт работы с проблемным 40-нм техпроцессом TSMC, который давал большие отклонения в утечке тока, а также высокий процент брака из-за неполного соединения металлических слоев в матрице GPU. Обладая такими знаниями, AMD смогла улучшить проблемы литейного процесса, с которыми столкнулась Nvidia в своей архитектуре Fermi - проблемы, которые не проявились в первоначальных миниатюрных 40-нм GPU Nvidia. Nvidia выпустила свои первые 40-нм продукты в июле. Карты начального уровня GT216 и GT218 были представлены в виде GeForce 205, 210 и GT 220, все они были OEM-продуктами до октября, когда две последние поступили в розничную продажу. Они примечательны только тем, что являются первыми картами Nvidia с поддержкой DX10.1 - то, чего AMD достигла с HD 4870/4850 - а также улучшенными звуковыми возможностями с 7.1 аудио, LPCM аудио без потерь, битстримингом Dolby TrueHD/DTS-HD/-HD-MA и аудио через HDMI. Серия была нацелена на рынок домашних кинотеатров и в феврале 2010 года была переименована в серию 300. Проблемный 40-нм техпроцесс TSMC ударил по возможностям AMD извлечь выгоду из отсутствия Fermi у Nvidia, поскольку высокий спрос превысил предложение. За четыре месяца с сентября 2009 года по февраль 2010 года AMD провела тщательный запуск четырех графических процессоров (Cypress, Juniper, Redwood и Cedar), которые составили семейство Evergreen, начиная с топовой HD 5870, за которой через неделю последовала HD 5850. Проблемный 40-нм техпроцесс TSMC нанес удар по способности AMD извлечь выгоду из отсутствия Fermi у Nvidia, поскольку высокий спрос превысил предложение. В значительной степени это было обусловлено тем, что AMD удалось приурочить выпуск Evergreen к выходу Windows 7 и принятию DirectX 11. В то время как DX11 потребовалось время, чтобы продемонстрировать значительную ценность Evergreen, другая функция, представленная в HD 5000, оказала немедленное влияние в виде Eyefinity, которая опирается на гибкость DisplayPort, позволяя использовать до шести конвейеров отображения на плату. Они направляются на обычный ЦАП или на комбинацию внутренних передатчиков TMDS и DisplayPort. Предыдущие видеокарты обычно использовали комбинацию VGA, DVI и иногда HDMI, и все они требовали выделенного источника тактовой частоты для каждого выхода. Это увеличивало сложность, размер и количество выводов графического процессора. DisplayPort устранил необходимость в независимой синхронизации и открыл для AMD возможность интегрировать до шести конвейеров дисплея в аппаратное обеспечение, в то время как программное обеспечение остается ответственным за обеспечение пользовательского опыта. Это включает компенсацию безеля и распределение дисплея по панелям с оптимальным разрешением. Eyefinity: Технология масштабируемого мультидисплея от ATI Серия Evergreen стала лидером в своем классе (не считая проблем с фильтрацией текстур), при этом HD 5850 и HD 5770 привлекли большую часть экономных геймеров, а HD 5870 и HD 5970 с двумя GPU обеспечили непревзойденный уровень производительности и эффективности. Спустя шесть месяцев, 12 апреля, Nvidia наконец (мягко) выпустила свои первые платы Fermi в виде GTX 470 и 480. Ни одна из матриц компании не была полностью функциональной - как в случае с последующей GF104 - поэтому скорость ядер Fermi была довольно консервативной, чтобы снизить энергопотребление, а пропускная способность памяти была ниже из-за неопытности Nvidia в работе с вводом/выводом GDDR5. В то время как GTX 480 была встречена сдержанно, второй чип Fermi от Nvidia, основной GF104 в GTX 460, имел монументальный успех. Менее чем оптимальный выход на 40-нм техпроцессе TSMC, который уже вызвал проблемы с поставками для AMD, значительно увеличился благодаря размеру кристалла GF100 Fermi, составляющему 529 мм². Учитывая неразрывную связь между размерами кристалла, выходом, потребляемой мощностью и тепловыделением, серия 400 от Nvidia заплатила высокую цену за игровую производительность по сравнению с линейкой AMD. Варианты Quadro и Tesla для GF100 практически не пострадали на рынке, если вообще пострадали, благодаря экосистеме внутри профессиональных рынков. Одним из аспектов запуска, который не разочаровал, было внедрение сглаживания с супердискретизацией прозрачности (TrSSAA), которое должно было использоваться вместе со встроенным сэмплированием покрытия (CSAA). В то время как GTX 480 была встречена сдержанно, второй чип Fermi от Nvidia, основной GF104 в GTX 460, имел монументальный успех. Он предлагал хорошую производительность по отличной цене: 192 бит/768 МБ стоил 199 долларов, а 256 бит/1 ГБ - 229 долларов. Было выпущено множество нереференсных и разогнанных на заводе карт со значительным запасом разгона благодаря консервативным референсным тактовым частотам, выбранным Nvidia для снижения энергопотребления. Отчасти положительный прием 460-й модели объясняется тем, что после появления GF100 ожидания были приглушенными. Предполагалось, что GF104 будет не более чем половиной GF100 и будет ужасно страдать рядом с GPU Cypress от AMD. Это оказалось неверным. Второй сюрприз ожидал "экспертов" блогов, а также AMD, когда Nvidia представила обновленную версию GF100, GF110, в ноябре. Обновленная часть достигла того, что не удалось ее предшественнице - а именно, включение всего чипа. В результате GTX 570 и 580 стали тем, чем должна была стать оригинальная серия 400. Barts, первый графический процессор AMD серии Northern Islands, появился в октябре. Являясь скорее эволюцией Evergreen, Barts был разработан для снижения производственных затрат за счет использования матрицы Cypress. Вместо существенного увеличения производительности GPU стремился сравняться с предыдущими моделями HD 5830 и HD 5850, но при этом существенно сэкономить на размере GPU. AMD сократила количество потоковых процессоров (шейдеров), переработала и уменьшила физический размер контроллера памяти (и связанное с этим снижение скорости памяти), а также убрала возможность выполнять вычисления с двойной точностью. Однако в Barts была улучшена тесселяция по сравнению с Evergreen.  Хотя прирост производительности не был значительным, AMD усовершенствовала некоторые аспекты технологии дисплеев. DisplayPort был доведен до версии 1.2 (возможность управления несколькими мониторами от одного порта, обновление до 120 Гц для дисплеев высокого разрешения и передача битового потока аудио), HDMI - до версии 1.4a (воспроизведение видео 3D 1080p, разрешение экрана 4K), а также компания добавила обновленный видеодекодер с поддержкой DivX. AMD также улучшила набор функций драйвера, внедрив морфологическое сглаживание (MLAA), фильтр размытия после обработки, чья функциональность - особенно на старте - была крайне неудачной. Появление HD 6970 и HD 6950 добавило в драйвер Catalyst обычный режим AA с EQAA (Enhanced Quality AA), а AMD также реализовала эмбриональную поддержку HD3D, которая в лучшем случае была нестабильной, и динамическое энергопотребление, на этот раз профилированное с помощью PowerTune. В целом, части Cayman были лучше, чем чипы Fermi первого поколения. Они должны были превзойти их, но отстали от второго поколения (GTX 500) на несколько процентных пунктов, а последующие выпуски драйверов от обоих лагерей еще больше увеличили разброс. Выпуск Cayman в ноябре был отложен на месяц, а HD 6970 и 6950 были выпущены 15 декабря, и они представляли собой (кратковременный) отход от архитектуры VLIW5, которую ATI/AMD постоянно использовала начиная с серии R300. Вместо этого компания использовала VLIW4, которая отказалась от пятого блока выполнения специальных функций (или трансцендентных) в каждом блоке потоковой обработки. Это было сделано для того, чтобы отменить избыток ресурсов для игр DX9 (и более ранних версий), одновременно добавив более ориентированную на вычисления реорганизацию графического конвейера. Интегрированная графика в APU серий Trinity и Richland - единственные другие компоненты VLIW4, и хотя новейшая графическая архитектура AMD основана на GCN (Graphics Core Next), VLIW5 продолжает жить в серии HD 8000 в качестве ребрендинга GPU Evergreen начального уровня. Как и в случае с GF100/GF110, преемник GTX 460 - GTX 560 Ti - появился в январе 2011 года. Эта карта на базе GF114 оснащалась полностью функциональным обновленным GF104 и оказалась такой же надежной и универсальной, как и ее предшественница. Она предлагала огромное количество нереференсных интерпретаций с заводским разгоном и без него. В ответ AMD сразу же снизила стоимость своих HD 6950 и 6870, поэтому преимущество GTX 560 Ti по соотношению цена/производительность исчезло еще во время написания обзоров. С учетом скидок, предлагаемых по почте многими партнерами по производству плат, HD 6950 - особенно версия с 1 ГБ - стала более привлекательной покупкой.  Референсная плата Nvidia GeForce GTX 590 Вторая крупная презентация компании Nvidia в 2011 году, состоявшаяся 26 марта, началась с шумихи. GTX 590 объединила две полнофункциональные GF110 на одной печатной плате. Практически сразу же начался PR-отклик. На платах использовался драйвер, который не включал ограничение мощности в нужной степени, и в паре с BIOS, который допускал высокое напряжение. Этот недосмотр позволил агрессивному перенапряжению привести к взрывам МОП-транзисторов. Nvidia исправила ситуацию с помощью более сдержанного BIOS и драйвера, но действия в день запуска вызвали появление нескольких язвительных отзывов и, по крайней мере, одного популярного видеоролика на YouTube. GTX 590 достигла не более чем паритета производительности с HD 6990, собственной двойной картой AMD двухнедельной давности. Не имея явного победителя в бенчмарках, продукты вызвали нескончаемый поток дебатов на форумах, начиная от масштабирования с несколькими GPU, доступности на складах, актуальности бенчмарков, методологии тестирования и заканчивая взрывающимися 590-ми. Преемники AMD Northern Islands, Southern Islands, начали ступенчатый график выпуска серии, начав 9 января с флагманской HD 7970. Это была первая карта с интерфейсом PCI-E 3.0 и первый представитель архитектуры AMD GCN, построенной на 28-нм технологическом узле TSMC. Всего три недели спустя к 7970 присоединилась вторая карта на базе Tahiti, HD 7950, а 15 февраля последовали карты Cape Verde. Производительная карта Pitcairn на базе GPU поступила на полки магазинов месяцем позже, в марте.  Одним из бонусов частей Tahiti стало подтверждение того, что AMD оставила много неиспользованной производительности, доступной с помощью разгона. Это был компромисс между энергопотреблением и тепловыделением в сравнении с тактовой частотой, но привело к консервативным частотам ядра и памяти. Необходимость максимизировать выход продукции и недооценка Nvidia GTX 680/670 на базе Kepler, возможно, также вошли в уравнение. Карты были хороши, но не обеспечили впечатляющих игровых улучшений по сравнению с предыдущими 40-нм платами. Это, в сочетании с менее конкурентоспособной ценой, которая была характерна для AMD со времен серии HD 2000, отсутствием WHQL-драйверов в течение двух месяцев и неработающим движком Video Codec Engine (VCE), умерило энтузиазм многих потенциальных пользователей и рецензентов. Компания Nvidia продолжила расширять набор функций в графических процессорах, представив архитектуру Kepler. В предыдущих поколениях Nvidia выпускала наиболее сложные чипы, чтобы удовлетворить запросы игрового сообщества высокого класса и начать длительный процесс проверки профессиональных моделей (Tesla/Quadro). В предыдущих поколениях этот подход не принес компании особой пользы, поэтому, похоже, более компактный GK107 и ориентированный на производительность GK104 получили приоритет над "зверским" GK110. Предположительно, GK107 был необходим, поскольку у Nvidia были значительные мобильные OEM-контракты, которые нужно было выполнить, а GK104 требовался для рынка настольных ПК премиум-класса. Оба GPU поставлялись как чипы ревизии A2. Мобильные GK107 (GT 640M/650M, GTX 660M) начали поставляться OEM-производителям в феврале и были официально анонсированы 22 марта, в тот же день, когда Nvidia представила GTX 680 на базе GK104. Еще одним отступлением от последних разработок Nvidia в области GPU стало то, что шейдер работает на той же частоте, что и ядро. Начиная с серии GeForce 8, Nvidia использовала шейдер, работающий как минимум в два раза чаще ядра - до 2,67 раз в 9 серии и ровно в два раза в 400 и 500. Nvidia поняла, что большее количество ядер, работающих на более низкой скорости, более эффективно для параллельных рабочих нагрузок, чем меньшее количество ядер, работающих на удвоенной частоте. Основанием для изменения послужило то, что Nvidia сместила акцент (в потребительских настольных/мобильных системах) с абсолютной производительности на эффективность на ватт. Большее количество ядер, работающих на более низкой скорости, более эффективно для параллельных рабочих нагрузок, чем меньшее количество ядер, работающих на удвоенной частоте. По сути, это было усовершенствование парадигмы GPU против CPU (много ядер, низкая частота, высокая пропускная способность и задержка против нескольких ядер, высокая частота, низкая пропускная способность и задержка). Уменьшение тактовой частоты шейдеров также имеет преимущество в снижении энергопотребления, и Nvidia еще больше сэкономила на дизайне, резко сократив количество доступных блоков двойной точности, а также уменьшив ширину шины до более стандартной 256-битной. Эти изменения, наряду с относительно скромной базовой скоростью ядра, дополненной функцией динамического разгона (разгон по требованию), позволили создать гораздо более сбалансированный продукт - хотя и в ущерб вычислительным способностям. Однако если бы Nvidia сохранила вычислительную функциональность и пропускную способность Fermi, ее бы высмеяли за создание большого, горячего, энергоемкого дизайна. Законы физики снова превратили проектирование чипов в искусство компромисса. И снова Nvidia выпустила плату с двумя GPU. Благодаря улучшенной энергоэффективности GK104, GTX 690 - это, по сути, две GTX 680 в SLI. Единственное отличие заключается в том, что максимальная частота ядра (boost) у 690 на 52 МГц ниже. Хотя производительность все еще зависит от прихоти драйвера SLI-профилирования, функциональность карты первоклассная, а ее эстетика достойна брендинга ограниченной серии. GK 110 - это отход от обычной практики Nvidia, когда GPU выпускается сначала под маркой GeForce. Впервые карта была представлена под названием Tesla K20 и была запрошена в большом количестве для контрактов на суперкомпьютеры: более 22 000 штук потребовалось для системы Cray XK7 Titan в ORNL, Blue Waters в NCSA, швейцарских систем CSCS Todi и Piz Daint. Потребителям пришлось ждать шесть месяцев, прежде чем GK110 появилась в виде GeForce. Карту назвали GTX Titan, отсутствие цифрового номера модели подтверждает желание Nvidia рассматривать ее как модель, отдельную от существующей (и, вероятно, следующей) серии Kepler. При цене 999 долларов Titan ориентирован на ультра-энтузиастов и бенчмаркеров. Nvidia также расширила привлекательность для исследователей и профессионалов с ограниченным бюджетом, поскольку впервые компания позволила карте GeForce сохранить ту же вычислительную функциональность, что и ее профессиональные собратья Tesla и Quadro.  Nvidia GeForce GTX Titan Карта быстро завоевала статус лидера в игровых бенчмарках, что особенно заметно в мультимониторных разрешениях с применением суперсэмплированного сглаживания. Однако неравнодушная поддержка драйверов OpenCL компанией Nvidia и всплеск числа последних игровых игр, связанных с программой Gaming Evolved от AMD, ослабили влияние Titan в той же степени, что и его непомерно высокая цена. В июне AMD сыграла в "я тоже", предложив HD 7970 GHz Edition - скачок частоты ядра на 75 МГц с последующим увеличением на 50 МГц (в отличие от динамически регулируемой версии, предлагаемой Nvidia). Версия GHz Edition представляет собой частоту, с которой карта, вероятно, должна была стартовать в январе. К сожалению для AMD, рынок, на который была нацелена эта SKU, уже определил, что стандартная модель в целом способна обеспечить такую же (если не лучшую) производительность с помощью разгона при значительно более низкой цене и более низком напряжении ядра. Вслед за HD 7970 GHz Edition компания AMD выпустила HD 7950 Boost. В 2013 году Nvidia и AMD, казалось, сражались за долю рынка дискретной графики, которая сокращалась по мере того, как разработка игр и разрешение экрана не соответствовали успехам интегрированной графики. В начале 2002 года Intel занимала 14% рынка графики для ПК. С появлением чипсетов Extreme Graphics (830-865) доля компании выросла до 33%, затем до 38% с чипсетами третьего и четвертого поколения DX 9, а к 2013 году эта цифра составила более 50% с серией DX10 GMA 4500. Интеграция графического процессора в CPU означала, что Intel отвечает за поставку около 60% графических решений для ПК. JPR: Доля рынка графических процессоров в 4 квартале 2012 года

Потребность в новых графических продуктах становилась все менее очевидной с каждым последующим поколением. В то время большинство игр базировалось на API десятилетней давности (DX 9 стал доступен в декабре 2002 года), поэтому улучшение изображения в играх все меньше ориентировалось на загрузку GPU и все больше на фильтрацию после обработки. Зависимость от растеризации сохранялась, поскольку трассировка лучей оказалась труднораскалываемым орешком - до сих пор, спустя много лет. Все это указывает на то, что любителям аппаратного обеспечения будет не с чем возиться, если только не произойдет фундаментальная эволюция игровых движков или не появятся доступные дисплеи сверхвысокого разрешения. В течение следующих нескольких лет мы продолжали делать обзоры графических процессоров на TechSpot и очень внимательно следили за эволюцией графики ПК. Это была четвертая часть нашей серии "История GPU". Пятая часть истории современного GPU была написана в 2021 году, ознакомьтесь с ней по ссылке ниже... |