Создание, модификация и сопровождение информационных систем, администрирование баз данных

Скачать 79.78 Kb. Скачать 79.78 Kb.

|

|

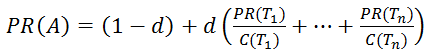

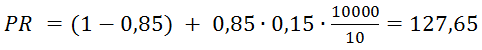

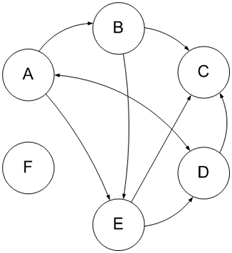

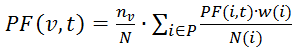

МИНИСТЕРСТВО СЕЛЬСКОГО ХОЗЯЙСТВА РОССИЙСКОЙ ФЕДЕРАЦИИ Федеральное государственное бюджетное образовательное учреждение высшего образования «КУБАНСКИЙ ГОСУДАРСТВЕННЫЙ АГАРАРНЫЙ УНИВЕРСИТЕТ имени И.Т.ТРУБИЛИНА» Факультет Прикладной информатики Кафедра Компьютерных технологий и систем КУРСОВАЯ РАБОТА Анализ поисковых систем в сети Интернет Направление подготовки: 09.03.02 Информационные системы и технологии Направленность: «Создание, модификация и сопровождение информационных систем, администрирование баз данных» Выполнил: КалайчидиАнастас Иванович группа ИТ2201 Руководитель: _ подпись ___________ Дата защиты _____________ _____________ Оценка _____________ _ подпись ____________Ф.И.О Краснодар 2022 СОДЕРЖАНИЕ ВВЕДЕНИЕ 3 ГЛАВА 1. ТЕОРЕТИЧЕСКИЕ ОСНОВЫ ПОИСКОВОЙ СИСТЕМЫ. 5 1.1Понятие поисковой системы 5 1.2 Задачи и цели поисковых систем 7 1.3 Принципы и состав работы поисковой системы 8 ГЛАВА 2. АЛГОРИТМЫ И ПРИНЦИПЫ РАБОТЫ ПОИСКОВЫХ СИСТЕМ. 13 2.1 Принцип работы Google 13 2.2 Принцип работы Яндекса 17 ЗАКЛЮЧЕНИЕ 25 СПИСОК ЛИТЕРАТУРЫ 27 ВВЕДЕНИЕИнтернет стал неотъемлемой частью жизни любого человека. Любой пользователь Интернета ежедневно ищет какую-то информацию, используя все возможности и преимущества поисковых систем интернета, что помогает быстрее найти нужную информацию. Для меня главными обстоятельствами в выборе темы «Анализ поисковых систем в сети Интернет», для моей курсовой работы, стали актуальность темы на сегодняшний день, а также достаточная открытость и известность мне этой темы, так как я часто пользуюсь всемирными сетями и поисковыми системами. Объём информации в интернете нарастает крайне быстро. Специалисты оценили, что информационный объём, транслируемый через сети интернета, возрастает вдвое примерно каждые полгода. Ежедневно в интернете возникают новые документы, и, естественно, их никто бы не обнаружил без специальных средств поиска. Возникла насущная потребность в создании таких средств, которые позволяли бы без больших проблем обнаруживать в Интернете именно ту информацию, что необходима пользователю в данный момент. Самым распространённым методом, который позволяет найти нужные данные в интернете, считается применение специальных поисковых систем. Поисковой системой является сайт, который осуществляет обнаружение, собирает и сортирует информацию в сети интернет. Поисковые системы считаются пользовательским инструментом, который позволяет ему обнаружить за минимальный временной промежуток необходимую информацию. Целью моей курсовой работы является изучение и анализ поисковых систем в сети интернет. Для реализации поставленной цели необходимо выполнить ряд задач: Изучить понятие поисковой системы; Рассмотреть задачи поисковых систем; Изучить работу алгоритма поиска информации; Изучить состав и принципы работы поисковой системы; Рассмотреть поисковые системы в настоящее время и т.д.; Сравнить несколько лучших систем, выявив сильные и слабые стороны каждой; Подвести итог полученным знаниям; При написании данной работы были использованы современные научные и учебные источники литературы. ГЛАВА 1. ТЕОРЕТИЧЕСКИЕ ОСНОВЫ ПОИСКОВОЙ СИСТЕМЫ.Понятие поисковой системыПоисковая система – это сайт, к которому пользователь обращается посредствам ключевого слова и находит интересующую его информацию. Сегодня поисковая система лучший способ, чтобы быстро и качественно найти интересующую вас информацию. Рассмотрим, как работает поисковая система, что само по себе довольно просто. Пользователь, который зашел на сайт системы, должен ввести в поисковое окно, ключевую фразу, располагающуюся на сайте, по этой фразе система ищет информацию, и нажатием кнопки «поиск», послать запрос. После всего, пользователю будет выдан список текстовых ссылок на сайты, которые соответствуют данному запросу. В этом заключается весь принцип работы поисковой системы со стороны пользователя. Теперь рассмотрим внутреннее устройство и весь процесс работы системы, не заметный для пользователя. В первые годы развития Интернета, численность его пользователей было небольшим, а количество информации, доступной пользователю, прилично маленьким. В основном в те годы выход в интернет имели зачастую сотрудники научно-исследовательской сферы. Но и надобность поиска информации в Интернете не столь уж актуальной, как на сегодняшний день. Создание открытых каталогов сайтов стало первым способом организации доступа к информационным ресурсам сети, в них по тематике группировались ссылки на ресурсы. Первым подобным проектом был сайт Yahoo.com, его открыли весной 1994 года. После увеличения количества сайтов в каталоге Yahoo, нужную информацию стало возможным искать по каталогу. В полном смысле это еще не представляло поисковую систему, потому что область поиска была ограничена непосредственно только ресурсами, которые присутствовали в каталоге, а не во всех ресурсах интернета. Каталоги ссылок были распространены и ранее, но в настоящее время почти полностью потеряли свою популярность. Потому что даже в самых огромных современных каталогах, есть информация только о мельчайшей части интернета. В сети один из самых больших каталогов DMOZ (он ещё называется OpenDirectoryProject) имеет информацию о 5 миллионах ресурсов, а если брать базу поисковой системы Google, то она состоит более чем из 8 миллиардов документов. Первая полноценная поисковая система была «WebCrawler», которая вышла в мир в 1994 году. Главное отличие этой поисковой системы от последователей заключается в предоставлении пользователю возможности осуществлять поиск на любой веб-странице, по любым ключевым словам. В настоящее время такая технология есть стандарт поиска любой поисковой системы. Таким образом, поисковая система «WebCrawler» стала первой системой, о которой знали не только ученые, но и широкий круг обычных пользователей. В 1995 году появились поисковые системы Lycos и AltaVista. В 1996 году AltaVista стала доступна русскоязычным пользователям, запустив морфологическое расширение для русского языка. В этом же году запущены такие отечественные поисковые системы как – «Rambler.ru» и «Aport.ru». Появились первые отечественные поисковые системы, и Рунет (интернет на русском языке) вышел на новый уровень, позволяя всем русскоязычным пользователям осуществлять запросы на русском языке, и оперативно реагировать на любые изменения, которые происходят внутри Сети. После того как в 1997 году запустили поисковую систему «Яндекс», очень сильно между собой начали конкурировать отечественные поисковые машины, они улучшают систему выдачи результатов, поиска и индексации сайтов, а стали предлагать новые сервисы и услуги. Сергей Брин и Ларри Пейдж в 1997 году, в рамках исследовательского проекта в Стэндфордском университете, создали поисковую машину Google. В настоящее время Google - самая популярная поисковая система в мире, именно она дала возможность пользователю осуществлять с учетом морфологии качественный и быстрый поиск, ошибок при написании слов, и в результатах выдачи запросов очень сильно повысила релевантность. На данный момент компания Google обрабатывает более 40 миллиардов запросов в месяц, это соответствует около 62,4 % из всех поисковых запросов в мире. 1.2 Задачи и цели поисковых системВсе поисковые системы объединены несколькими основными задачами, такими как поиск новых сайтов, оценка сайта и максимально точный ответ пользователю на запрос. Главная задача любой поисковой системы, предоставить пользователь ту информацию, которую он ищет. Но, к сожалению нельзя научить пользователя производить «правильные» запросы к системе, т.е. запросы, которые соответствуют принципу работы поисковых систем. Вот почему разработчикам нужно создавать такие принципы работы и алгоритмы поисковых систем, которые бы позволяли пользователям находить искомую ими информацию. Это значит, что поисковая система должна думать точно также как думает пользователь, когда ищет ту или иную информацию. Обращаясь к поисковой системе, пользователь надеется максимально просто и быстро найти интересующую его информацию. После получения результата, он оценивает работу системы, руководствуясь несколькими основными параметрами. Разработчики поисковых систем постоянно стараются совершенствовать алгоритмы и принципы поиска, пытаются всячески ускорить работу системы, добавляя новые функции и возможности, чтобы удовлетворить потребности пользователей. 1.3 Принципы и состав работы поисковой системыПоисковая машина – это аппаратно-программный комплекс, который осуществляет быстрый поиск внутри сервера или Интернет-ресурса необходимой информации. У всех поисковых систем основа поисковой машины примерна одинаковая. В основном, это программное обеспечение, отвечающее за ранжирование результатов по релевантности поискового запроса и составление каталога запроса, поисковый бот, который необходим для поиска сайта и индексации. Но некоторые крупные поисковые системы держат содержание своей поисковой машины в секрете. Основным отличием является учет и релевантность морфологии языка запроса, база проиндексированных сайтов. Все это в совокупности и определяет критерий качества работы поисковых машин. Поисковые машины классифицируются по области поиска информации: 1. Локальный поиск. Он предназначен, чтобы осуществлять поиск информации по всемирной сети какой-либо ее части, например, по локальной сети, либо по одному или нескольким сайтам. Таким примером являются внутренние серверы крупных компаний или поисковый скрипт на сайте. 2. Глобальный поиск. Он предназначен для того, чтобы искать информацию по региональной части, по группе сайтов, либо в сети Интернет и т.д. Именно глобальным поиском пользуются такие крупные поисковые системы как Яндекс, Google, Yahoo и т.д. Поисковые машины по сети интернет осуществляют различный поиск информации. Например, музыка, картинки, личная информация, географическое положение и т.д. Поисковая машина может работать с файлами различных форматов (например. html,.htm,.txt,.doc,.rtf, …), мультимедийного (видео, звука и другой информации) или графического (.gif, .png, .svg,) типа. Но самым распространенным поиском является поиск текстовых документов (документы в формате doc, rtf, txt, web-страницы и др.). Но с технологической точки зрения поиск по звукам, видео, изображениям является более сложным, поэтому он не реализован массово. Например, такие системы как Яндекс.Картинки ищут картинки по альтернативным текстам, соответствующим этим изображениям, а не по самим изображениям. А в компании Google каталог поиска картинок составляется вручную, это тормозит обновление баз изображений, но значительно увеличивает релевантность запроса. Модуль индексирования: Модуль индексирования состоит из трех вспомогательных программ (роботов): Spider (паук) – программа, которая предназначена для скачивания веб-страниц. «Spider» полностью обеспечивает скачивание страницы, и все внутренние ссылки извлекает с этой страницы. С каждой страницы скачивается html-код. Роботы используют протоколы HTTP для скачивания страниц. «Spider» работает следующим образом. Робот передает на сервер запрос «get/path/document» и несколько других команд HTTP-запроса. В ответ роботу приходит текстовый поток, который содержит сам документ и служебную информацию. Ссылки извлекаются из тэгов frame, base, area, frameset, и др. Многие роботы, наряду со ссылками, обрабатывают редиректы (перенаправления). Все страницы сохраняются в таких форматах как: дата, когда страница была скачана тело страницы (html-код) URL страницы http-заголовок ответа сервера Crawler («путешествующий» паук) – эта программа, автоматически проходит по всем ссылкам, которые нашла на странице. Выделяет все ссылки, присутствующие на странице. Его задача – состоит в том, чтобы исходя из заранее заданного списка адресов или основываясь на ссылках, определить, куда дальше должен идти паук. Crawler, осуществляет поиск новых документов, еще неизвестных поисковой системе, следуя по найденным ссылкам. Indexer (робот - индексатор) - это программа, анализирующая веб-страницы, которые скачали пауки. Индексатор, применяя собственные лексические и морфологические алгоритмы, разбирает страницу на составные части и анализирует их. Разные элементы страницы подвергаются анализу, например, заголовки, текст, специальные служебные html-теги, ссылки структурные и стилевые особенности, и т.д. Благодаря этому, модуль индексирования дает возможность извлекать ссылки на новые страницы из получаемых документов и производить полный анализ этих документов, обходить по ссылкам заданное множество ресурсов, скачивать встречающиеся страницы. База данных: Индекс поисковой системы или база данных - это информационный массив, в котором хранятся преобразованные параметры всех документов скачанных и обработанных модулем индексирования. Поисковый сервер: Поисковый сервер важнейший элемент всей системы, потому что скорость и качество поиска напрямую зависит от его алгоритмов, которые лежат в основе его функционирования. Работает поисковый сервер следующим образом: Запрос, который получен от пользователя подвергается морфологическому анализу. Генерируется информационное окружение каждого документа, содержащегося в базе (как раз оно и будет отображено в виде сниппета, т. е. текстовой информации соответствует запросу на странице выдачи результатов поиска). Все полученные данные передаются специальному модулю ранжирования в качестве входных параметров. После чего по всем документам происходит обработка данных, далее подсчитывается собственный рейтинг для каждого документа, который характеризует релевантность разных составляющих данного документа, хранящихся в индексе поисковой системы запроса, введенного пользователем. Этот рейтинг может быть составлен в зависимости от выбора пользователя дополнительными условиями (например, «расширенный поиск»). Далее генерируется сниппет, т. е., из таблицы документов извлекаются краткая аннотация, наиболее соответствующая запросу, заголовок и ссылка на сам документ для каждого найденного документа, и еще подсвечиваются все найденные слова. Пользователю результаты поиска, которые мы получили, передаются в виде SERP (SearchEngineResultPage) – страницы выдачи поисковых результатов. Все эти компоненты работают во взаимодействии и тесно связаны друг с другом, именно они образовывают тот самый довольно сложный механизм работы поисковой системы, который требует огромных затрат ресурсов. 1.4 Поисковые системы в наше время Во всем мире самые известные поисковые системы это: Google, Bing, Yahoo, Lycos, Ask, Baidu(лидер среди китайских поисковых систем). Русскоязычные — в основном все «русскоязычные» поисковые системы находят тексты и индексируют на нескольких языках — украинском, татарском, английском, белорусском и др. От «всеязычных» систем они отличаются тем, что практически всегда индексируют те ресурсы, которые расположены в доменных зонах, где на первом месте стоит русский язык и тем, что они своих роботов ограничивают русскоязычными сайтами другими способами. А всеязычные индексируют все документы подряд. В России основной поисковой системой является «Яндекс», далее - Rambler, Aport, Mail.ru, Нигма. По данным исследования который проводился в конце 2016 года доминирующие место в рейтинге стабильно занимает компания Google. В декабре на долю гиганта пришлось 41,3 миллиардов поисковых запросов, это – 62,4% рынка. Второе место (с большим отрывом) у Yahoo! – 8,5 миллиардов запросов, 12,8% рынка и крупнейшего китайского поисковика Baidu.com – 3,4 млрд. запросов, 5,2% рынка. К слову, уверенные позиции последнего связаны с тем, что на территории Китая заблокированы и Google, и Yahoo! ГЛАВА 2. АЛГОРИТМЫ И ПРИНЦИПЫ РАБОТЫ ПОИСКОВЫХ СИСТЕМ.2.1 Принцип работы GoogleАлгоритм ранжирования Google сложнее, чем алгоритм Яндекса. Продвигать сайты в Google, особенно на начальном этапе, немного сложнее. Раскрутка молодого сайта в Google затруднительна, так как на новые веб-ресурсы накладывается фильтр (так называемая «песочница»). Google при ранжировании использует порядка 200 факторов, оптимизатор может повлиять лишь на некоторые. С другой стороны, поисковая система Google выглядит стабильнее своих конкурентов в плане смены алгоритма и апдейтов. Информация, только что размещенная на сайте, может в считанные минуты попасть в основную выдачу. Поисковые роботы Google в три раза быстрее, чем роботы других поисковых систем. Фильтры (критерии «нормальности» сайта) почти не меняются с момента начала их внедрения. Контент и ссылки – вот два фактора, на которые может повлиять оптимизатор при продвижении сайта в поисковой системе Google. Релевантность контента относительно поискового запроса повышается следующим образом: простановка ключевых слов в заголовках (тегах title и h1 – h6). В title прописывается единственная ключевая фраза без лишних слов. Ключевые слова в начале html-кода страницы сайта так же увеличивает релевантность текста. Внешние ссылки Google учитывает по нескольким параметрам: количество, авторитетность сайта-донора (т.е. насколько поисковая система доверяет сайту), тематичность. Сквозные ссылки (ссылки, ведущие со всех страниц сайта-донора, устанавливаются, например, в шаблоне сайта) в глазах Google обладают большим весом, нежели 10 ссылок (с этого же сайта-донора). Сайт-акцептором называют сайт А, на который стоит ссылка с сайта B, а сайтом-донором – сайт B, который размещает ссылку на сайт A. Перед продвижением сайта в Google следует: В случае нового сайта сообщить поисковой системе по адресу: https://www.google.com/webmasters/tools/submit-url/ С помощью страницы «инструменты для веб-мастеров» https://www.google.com/webmasters/tools/home?hl=ru подтвердить права на сайт, создать файл sitemap.xml и добавить ссылку на карту сайта вида http://www.site.ru/sitemap.xml. Проверить код на валидность Проверить работоспособность всех ссылок на сайте, при необходимости исправить ошибки. Это позволит поисковому роботу Google полнее и точнее проиндексировать сайт и выделить заслуженное место на страницах своей выдачи. Понятие GooglePageRank является одним из ключевых моментов в работе поисковой машины Google. Наряду с другими параметрами, влияющими на выдачу (сортировку) сайтов в результатах поиска, знание модели PageRank необходимо как для понимания процесса поиска, так и для использования оптимизаторами при продвижении своих сайтов в поисковой системе. PageRank (далее просто PR) это числовая величина — мера “важности” страницы в поисковой системе Google. Зависит от числа внешних ссылок на данную страницу и от их веса (важности). Другими словами от количества и качества ссылающихся страниц. А если говорить математическим языком, то PR – это алгоритм расчёта авторитетности страницы, используемый поисковой системой Google (Рис.1). PR не является основным, но является одним из вспомогательных факторов при ранжировании сайтов в результатах поиска. Следует отметить, что при расчете PR Google учитывает не все ссылки, а отфильтровывает ссылки с сайтов, специально предназначенных для скопления ссылок. Некоторые ссылки могут не только не учитываться, но и отрицательно сказаться на ранжировании ссылающегося сайта (такой эффект называется поисковой пессимизацией). Основной формулой для расчета PR является формула (Рис.1):  Рисунок 1 –формула для расчета PR где PR(Ti ) – значение PageRank для страницы; d – демпфирующий коэффициент, отражающий какую долю веса может передать страница-донор на страницу-акцептор. Обычно его принимают равным 0.85, что означает, что страница может передать 85% веса (распределяется между всеми акцепторами, на которые ссылается донор). В других источниках d является вероятностью, с которой пользователь перейдет на один из акцепторов, а не закроет браузер, что, в принципе, то же самое. Какое числовое значение у этого параметра знают только в Google, остальные из экспериментальных данных принимают его равным 0,85; n – количество страниц, ссылающихся на страницу-акцептор (на которые не наложен фильтр); Ti – i-ая ссылающаяся страница; C(Ti) – количество ссылок на странице-доноре Ti . Поскольку ссылающихся страниц может быть много, и общее количество страниц в поисковой системе Google достаточно велико (около десятка биллионов штук), а также их количество постоянно растет, то представлять вес страницы в абсолютных значениях для вебмастеров было бы весьма неправильно. Для этого ввели понятие TLPR — ToolBarPageRank– значение PR, который имеет значение от нуля до 10 (шкала в GoogleToolbar). Для того, чтобы уложить все веса страниц между значениями от нуля до 10 используют логарифмическую шкалу. Определяется ToolBarPageRank по формуле: где base – основание логарифма, которое зависит от количества страниц в поисковой машине (возможно и от ряда других факторов). Некоторые принимают его равным 7; a – некий коэффициент приведения, который удовлетворяет неравенству 0 Из вышесказанного неверно делать выводы, что нулевой TLPR означает нулевой реальный PageRank. По формуле PR видно, что даже при n=0 , мы получим минимальный PRmin =(1-d)=0,15. Это значение соответствует TLPR≈-1. При таких (отрицательных) значениях тулбарного PR считается что PR=N/A (или еще не определен), однако он также оказывает влияние на распределение веса между ссылками-акцепторами. Также следует заметить, что тулбарное значение предназначено только для отображения вебмастерам в GoogleToolbar и никак не влияет на позицию в выдаче. На позицию в выдаче влияние оказывает реальный PR страницы. [10] Исходя из принципов расчета GooglePageRank, можно теперь легко рассчитать, с каких ссылок нужно ссылаться и сколько нужно ссылок, чтобы получить тот или иной PR. Также можно прогнозировать PR. Один из важных выводов заключается в следующем: если у нового сайта более 10000 страниц (число страниц зависит от количества ссылок с них на другие страницы), они правильно перелинкованы и каждая ссылается на главную страницу, то главная страница получит хороший вес от этих ссылок. Учитывая, что минимальный PR равен 0,15 и в среднем на одной странице 10 ссылок, для такого сайта вычисляется по формуле PR (Рис.2): Рисунок 2 – Пример формулы PR А ToolBarPageRank по формуле TBPR (Рис.3):  Рисунок 3 –формула расчета TBPR Это пример хорошего PR без единой внешней ссылки с других сайтов. Таким образом, существует множество способов повышения веса своих страниц, но главная идея — это качественные ссылки с других сайтов. Для этого можно использовать каталоги, социальные закладки, статьи, форумы, блоги и другие типы сайтов. Однако не следует глупо расставлять множество ссылок на других сайтах, так как помимо PageRank существует множество других ранков, влияющих на выдачу страницы в результатах поиска (напримерTrustRunk). Отрицательного PR не бывает. Реальный PR минимум равен 0,15, минимальный тулбарный PR равен нулю. Ссылки на своем сайте на другие сайты ставить необходимо, так как своими ссылками вы увеличиваете PR страниц-акцепторов и тем самым, по первой формуле, к вам возвращается еще больший вес из огромной системы ссылок. На значение PageRank влияет только количество и качество ссылающихся ресурсов. С картинок PageRank “перетекает”, только если они являются ссылками, по которым пользователь может перейти на другой ресурс. 2.2 Принцип работы ЯндексаОсновой работы поисковых систем как Google, так и Яндекс является система кластеров. Вся информация делится на определенные области, которые относятся к тому или иному кластеру. Индексация сайтов с целью получения данных о размещенной на них информации выполняется роботами-сканерами. Существуют следующие виды сканирующих роботов: основной робот-сканер и робот-сканер, отвечающий за сбор информации на ресурсах с частым обновлением содержания. Второй тип сканирующего робота предназначен для быстрого обновления списка проиндексированных ресурсов и значения их индексов в поисковой системе. Для наиболее полного обеспечения сбора информации в системе Яндекс применяются обновления базы поиска и обновления программного кода: База поисковой информации обновляется несколько раз в течение месяца, при этом на поисковые запросы выдается обновленная информация с сайтов. Такая информация добавляется с помощью основного робота-сканера. При обновлении программного кода или «движка» выявляются недостатки и изменяются алгоритмы, отвечающие за ранжирование ресурсов в поисковой системе. Как правило, перед выходом таких обновлений Яндекс публикует соответствующие анонсы. Основная особенность системы Яндекс, делающая популярной ее среди русскоязычных пользователей, – это способность определять различные словоформы с учетом морфологических особенностей русского языка. При этом значения запроса с помощью геотаргетинга и формул поиска преобразуется в максимально точную формулировку. Кроме того, Яндекс отличается алгоритмом по определению релевантности индексируемых страниц (релевантностью называют соотношение содержания веб-страницы к содержанию поискового запроса). Также к положительным сторонам можно отнести высокую скорость ответной реакции на запросы и устойчивую, без перегрузок, работу серверов. Большое значение для поисковой системы имеют динамические ссылки, наличие которых может привести к отказу от индексации ресурса поисковым роботом. В процессе индексации Яндекс распознает текстовую информацию в документах с расширениями: .pdf, .rtf, .doc, .xls, .ppt. Последние два относятся к программам входящими в комплект MicrosoftOffice: Excel и PowerPoint. При индексировании сайта поисковая система считывает данные из файла robots.txt, при этом поддерживается атрибут Allow и часть метатегов, а метатегиRevisit-After и Keywords игнорируются. Так как сниппеты – краткие описания текстовых документов – составляются из фраз на искомой странице, то использование описания в теге не является обязательным, но может использоваться в отдельных случаях. По заявлениям разработчиков кодировка индексируемых документов определяется автоматически, а значит, и метатег кодировки не имеет большого значения. Поисковая система большое значение придает показателю последнего изменения информации (Last-Modified). Если сервер не будет передавать эту информацию, то процесс индексации данного ресурса будет происходить намного реже. Пока что остается нерешенной проблема страниц, использующих фреймовые структуры, но она может быть обойдена с помощью скриптов, отправляющих пользователей поисковой системы в нужное место сайта. Если у сайта существуют «зеркала» (например, http://www.site.ru, http://site.ru, https://www.site.ru, https://www.site.ru), необходимо принять соответствующие действия для исключения их из процесса индексации. Если индексацию «зеркал» избежать не удалось, можно «склеить» их путем внесения необходимой информации в robots.txt. В случае попадания сайтов в Яндекс.Каталог система будет идентифицировать их как заслуживающих отдельного внимания, что может повлиять на продвижение сайтов. Также это способствует упрощению процедуры определения тематики сайта, что в свою очередь означает получение сайтом значимой внешней ссылки. Команда поисковой системы Яндекс держит в секрете IP-адреса своих роботов. Но в лог-файлах отдельных сайтов можно встретить текстовые пометки, оставленные поисковыми роботами Яндекс. Одними из самых интересных роботов-сканеров поисковой системы Яндекс можно назвать: Yandex/1.01.001 (compatible; Win16; I) – основной робот, занимающийся непосредственно индексацией сайтов; Yandex/1.01.001 (compatible; Win16; P) – робот-индексатор изображений; Yandex/1.01.001 (compatible; Win16; H) – робот, который выявляет «зеркала» индексируемых сайтов; Yandex/1.02.000 (compatible; Win16; F) – робот-индексатор пиктограмм ресурсов (favicons); Yandex/1.03.003 (compatible; Win16; D) – робот, который обращается к страницам, добавленным с помощью формы «Добавить URL»; Yandex/1.03.000 (compatible; Win16; M) – задействуется при переходе на страницу посредством ссылки «Найденные слова»; YaDirectBot/1.0 (compatible; Win16; I) – этот робот отвечает за индексацию страниц ресурсов, принимающих участие в рекламной сети Яндекс. Из всех поисковых роботов самый важный так и называется – основной поисковый робот. От того, как он проиндексирует страницы сайта, будет зависеть значимость ресурса для поисковой системы. Работа всех роботов происходит по индивидуальному расписанию, и если сайт проиндексирован одним из них, то это не значит, что скоро будет произведена индексация и другим. В помощь основным созданы и роботы, которые периодически посещают сайты и устанавливают, насколько те доступны. К таким можно отнести роботов «Яндекс.Каталога» и рекламной сети Яндекс. Для поисковой системы Яндекс характерны следующие основные показатели внешней оптимизации: тИЦ – это общедоступный тематический индекс цитирования, он не оказывает прямого влияния на ранжирование и используется для определения позиций в тематической категории Яндекс.Каталога; применяется, когда необходима раскрутка сайта, тИЦ показывает, какое количество ссылок, в среднем, обращается к сайту. вИЦ, или взвешенный Индекс Цитирования, представляет собой алгоритм для подсчета количества внешних ссылок; значение его не разглашается и используется поисковой системой как определяющее при ранжировании сайтов в поисковой системе. Присутствие сайта в «Яндекс.Каталоге». Общее число страниц сайта, принявших участие в индексации. Частота, с которой индексируется содержимое сайта. Наличие и отсутствие ссылок с сайта, присутствие сайта в поисковых фильтрах. Индекс цитирования создает основу для тематического и взвешенного индекса цитирования, которые влияют на ранжирование сайта. Индекс цитирования (ИЦ) — это указатель цитирований (количества ссылок на источник) между публикациями, позволяющий узнать, какие из более поздних документов ссылаются на более ранние работы, при этом, ИЦ может рассматриваться как для отдельных статей, так и для авторов (ученных). В поисковой системе Яндекс, а также в других поисковых системах, под индексом цитирования подразумевается количество обратных ссылок, без учета ссылок со следующих ресурсов: немодерируемых каталогов, досок объявлений, сетевых конференций, страниц серверной статистики, XSS ссылки и другие, которые могут добавляться без контроля со стороны владельца ресурса. Стоит отметить, что в каталоге Апорт под ИЦ понимается взвешенный индекс цитируемости. Рассчитывается этот индекс из ссылочного графа: если рассматривать ресурсы сети как вершины графа, а цитирование других ресурсов (ссылочные связи между сайтами) как связи вершин графа (ребра), тогда ссылочный граф можно представить в виде диаграммы, как показано на следующем рисунке (Рис.4).  Рисунок 4 – ссылочный граф На рисунке буквами А, B, …, F обозначены определенные сайты в индексе поисковой системы, стрелки изображают направление связей — односторонние либо двусторонние. ИЦ используется как один из факторов для ранжирования документов в поисковой выдаче, но не является главным. Не стоит путать обычный индекс цитирования с взвешенным и тематическим, о которых будет написано позже. Индекс цитируемости всегда целое число и не зависит от тематик ссылающихся документов. Индекс цитируемости обычно рассматривается в качестве параметра значимости статьи, однако он не отражает структуру ссылок в каждой дисциплине (тематике), а также слабозначимые работы и труды с большой значимостью могут иметь одинаковый индекс цитируемости. Поэтому был введен взвешенный индекс цитирования, который определяется не только количеством, но и качеством ссылающихся источников. Введение ссылочного поиска и статической ссылочной популярности помогает поисковым системам справляться с примитивным текстовым спамом, который полностью разрушает традиционные статистические алгоритмы информационного поиска, полученные в свое время для контролируемых коллекций. ВИЦ является аналогом PageRank от Google. Взвешенный индекс цитирования, как и другие ссылочные факторы ранжирования, рассчитывается из ссылочного графа. Узнать вИЦ для своих страниц вы можете приблизительно, проверив их PageRank любым онлайн-сервисом проверки, однако, следует учесть, что в индексе Яндекса присутствуют только русскоязычные документы, а из зарубежных лишь некоторые популярные, таким образом, урезая ссылочный граф по сравнению с Google. Тематический индекс цитирования введен для отражения авторитетности сайта в своей тематике. При определении тематики сайта сначала строится описание рассматриваемого ресурса (из названия категорий сайта, заголовков, структуры URL его страниц). Далее вычисляется оценка близости между описаниями заранее подготовленных тематик (каталог) и описаниями ресурсов с выбором наиболее близких тематик для них. Тематическая близость двух документов отражает вероятность принадлежности их обоих одной и той же тематике. Этот показатель может влиять на значение передаваемого ссылкой веса. Расчет тИЦ основан на формуле (Рис.5):  Рисунок 5 –расчет тИЦ по формуле PR где PF(v,t) – тИЦ ресурса v; P – количество ресурсов, которые ссылаются на сайт v и имеют ту же тематику; nv– количество страниц на рассматриваемом сайте v; N – общее число страниц в индексе Яндекса (при этом, nv/N — вероятность того, что пользователь читает сайт v); w(i) – частота цитируемости ресурсом i сайта v; N(i) – общее число ссылок на i-ом сайте. При этом, PF(v,t) является нормализованной величиной. Изначально тематический индекс цитирования отражал ситуацию в Рунете, но со временем индекс Яндекса расширился на такие географические сегменты, как Беларусь, Украина и другие. В Яндексе появились новые версии каталога для дополнительных регионов. Соответственно, чтобы ранжировать сайты в каждом из региональных Яндекс.Каталогов, потребовалось ввести региональный тИЦ, который учитывает, помимо тематической, географическую близость ссылок. Таким образом, тИЦ обладает следующими свойствами: 1. тИЦ зависит от количества уникальных страниц на сайте и чем их больше, тем больше результирующий показатель. 2. Чем меньше исходящих ссылок на сайте-доноре, тем больше с него передается тИЦ. 3. тИЦ никак не зависит от перелинковки. 4. Анкоры ссылок не участвуют в определении тематической близости двух ресурсов. При наличии у сайта нескольких зеркал (копий), при их склейке результирующий тИЦ суммируется. ЗАКЛЮЧЕНИЕВ наше время информация играет огромную роль во всех сферах жизнедеятельности. Людям, имеющим дело с большими объемами текстов - это и новости, и подшивки газет в электронном виде, и электронная почта, и Web-страницы, важно быстро находить в этом море информации действительно нужную. Без помощи поисковой системы это было бы нереально. Благодаря удобству в обращении и хорошим техническим характеристикам, различные поисковые системы могут помочь в этом и новичку, и опытному пользователю. Поисковые системы и существующие к ним приложения, способны облегчить работу представителей многих профессий: Web-мастера, аналитика, руководителя, лингвиста. Информационный бум продолжается, происходит дальнейшее развитие электронно-компьютерных технологий, а следовательно и в будущем без поисковых систем обойтись будет крайне сложно. Итак, первоочередная задача любой поисковой системы – доставлять людям именно ту информацию, которую они ищут. Основные характеристики, которыми должны обладать поисковые системы: Полнота – Представляет собой отношение количества найденных по запросу документов к общему числу документов в сети Интернет, удовлетворяющих данному запросу. Точность – Определяется степенью соответствия найденных документов запросу пользователя. Актуальность – Характеризуется временем, проходящим с момента публикации документов в сети Интернет, до занесения их в индексную базу поисковой системы. Скорость поиска – Скорость поиска тесно связана с его устойчивостью к нагрузкам. Посетитель желает получить результаты как можно быстрее, а поисковая машина должна отрабатывать запрос максимально оперативно, чтобы не тормозить вычисление следующих запросов. Наглядность – Наглядность представления результатов является важным компонентом удобного поиска. По большинству запросов поисковая машина находит сотни, а то и тысячи документов. Вследствие нечеткости составления запросов или неточности поиска, даже первые страницы выдачи не всегда содержат только нужную информацию. Это означает, что пользователю зачастую приходится производить свой собственный поиск внутри найденного списка. Как показывает статистика, пользователи русскоязычной части Интернета предпочитают несколько поисковых машин. Прежде всего, это мультиязычная платформа Google, являющаяся своеобразным эталонов универсального поискового механизма. Чуть менее популярный поисковик — Yahoo! - объединяет не одну, а целых 3 поисковых машины (Inktomi, AltaVista, Alltheweb). Лидер среди русскоязычных поисковых систем — Яндекс — индексирует документы форматов pdf, rtf, doc, txt, swf, rss и так далее. С помощью Яндекса можно искать информацию на русском, английском, украинском, белорусском, румынском, немецком и французском языках. Rambler — оценивает преимущественно посещаемость Интернет-страниц. Соответственно, чтобы оказаться в верхних строчка рейтинга Rambler, необходимо обеспечить своему сайту постоянный приток посетителей. В настоящее время, практически каждая поисковая система имеет свои механизмы расчета рейтинга Интернет-страниц, и алгоритмы эти постоянно изменяются, совершенствуются. Однако в целом можно сказать, что наибольшее внимание современные поисковики уделяют внешним критериям оценки релевантности. СПИСОК ЛИТЕРАТУРЫАлехин, В.А. Микроконтроллеры PIC: основы программирования и моделирования в интерактивных средах MPLAB IDE, mikroC, TINA, Proteus. Практикум / В.А. Алехин. - М.: ГЛТ , 2016. - 248 c. Архангельский, А.Я. Язык Pascal и основы программирования в Delphi / А.Я. Архангельский. - М.: Бином-Пресс, 2015. - 496 c. Ашарина, И.В. Основы программирования на языках С и С++: Курс лекций для высших учебных заведений / И.В. Ашарина. - М.: ГЛТ, 2012. - 208 c. Биллиг, В.А. Основы программирования на С#: Учебное пособие / В.А. Биллиг. - М.: Бином, 2012. - 483 c. Богачев, К.Ю. Основы параллельного программирования / К.Ю. Богачев. - М.: Бином, 2015. - 342 c. Воскобойников, Ю.Е. Основы вычислений и программирования в пакете MathCAD PRIME: Учебное пособие / Ю.Е. Воскобойников и др. - СПб.: Лань, 2016. - 224 c. Гавриков, М.М. Теоретические основы разработки и реализации языков программирования: Учебное пособие / М.М. Гавриков, А.Н. Иванченко, Д.В. Гринченков. - М.: КноРус, 2010. - 184 c. Гулиа, Н.В. Основы вычислений и программирования в пакете MathCAD PRIME: Учебное пособие / Н.В. Гулиа, В.Г. Клоков, С.А. Юрков. - СПб.: Лань, 2016. - 224 c. Дакатт, Дж. Основы веб-программирования с использованием HTML, XHTML и CSS / Дж. Дакатт. - М.: Эксмо, 2010. - 768 c. Дорогов, В.Г. Основы программирования на языке С: Учебное пособие / В.Г. Дорогов, Е.Г. Дорогова; Под общ. ред. проф. Л.Г. Гагарина. - М.: ИД ФОРУМ, НИЦ ИНФРА-М, 2013. - 224 c. Емельянов, В.И. Основы программирования на Delphi. / В.И. Емельянов. - М.: Высшая школа, 2005. - 231 c. Желонкин, А. Основы программирования в интегрированной среде Delphi / А. Желонкин. - М.: Бином. Лаборатория знаний, 2004. - 236 c. |