Лекция 14 Модели каналов связи. Лекция 14. Модели каналов связи Характеристики дискретного канала связи

Скачать 410.28 Kb. Скачать 410.28 Kb.

|

|

Лекция 14. Модели каналов связи Характеристики дискретного канала связи Влияние шумов на пропускную способность дискретного канала связи Однородный двоичный симметричный канал Однородный симметричный канал со стиранием Модель потока ошибок в дискретных каналах Использование информации для решения каких-либо задач, безусловно, сопряжено с необходимостью ее распространения, т. е. осуществления процессов передачи и приема. При этом приходится решать проблему согласования метода кодирования с характеристиками канала связи, а также обеспечить защиту передаваемой информации от возможных помех и искажений. Н  апомним обобщенную схему передачи информации по линии связи (рис. 1). Рис. 1. Обобщенная структурная схема системы передачи дискретных сообщений (передачи данных) На рис.1 обозначены:

1. Источник дискретных сообщений – физический объект, система или явление, формирующие передаваемое сообщение. Значительная часть передаваемых сообщений по своей природе не является сигналами – это массивы чисел, текстовые или иные файлы и тому подобное. 2. Кодер источника – Большинство исходных сообщений подвергаются эффективному кодированию (сжатию) с целью согласования с параметрами канала. Целью кодированияисточникаявляетсяпреобразованиеразличныхсообщенийводнообразнуюформу, упрощающуюпроцесспередачи, атакжесокращениеобъемаинформациисцельюповышенияскоростиеепередачиили сокращенияполосычастот, требуемыхдляпередачи. 3. Скремблер (от англ. to scramyle – перемешивать, шифровать) – это алгоритм, разработанный для побитной последовательной передачи информации, позволяющий зашифровать цифровой поток таким образом, что на выходе получается последовательность, обладающая свойствами случайной: равновероятным появлением нуля и единицы. Такое преобразование потока не меняет скорость передачи, а также является обратимым. 4. Кодер канала – устройство (программа), обеспечивающее надежную передачу закодированного сообщения источника по линии связи, в которой из-за действия помех и других факторов возможны ошибки в передаче, а именно искажения отдельных символов кодовых последовательностей и, в том числе, стирания. 5. Перемежитель – фундаментальный компонент помехоустойчивого кодирования, предназначенный для борьбы с пакетированием ошибок, использующий перемешивание (перемежение) символов передаваемой последовательности на передаче. 6. Модулятор – преобразует закодированные сообщения в высокочастотные радиосигналы, свойства которых позволяли бы передавать их по радиоканалу связи. Процедуру модуляции иногда называют наложением сообщения на сигнал, выступающий в качестве переносчика информации. Модуляция называется посимвольной, если сигнал, соответствующий кодовому слову, представляет собой последовательность элементарных сигналов, соответствующих отдельным символам кодового слова Непрерывный канал связи – совокупность устройств и физических сред, обеспечивающих на определенном временном интервале передачу непрерывного сигнала. Помеха – воздействие нежелательной энергии, вызванное одним или несколькими излучениями или индукциями, на приём в системе связи, проявляющееся в любом ухудшении качества, ошибках или потерях информации, которых можно было бы избежать при отсутствии такой нежелательной энергии. Демодулятор – устройство, предназначенное для выделения информационного сигнала из модулированного высокочастотного колебания. Деперемежитель – компонент помехоустойчивого декодирования, предназначенный для восстановление структуры перемеженных символов принятой последовательности на приёме. Декодер канала – осуществляет декодирование, в результате которого получаем комбинацию исходного кода. Часто кодер и декодер канала называют устройством защиты от ошибок (УЗО). Дескремблер – устройство, предназначенное для восстановления исходной структуры цифрового сигнала, преобразованного скремблером Декодер источника – Декодирует эффективные коды. Присутствует в схеме только при наличии кодера источника. Получатель дискретного сообщения – физический объект, система или явление, получающее передаваемое сообщение. Дискретный канал – канал, предназначенный для передачи только дискретных сигналов (цифровых сигналов данных). преобразует кодовые символы в физические сигналы, удобные для передачи по линии связи. Канал передачи данных – средства для двухстороннего обмена данными между источником и получателем сообщений. Характеристики дискретного канала связи Обратим внимание, что дискретность — это не свойство канала связи, а свойство передаваемых по нему сигналов!  Каналы для передачи информации могут иметь самую разнообразную физическую природу (по виду среды распространения сигнала электросвязи различают проводные каналы передачи, организованные по воздушным линиям связи (ВЛС), кабельным линиям (КЛС) (симметричного и коаксиального кабеля) и волоконно-оптическим линиям (ВОЛС), каналы радиосвязи, организованные по радиорелейным и спутниковым линиям связи). Однако нас не будут интересовать механизмы, приводящие к возможным изменениям сигналов при их передаче по каналу — это позволяет рассматривать канал как некий «черный ящик», на вход которого подается последовательность сигналов и какая-то последовательность получается на выходе (рис. 2). Каналы для передачи информации могут иметь самую разнообразную физическую природу (по виду среды распространения сигнала электросвязи различают проводные каналы передачи, организованные по воздушным линиям связи (ВЛС), кабельным линиям (КЛС) (симметричного и коаксиального кабеля) и волоконно-оптическим линиям (ВОЛС), каналы радиосвязи, организованные по радиорелейным и спутниковым линиям связи). Однако нас не будут интересовать механизмы, приводящие к возможным изменениям сигналов при их передаче по каналу — это позволяет рассматривать канал как некий «черный ящик», на вход которого подается последовательность сигналов и какая-то последовательность получается на выходе (рис. 2).Источник дискретных сообщений (ИДС) использует для представления информации первичный алфавит {x}. Кодер источника (КИ) кодирует знаки первичного алфавита n элементарными сигналами с алфавитом {y}. Вследствие воздействия помех в процессе передачи алфавит принимаемых сигналов может отличаться от алфавита входных сигналов, как их числом так и характеристиками — пусть это будет алфавит {y}, содержащий m элементарных сигналов. Несовпадение алфавитов сигналов приводит к тому, что на выходе канала появляются такие комбинации элементарных сигналов, которые не могут быть интерпретированы как коды знаков первичного алфавита. Вводя количественные характеристики процесса передачи информации, постараемся выделить из них те, которые зависят только от свойств канала, и те, которые определяются особенностями источника дискретного сообщения. Дискретный канал считается заданным, если известны: • время передачи одного элементарного сигнала τ; • исходный алфавит элементарных сигналов {x}, т. е. все его знаки xi, i = 1 . . . n, где n — число знаков алфавита {x}; • n значений вероятностей появления элементарных сигналов на входе p(xi); эти вероятности называются априорными (поскольку они определяются не свойствами канала, а источником сообщения, т.е. являются внешними по отношению к каналу и самому факту передачи сообщения); • алфавит сигналов на выходе канала {y}, т. е. все знаки yj, j = 1, ... , m, где m — число знаков алфавита {y}; в общем случае n m; • значения условных вероятностей p(yj|xi), каждая из которых характеризует вероятность появления на выходе канала сигнала yj при условии, что на вход был послан сигнал xi; поскольку эти вероятности определяются свойствами самого канала передачи, они называются апостериорными; очевидно, количество таких вероятностей равно nm:  Очевидно также, что для каждой строки выполняется условие нормировки:  Как мы увидим в дальнейшем, все остальные характеристики дискретного канала могут быть определены через перечисленные параметры. Дискретный канал называется однородным, если для любой пары i и j условная вероятность p(yj|xi) с течением времени не изменяется (т. е. влияние помех все время одинаково). Дискретный канал называется каналом без памяти, если p(xi) и p (yj|xi) не зависят от места знака в первичном сообщении (т.е. отсутствуют корреляции знаков). Если все переданные сигналы прошли канал без искажений, то такой канал называется идеальным (без шума). Если все переданные сигналы на приемном конце были заменены протиповоложными, то канал называется идеальным инвертирующим. Будем считать, что для передачи используются колебательные или волновые процессы — с практической точки зрения такие каналы представляют наибольший интерес (в частности, к ним относятся компьютерные линии связи). Введем ряд величин, характеризующих передачу информации по каналу. Длительность элементарного импульса. Будем считать, что передача информации в канал осуществляется элементарными импульсами, совокупность которых и образует алфавит сигналов на входе {x}. При двоичном кодировании, очевидно, таких сигналов два – 0 (пауза) и 1 (импульс). Будем считать также, что их длительность одинакова и составляет τ. Из этого, в свою очередь, следует, что передача ведется на фиксированной частоте (она называется также несущей)  и означает в свою очередь, что за 1 с в канал могут быть посланы νm сигналов. Если код знака первичного алфавита состоит из ki элементарных сигналов, время его передачи по каналу составит ti = kiτ, а среднее время передачи кодовой комбинации одного знака первичного алфавита t = K(A, x)τ. Пропускная способность канала связи. С передачей одного элементарного сигнала связано некоторое количество информации Is. Если общее число различных элементарных сигналов n, а вероятности их появления p(xi), i = 1, . . . , n, то согласно формуле Шеннона  Как мы неоднократно убеждались ранее, данная величина зависит от распределения вероятностей знаков; своего максимального значения она достигает при условии, что появление всех элементарных сигналов (знаков вторичного алфавита) будет равновероятным – в таком случае Is = Ismax = log2 n. Это значение является предельным (наибольшим) для информационного содержания элементарного сигнала выбранного вторичного алфавита. Поскольку такое количество информации передается за время τ, можно ввести величину, характеризующую предельную интенсивность информационного потока через канал, – пропускную способность канала

Данная величина является характеристикой канала связи, поскольку зависит только от его особенностей. Это выражение служит определением пропускной способности как идеального канала (без помех), так и реального канала с помехами — просто, как мы увидим далее, информационное содержание элементарного сигнала в реальном канале оказывается меньше log2 n. Если Ismax выражено в битах, а τ — в секундах, то единицей измерения C будет бит/с. Производными единицами являются: 1 Кбит/с = 103 бит/с; 1 Мбит/с = 106 бит/с; 1 Гбит/с = 109 бит/с. При отсутствии в канале связи помех Ismax = log2 n; тогда

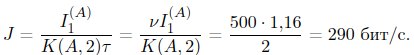

– максимально возможное значение пропускной способности (это обстоятельство отражено индексом «0»). В реальном канале Ismax ≤log2 n и, следовательно, C ≤C0. Пропускной способность канала связи – максимально возможная скорость передачи по этому каналу, которая обеспечивается при источнике с максимальной энтропией. Еще раз подчеркнем, пропускная способность – характеристика канала связи. Для дискретного канала она зависит от технической скорости передачи, которая ограничивается полосой пропускания канала, и от потерь информации. Последние зависят от помех, действующих в канале, способов обработки сигналов в передатчике и приемнике, а также и от технической скорости передачи. Скорость передачи информации. Если источник выдает νm элементарных сигналов в единицу времени, а средняя длина кода одного знака составляет K(A, x), то, очевидно, отношение νm /K(A, x) будет выражать число знаков первичного алфавита, выдаваемых источником за единицу времени. Если с каждым из них связано среднее количество информации I(X), то можно найти общее количество информации, передаваемой источником за единицу времени — эта величина называется скоростью передачи или энтропией источника (будем обозначать ее J):

Согласно первой теореме Шеннона при любом способе кодирования  хотя может быть сколь угодно близкой к этому значению. Следовательно, всегда J ≤ C0, т. е. Скорость передачи информации по каналу связи не может превысить его пропускной способности. В этом результате нет ничего неожиданного: представьте трубу, через которую за единицу времени может проходить объем воды C, и источник, выдающий J воды за это же время; ясно, что если трубу присоединить к источнику, то вода не будет теряться только в том случае, если C J. Как показано в теории Шеннона, данное утверждение справедливо как при отсутствии в канале помех (шумов) (идеальный канал связи), так и при их наличии (реальный канал связи). Пример. Первичный алфавит состоит из трех знаков с вероятностями p1 = 0,2; p2 = 0,7; p3 = 0,1. Для передачи по каналу без помех используются равномерный двоичный код. Передача ведется на частоте 500 Гц. Каковы пропускная способность канала и скорость передачи? Поскольку код двоичный, n = 2, а из (2) C0 = 500 бит/с. Число знаков первичного алфавита N = 3. I(X) = I1 = −0,2 log2 0,2 − 0,7 log2 0,7 − 0,1 log2 0,1 = 1,16 бит, K(A, 2) >log2 N = 2. Следовательно, получаем  Влияние шумов на пропускную способность дискретного канала связи Математическая постановка задачи Используем для анализа процесса передачи информации по дискретному каналу с помехами энтропийный подход. Если считать опытом Xотправку сигнала, а Y— получение его из канала, то величина I(X, Y) выражает собой информацию, которая содержится в сигнале Xотносительно полученного сигнала Y: I(X, Y) = H(Y) − H(Y|X). Cледует сделать несколько замечаний. 1. Ситуация H(Y|X)= 0 (выходные сигналы совпадают с входными) соответствует идеальному каналу без помех. 2. Если Xи Yнезависимы, т. е. отсутствует связь между сигналами на входе и выходе канала, то H(Y|X)= H(Y) и информация не передается. 3. Потери информации при передаче характеризуются апостериорными вероятностями, входящими в выражение для H(Y|X) 4. Ранее было показано, что I(X, Y) = I(Y, X), т. е. Xсодержит относительно Yто же количество информации, что и Yотносительно X. Следовательно,

Сущность задачи о передаче информации по реальному каналу состоит в том, чтобы построить заключение о том, какой сигнал Xбыл отослан в случае приема Y. Пусть опыт Yсостоит в выяснении того, какой сигнал был получен на приемном конце канала; исходами этого опыта являются сигналы yj, общее число которых равно m. Опыт Xсостоит в выяснении того, какой сигнал был послан на вход канала; исходами этого опыта являются сигналы, образующие алфавит xi; их общее количество равно n. Смысл выражения (4) в применении к рассматриваемой ситуации состоит в том, что распознанный на приемном конце сигнал содержит информацию о сигнале, который был отправлен, но в общем случае информацию не полную. Влияние помех в канале таково, что в процессе передачи часть начальной информации теряется и исход опыта Yне несет полной информации относительно предшествующего исхода опыта X. Энтропия, связанная с определением того, какой сигнал передан  Hн(X|Y) – условная энтропия (энтропия опыта Xпри условии, что реализовался опыт Y):   Окончательно для средней информации на один элементарный сигнал имеем (5)  Часто бывает удобнее воспользоваться подобным же соотношением, которое получается на основе равенства I(Y, X) = I(X, Y) = H(Y) − Hα(Y|X) Тогда (6)  Таким образом, для определения информации сигнала на приемном конце канала необходимо знание априорных и апостериорных вероятностей. Справедливо и обратное утверждение: знание априорных и апостериорных вероятностей позволяет установить (вычислить) информацию, связанную с переданным сигналом. Как уже указывалось, апостериорные вероятности определяются свойствами канала связи, а априорные – особенностями источника (точнее, кодера). Следовательно, воспользовавшись (5) или (6) и варьируя значения p(ai) в допустимых по условию задачи пределах, можно найти наибольшее значение max{I(Y, X)}. Тогда

Полученное выражение определяет порядок решения задачи о нахождении пропускной способности конкретного канала: 1) исходя из особенностей канала, определить априорные и апостериорные вероятности; 2) варьируя p(xi) и пользуясь (5), найти максимальное информационное содержание элементарного сигнала; 3) по (7) вычислить пропускную способность. Пример. Пусть в канале отсутствуют помехи или они не препятствуют передаче. Тогда m = n, сигналы на приемном конце совпадают с отправленными. Это означает, что апостериорные вероятности p(xi|yj) = 1 при i = j и p(yj|xi) = 0 при i j. B этом случае H(X|Y) = 0 и, следовательно, max{I(Y, X)}= = max{H(X)}= log2 n (это значение достигается, если появление всех входных сигналов равновероятно). Из (6) получаем C = νm log2 n, что совпадает с (3). Тем самым показано, что определение (3) пропускной способности канала без помех является частным случаем более общего определения (6). Рассмотрим некоторые примеры каналов передачи информации с помехами. Однородный двоичный симметричный канал Пусть на вход канала подаются сигналы двух типов (0 и 1 — например, импульс и пауза) и они же принимаются на выходе, т. е. {x}= {b}, m = n. Пусть, далее, вероятность ошибки передачи для обоих сигналов одинакова и равна p; такой канал называется двоичным симметричным (относительно инверсии 0 ↔ 1). Если вероятность ошибки p, то для дополнительных событий вероятность безошибочной передачи равна 1 − p. Применяя принятые выше обозначения для апостериорных вероятностей, можно записать p0(1) = p1(0) = p; p0(0) = p1(1) = 1 − p, Этим соотношениям может быть дана графическая интерпретация (рис. 3) (он называется графом канала). Линии со стрелками указывают, в какие принимаемые сигналы могут перейти те, что отправлены на входе; рядом со стрелками указаны вероятности соответствующих переходов.  Найдем пропускную способность канала, воспользовавшись определением (7). Оно, в свою очередь, требует вычисления I(Y, X) (или I(X, T)) и установления ее максимума как функции p. Если по-прежнему опыт Xсостоит в распознавании сигнала на входе канала, а опыт Y— на выходе, с учетом того, что y1 = x1, а y2 = x2, и воспользовавшись выражением (6), получаем Найдем пропускную способность канала, воспользовавшись определением (7). Оно, в свою очередь, требует вычисления I(Y, X) (или I(X, T)) и установления ее максимума как функции p. Если по-прежнему опыт Xсостоит в распознавании сигнала на входе канала, а опыт Y— на выходе, с учетом того, что y1 = x1, а y2 = x2, и воспользовавшись выражением (6), получаемH0(Y) = H1(Y) = −(1−p) log2(1−p)−p log2 p. и H(Y|X) = p(0)H0(Y) + p(1)H1(Y) = = {p(0) + p(1)}{−(1 − p) log2(1−p)−p log2 p}= = −(1−p) log2(1−p)−plog2 p, поскольку p(0)+p(1) = 1 как достоверное событие. Другими словами, в рассматриваемом канале энтропия H(Y|X) не зависит от значений p(0) и p(1), а определяется только вероятностью искажений сигнала при передаче. Следовательно, C = νm max{H(Y)+(1−p) log2(1−p) + p log2 p}. Поскольку m=2, max{H(Y)}= 1. Таким образом, окончательно для пропускной способности симметричного двоичного канала имеем C(p) = νm{1 + (1 − p) log2(1 − p) + p log2 p}.  График функции C(p)/C0 изображен на рис. 4. Максимального значения равного νm функция C(p) достигает при p = 0 (очевидно, это означает отсутствие помех) и при p = 1 — это соответствует ситуации, когда канал полностью инвертирует входные сигналы (т.е. заменяет 0 на 1, а 1 на 0) — это не служит препятствием для однозначной идентификации посланного сигнала по принятому и, следовательно, не снижает пропускной способности канала. Во всех остальных ситуациях 0 График функции C(p)/C0 изображен на рис. 4. Максимального значения равного νm функция C(p) достигает при p = 0 (очевидно, это означает отсутствие помех) и при p = 1 — это соответствует ситуации, когда канал полностью инвертирует входные сигналы (т.е. заменяет 0 на 1, а 1 на 0) — это не служит препятствием для однозначной идентификации посланного сигнала по принятому и, следовательно, не снижает пропускной способности канала. Во всех остальных ситуациях 01 и C(p)<νm. Наконец, при p=0,5 пропускная способность становится равной 0 – это вполне естественно, поскольку вероятность искажения 0,5 соответствует ситуации, при которой независимо от того, какой сигнал был послан, на приемном конце с равной вероятностью может появиться любой из двух допустимых сигналов. Ясно, что передача в таких условиях оказывается невозможной. Поскольку канал двоичный, согласно (3) νm = C0. Проведя соответствующую замену, получим

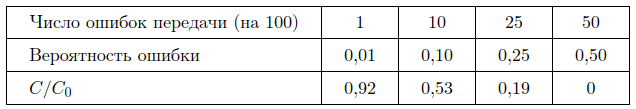

Выражение в фигурных скобках не превышает 1, следовательно, справедливо соотношение C C0, т.е. можно считать доказанным, что наличие помех снижает пропускную способность (и даже может сделать ее равной 0). Пример. Каково отношение C/C0, если средняя частота появления ошибки при передаче сообщения в двоичном симметричном канале составляет 1 ошибочный сигнал на 100 переданных? Очевидно, вероятность появления ошибки передачи p = 0,01. Следовательно, из (8) получаем C/C0 = 1 + p log2 p + (1 − p) log2(1 − p) ≈ 0,9192, т. е. пропускная способность канала снизилась приблизительно на 8 %. Следует заметить, что отношение C/C0 убывает при увеличении вероятности искажения довольно быстро, что иллюстрируется таблицей:  Отдельно следует обсудить вопрос, каким образом может быть установлен факт, что канал является симметричным и как определить вероятность искажения. Эти данные не вытекают ни из какой теории и могут быть получены только опытным путем.  На вход в канал подаются большое количество (для обеспечения заметной статистики) чередующихся сигналов 0 и 1 (рис. 5), а на приемных концах подсчитывается, сколько пришло тех или иных сигналов. Если число искаженных сигналов на обоих приемных концах одинаково (близко), то можно делать вывод о симметричности канала. Отношение количества искаженных (ошибочных) импульсов к числу отправленных, очевидно, даст вероятность искажения. На вход в канал подаются большое количество (для обеспечения заметной статистики) чередующихся сигналов 0 и 1 (рис. 5), а на приемных концах подсчитывается, сколько пришло тех или иных сигналов. Если число искаженных сигналов на обоих приемных концах одинаково (близко), то можно делать вывод о симметричности канала. Отношение количества искаженных (ошибочных) импульсов к числу отправленных, очевидно, даст вероятность искажения.Однородный симметричный канал со стиранием Снова рассмотрим двоичный канал (на входе сигналы 0 и 1 с вероятностями появления p(0) и p(1) соответственно). Допустим, что на приемном конце любой из них с вероятностью p может быть интерпретирован как противоположный, но, помимо этого, с вероятность q искажения в канале оказываются такими, что из-за конечной точности приемника принятый знак не идентифицируется ни с одним из поступающих на вход. B таком случае можно считать, что принят новый сигнал s, появление которого следует интерпретировать как пропажу (стирание) входного сигнала (как если бы при переписывании мало разборчивого текста все непонятные буквы мы заменяли бы каким-то знаком) – по этой причине канал назван двоичным симметричным со стиранием. По-видимому, вероятность стирания q > p, поскольку это событие требует меньшего искажения исходного сигнала, чем его инверсия. Апостериорные вероятности в этом случае составят: p0(0) = p1(1) = 1 − p − q; p0(1) = p1(0) = p; p0(s) = p1(s) = q. Граф канала будет показан на рис. 6.  Для определения пропускной способности вновь, как и при решении предыдущей задачи, воспользуемся соотношением (6). Для определения пропускной способности вновь, как и при решении предыдущей задачи, воспользуемся соотношением (6). Расчет условной энтропии дает: H0(y) = H1(y)=−(1−p−q) log2(1−p−q)−plog2 p−qlog2 q; H(Y|X) = p(0)H0(y)+p(1)H1(y) = = {p(0) + p(1)}{−(1 − p − q) log2(1 − p − q) − p log2 p − q log2 q}= = {−(1−p−q) log2(1−p−q)−p log2 p−q log2 q}; вновь учтено, что p(0)+p(1) = 1 как достоверное событие. Таким образом, I(X, Y) = H(X)+(1−p−q) log2(1−p−q)−p log2 p−q log2 q. Поскольку H (Y|X) не зависит от значений априорных вероятностей, I(X, Y) достигает максимума при таких p(0) и p(1), когда наибольшее значение приобретает энтропия H(Y). Для нахождения H(Y) необходимо знать вероятности всех сигналов, появляющихся на выходе из канала (обозначим эти вероятности qj, j = 0, 1, 2). Вероятность появления s (стирания) уже установлена: q2 = q. Для 0 вероятность q0 =p(0)(1−p−q)+p(1)p; аналогично для 1 находим q1 = p(1)p + p(1)(1−p−q). Тогда H(Y) = −q1 log2(q1)−q2 log2 q2 −q log2 q. Поскольку q определяется особенностями канала и не зависит от априорных вероятностей сигналов на входе, наибольшим H(Y) будет при максимальном значении выражения −q1 log2 q1 −q2 log2 q2, причем при любых p(0) и p(1) справедливо q1 + q2 = = 1 − q. Можно показать, что указанное выражение достигает максимума при условии q1 = q2 = 0,5(1 − q). Тогда   Окончательно для пропускной способности двоичного симметричного канала со стиранием имеем C = νm{(1−q)[1−log2(1−q)]+(1−p−q) log2(1−p−q) + p log2 p}. Проанализируем полученный результат C = C(p, q): C будет уменьшаться при увеличении как p, так и q. Если вероятности p и q отличны от 0, то, как видно из полученного выражения, C < C0. В реальных двоичных каналах со стиранием p  В тех ситуациях, когда p пренебрежимо мала и единственным искажением оказывается стирание сигнала, пропускная способность оказывается равной C=νm(1−q). График этой функции представлен на рис. 7. В тех ситуациях, когда p пренебрежимо мала и единственным искажением оказывается стирание сигнала, пропускная способность оказывается равной C=νm(1−q). График этой функции представлен на рис. 7. Полученный результат представляется вполне закономерным: при p = 0 из νm двоичных сигналов, передаваемых по каналу за единицу времени, в среднем νmq будет «стираться», но при этом остальные νm(1−q) сигналов будут на приемном конце расшифровываться без потерь, и с каждым из них связан ровно 1 бит информации. Заканчивая рассмотрение характеристик реального дискретного канала передачи информации, следует сделать следующие заключения. 1. Помехи, существующие в реальном канале связи, приводят к снижению его пропускной способности (по сравнению с аналогичным каналом без помех). 2. Пропускная способность реального канала может быть рассчитана по известным априорным и апостериорным вероятностям. Для их определения требуются статистические исследования передачи информации в канале. Модель потоков ошибок в дискретном канале 5.1 Общая характеристика моделей потоков ошибок Вектором ошибки называют поразрядную разность (для двоичного сигала по mod2) между принятой кодовой комбинацией Bn и переданной An: modm (AnBn)En, тогда Bn= modm(En+ An) При передаче двоичным кодом кодовые комбинации представляют совокупность 0 и 1, а суммирование производится по модулю 2. Двоичный симметричный канал представляют как сумматор по модулю 2, к которому подключены источник сообщений и источник ошибок. Оба источника выдают двоичные последовательности длиной n. Будем обозначать символы в последовательности ошибок ei. Каждый элемент последовательности {e} складывается с соответствующим элементом последовательности, поступающей от источника сообщений {a}, в двоичном канале по модулю 2 (рис. 8). В дискретных каналах различают – r-кратные ошибки (каналы с независимыми ошибками); – пакеты ошибок (зависимые или группирующиеся ошибки). Пакеты – это последовательность нескольких искажённых символов: B = A + e, если е = 0 – ошибки нет, если е = 1 – есть ошибка. Число ошибочных элементов определяет вес вектора ошибок ||E||.  Пример. Пусть на вход ДК поступает последовательность 10011011, на выходе имеем последовательность 11010111. Вывод: на передаваемый сигнал воздействовала некоторая помеха, что привело к искажению. Отдельных символов. Математически это записывается следующим образом: Пример. Пусть на вход ДК поступает последовательность 10011011, на выходе имеем последовательность 11010111. Вывод: на передаваемый сигнал воздействовала некоторая помеха, что привело к искажению. Отдельных символов. Математически это записывается следующим образом: 10011011 – вектор входного сигнала аi 10011011 – вектор входного сигнала аi01001000 – вектор ошибки ei  11010111 – вектор выходного сигнала bi 11010111 – вектор выходного сигнала biЧисло ошибочных элементов определяет вес вектора ошибок. Для рассматриваемого примера вес вектора ошибок ||E||=2.  Группа ошибок, ограниченная двумя крайними ошибочными элементами, называется пакетом (пачкой) ошибок. Группа ошибок, ограниченная двумя крайними ошибочными элементами, называется пакетом (пачкой) ошибок.Длина L пачки ошибок – важный параметр, так как его используют при выборе помехоустойчивых кодов. В примере на рис. 9 L=5. Если ошибки при приёме отдельных символов кодовой комбинации происходят независимо друг от друга c вероятностью p, то вероятность безошибочного приёма кодовой комбинации из n элементов будет равна (1-p)n , а вероятность ошибочного её приёма равна значению 1-(1-p)n. Вероятность одновременного числа ошибок t в информационной последовательности определяется значением pt . Вероятность того, что в комбинации, имеющей n разрядов, n–t элементов не искажены, составляет (1-p)n–t . Следовательно, вероятность одного заданного сочетания ошибок t в nразрядной последовательности составляет величину pt (1-p)n–t. Общее количество возможных комбинаций t-кратных ошибок в n-разрядной комбинации составляет  Отсюда вероятность наличия в комбинации из n разрядов t ошибок в любом сочетании равна  = = При независимом распределении ошибок свойства канала по выходу как источника ошибок {ei} задаются единственным параметром – вероятностью ошибки р на символ. Кроме независимых ошибок в канале могут возникать группирующиеся ошибки. Они образуются в каналах с памятью. Одной из основных причин таких ошибок являются перерывы, возникающие из-за плавного снижения уровня сигнала ниже порога чувствительности приёмника, когда приём сигнала фактически прекращается. Перерывы могут быть различной длительности, и некоторые из них способны даже вызывать прекращение сеанса связи. Кроме этого, причиной перерывов могут быть неисправности в аппаратуре, несовершенство её эксплуатации, проведение измерений и др. Перерывы и импульсные помехи являются основной причиной появления группирующихся ошибок при передаче дискретных сообщений по различным видам каналов связи. Импульсные помехи – это помехи, сосредоточенные по времени. Они представляют собой случайную последовательность импульсов, имеющих случайные амплитуды и следующих друг за другом через случайные интервалы времени, причём вызванные ими переходные процессы, не перекрываются во времени. Причины появления этих помех: коммутация соединений в электронной аппаратуре, наводки с высоковольтных линий, грозовые разряды, прием отраженных сигналов и т.п. |