Развертывающие нейронные сети. Развертывающие нейронные сети (deconvolutional networks, dn)

Скачать 263.81 Kb. Скачать 263.81 Kb.

|

|

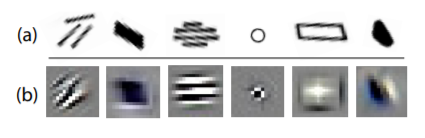

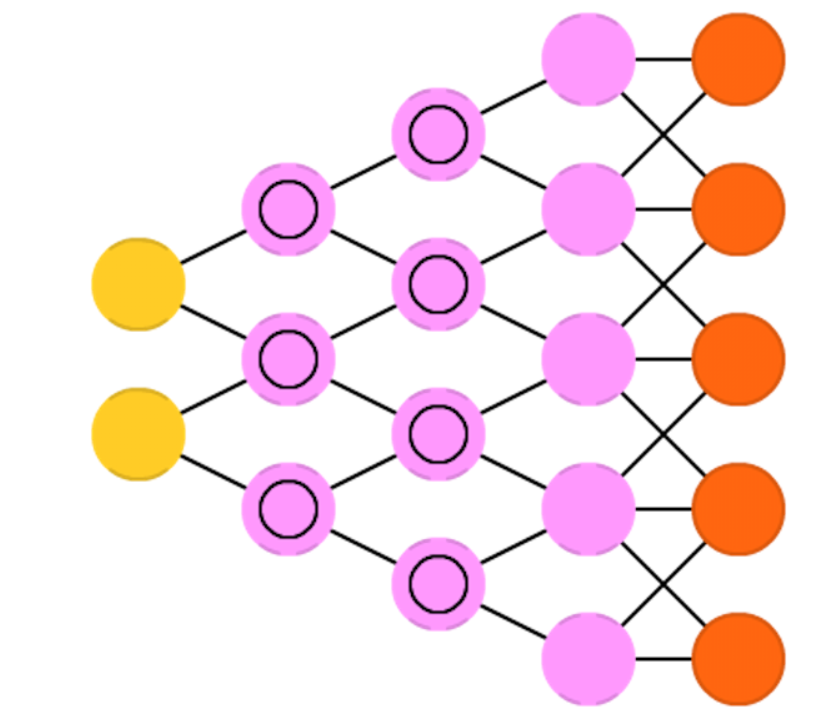

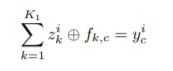

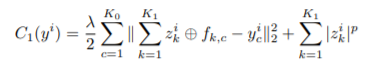

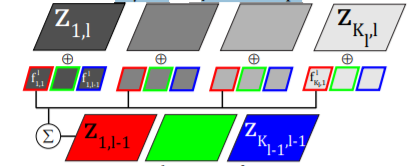

МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РОССИЙСКОЙ ФЕДЕРАЦИИ ФЕДЕРАЛЬНОЕ ГОСУДАРСТВЕННОЕ БЮДЖЕТНОЕ ОБРАЗОВАТЕЛЬНОЕ УЧРЕЖДЕНИЕ ВЫСШЕГО ОБРАЗОВАНИЯ «УФИМСКИЙ ГОСУДАРСТВЕННЫЙ НЕФТЯНОЙ ТЕХНИЧЕСКИЙ УНИВЕРСИТЕТ» Филиал ФГБОУ ВО УГНТУ в г. Стерлитамаке Кафедра АТИС Реферат на тему: «Развертывающие нейронные сети (deconvolutional networks, DN)» по дисциплине: «Система искусственного интеллекта» Выполнил: студент гр. БАТп-18-31 Р.М. Каиров Проверила: д.т.н., профессор Е.А. Муравьева Стерлитамак 2021 Введение В данной работе мы предлагаем деконволюционные сети, структуру, которая позволяет строить иерархические представления изображений. Эти представления могут быть использованы как для низкоуровневых задач, таких как денуазирование, так и для высокоуровневых, а также для распознавания объектов. Каждый уровень структуры группирует информацию с нижележащего уровня, чтобы, формировать более сложные характеристики, которые существуют в большем масштабе в изображении. Наш механизм группировки - это разреженность: поощряя простые представления на каждом уровне структуры, признаки естественным образом собираются в более сложную систему структуры, признаки естественным образом собираются в более сложные структуры. Однако, как мы показываем, малочисленности самой по себе недостаточно - для достижения желаемого эффекта она должна быть развернута в правильной архитектуре. Мы используем конволюционный подход, поскольку он обеспечивает стабильные скрытые представления на каждом уровне, которые сохраняют локальность и, таким образом, облегчают поведение группировки. Используя одни и те же параметры для обучения каждого слоя, наша деконволюционная сеть (DN) может автоматически извлекать богатые характеристики, которые соответствуют концепциям среднего уровня, таким как пересечения краев, параллельные линии, кривые и основные геометрические элементы, такие как прямоугольники. Примечательно, что некоторые из них очень похожи на лексемы, среднего уровня предложенные Марром в его теории первичных эскизов (см. рис. 1). Предлагаемая нами модель похожа по духу на конволюционные сети ЛеКуна и других, но совершенно иная по принципу работы.  Рисунок – 1. "Жетоны" с рис. 2-4 из книги "Видение" Д. Марра. Эти идеализированные локальные группировки предлагаются в качестве промежуточного уровеня представления в теории первичных эскизов Марра. (b): Выбранные фильтры из 3-го слоя нашей деконволюционной сети, обученной без наблюдения на реальных изображениях. Конволюционные сети - это подход "снизу-вверх", при котором входной сигнал подвергается нескольким слоям сверток, нелинейностей и субдискретизации. В отличие от этого, каждый слой в нашей деконволюционной сети нисходящий; он стремится генерировать входной сигнал путем суммы сверток карт признаков (в отличие от входного сигнала) с обученными фильтрами. Учитывая входной сигнал и набор фильтров, вывод активаций карт признаков требует решения многокомпонентной задачи деконволюции, которая является сложной с вычислительной точки зрения. В ответ на это мы используем ряд инструментов из низкоуровневого зрения, такие как разреженные критерии изображений и эффективные алгоритмы для размытия изображений. Соответственно, наша работа является попыткой связать высокоуровневое распознавание объектов с низкоуровневыми задачами, такими как размытие изображений, посредством унифицированной архитектуры. 1. Описание и способы работы сети. Развёртывающие нейронные сети (deconvolutional networks, DN), также называемые обратными графическими сетями, — это свёрточные нейронные сети наоборот. Представьте, что вы передаёте сети слово “кошка” и обучаете ее генерировать картинки кошек путем сравнения получаемых картинок с реальными изображениями кошек. DNN тоже можно объединять с FFNN. Стоит заметить, что в большинстве случаев сети передаётся не строка, а бинарный классифицирующий вектор: например, <0, 1> — это кошка, <1, 0> — собака, а <1, 1> — и кошка, и собака. Вместо слоев объединения, которые часто встречаются в CNN, здесь присутствуют аналогичные обратные операции, обычно интерполяцию или экстраполяцию.  Рисунок 2 – Пример развертывающей нейронной сети Деконволюционные сети тесно связаны с рядом методов "глубокого обучения" из сообщества машинного обучения, которые пытаются извлечь структуры признаков из данных. Глубокие сети доверия (DBN) и структуры разреженных автокодеров, как и наш подход, жадно строят слои от изображения вверх не контролируемым образом. В этих подходах каждый слой состоит из кодера и декодера. Кодер обеспечивает отображение снизу-вверх из входного пространства в пространство латентных признаков, а декодер отображает латентные признаки обратно во входное пространство, надеясь получить реконструкцию, близкую к исходному входу. Переход от входных данных непосредственно к латентному представлению без использования кодировщика затруднен, поскольку для этого требует решения проблемы вывода (несколько элементов в латентные характеристики конкурируют за объяснение каждой части входных данных). Поскольку эти модели были мотивированы на улучшение высокоуровневых задач, таких как распознавание, кодер необходим для того, чтобы, выполнять быстрый, но весьма приблизительный вывод для вычисления скрытого представления во время тестирования. Однако во время обучения латентное представление, полученное в результате выполнения нисходящего вывода с помощью декодера, ограничивается тем, что оно близко к выходу кодера. Поскольку кодеры обычно являются простыми нелинейными функциями, они способны существенно ограничить получаемое латентное представление, создавая неоптимальные характеристики. Ограниченные машины Больцмана (RBM), базовый модуль DBN, имеют дополнительное ограничение на то, что кодер и декодер должны иметь общие веса. В деконволюционных сетях кодер отсутствует: непосредственно решается проблема вывода с помощью эффективных методов оптимизации. Мы надеемся, что благодаря точному вычислению характеристик (а не приблизительному). Большинство архитектур глубокого обучения не являются сверточными, но, недавняя работа ученых. продемонстрировали сверточную архитектуру RBM, которая обучает высокоуровневым характеристикам изображений для распознавания. Это наиболее похожий подход на нашу деконволюционную сеть, с основным отличием в том, что мы используем модель только декодера, а не симметричного кодера-декодера RBM. Эта работа также связана с недавними работами в области разреженных изображений декомпозиции, а также структурных представлений. Ученые предложили эффективные схемы для обучения разреженным сверхполным разложениям изображений, используя выпуклый член разреженности `1. Наш подход отличается тем, что мы выполняем разреженное разложение по всему изображению сразу, а не только для небольших пятен. Как показали наши эксперименты, это крайне важно для изучения богатых характеристик. Ключ к тому, чтобы сделать это эффективным является использование конволюционного подхода. Был предложен целый ряд структурных моделей изображений. Особенно актуальна работа Жу и коллег, в частности, Гуо и др. Здесь края составляются с помощью созданного вручную набора маркеров изображения в крупномасштабные структуры изображений. Группировка выполняется с помощью поиска базиса со сложными операциями разделения и слияния на краях изображения. Стохастические грамматики изображений Жу и Мамфорда также используют фиксированные примитивы изображений, а также сложную цепь Маркова Монте-Карло (MCMC)-основанную схема для разбора сцен. Наша работа отличается двумя важными Во-первых, мы обучаемся лексемам изображений полностью автоматически. Во-вторых, наша схема вывода намного проще, чем ни одна из вышеупомянутых схем. Так же они предлагают модель частей и структуры "сверху вниз", но в ней учитываются только края изображения, предоставляемые в отличие от нашей модели, которая оперирует непосредственно пикселями. Биологически вдохновленная модель HMax от Serre и другие используют шаблоны образцов в своих промежуточных представлениях, а не учат конъюнкции краев, как это делаем мы, Фидлер и Леонардис предлагают нисходящую модель для распознавания объектов, которая имеет явное понятие частей, соответствие которых явно обосновывается на каждом уровне. В отличие от этого, наш подход просто выполняет низкоуровневую операцию деконволюции на каждом уровне, а не пытается решить проблему соответствия. Амит и Геман и Джин и Геман применяют структуры модели для деформированных цифр Latex и распознавания автомобильных номеров. 2. Модель Сначала мы рассмотрим один слой деконволюционной сети применяемый к изображению. Этот слой принимает на вход изображение  состоящее из состоящее из  цветовых каналов цветовых каналов  . Мы представляем каждый канал C этого изображения как линейную сумму . Мы представляем каждый канал C этого изображения как линейную сумму  латентных карт признаков латентных карт признаков  свернутых с фильтрами   1) 1)В дальнейшем, если не указано иное, символы соответствуют матрицы. Если  изображение изображение  , а фильтров H x H, о латентные карты признаков имеют размер , а фильтров H x H, о латентные карты признаков имеют размер  . Однако уравнение 1 представляет собой недоопределенную систему, поэтому для того, чтобы получить уникальное решение, мы вводим регуляризирующий член на . Однако уравнение 1 представляет собой недоопределенную систему, поэтому для того, чтобы получить уникальное решение, мы вводим регуляризирующий член на  который поощряет разреженность в латентных картах признаков. Это дает нам общую функцию затрат вида: который поощряет разреженность в латентных картах признаков. Это дает нам общую функцию затрат вида: 2) 2)где мы предполагаем гауссовский шум на члене реконструкции и некоторую разреженную норму  для регуляризации. Обратите внимание, что разреженная норма для регуляризации. Обратите внимание, что разреженная норма  - это фактически норма - это фактически норма  на векторизованной версии матрицы на векторизованной версии матрицы  , ,  . Обычно . Обычно  хотя возможны и другие значения хотя возможны и другие значения  это константа, которая уравновешивает относительный вклад реконструкции это константа, которая уравновешивает относительный вклад реконструкции  и разреженности карты признаков и разреженности карты признаков  . . Обратите внимание, что наша модель по своей природе нисходящая: учитывая латентные карты признаков, мы можем синтезировать изображение. Но в отличие от разреженного автокодирующего подхода Ранзато или подхода DBN, здесь нет механизма для генерации карт признаков из входных данных, кроме минимизации функции стоимости функция C1. Многие подходы сосредоточены на умозаключениях снизу-вверх, но мы концентрируемся на получении высококачественных латентных представлений.  Рисунок 3 – Слой 1, карты характеристик Один слой деконволюционной сети (лучше всего просматривается в цвете). Для наглядности показана только связность для одной входной карты показана. На практике первый слой полностью связан, в то время как связность более высоких слоев задается картой  которая является разреженной. которая является разреженной.СПИСОК ИСПОЛЬЗОВАННЫХ ИСТОЧНИКОВ 1. https://habr.com/ru/company/wunderfund/blog/313696/ 2. https://www.matthewzeiler.com/mattzeiler/deconvolutionalnetworks.pdf 3. https://searchenterpriseai.techtarget.com/definition/deconvolutional-networks-deconvolutional-neural-networks |