ЛР5 искусственный интеллект. Двухслойный персептрон

Скачать 1.44 Mb. Скачать 1.44 Mb.

|

|

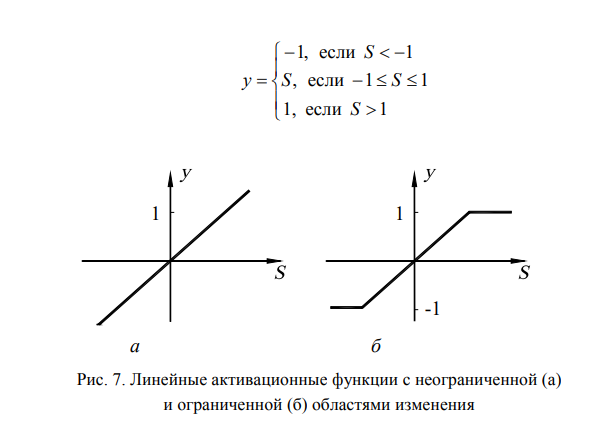

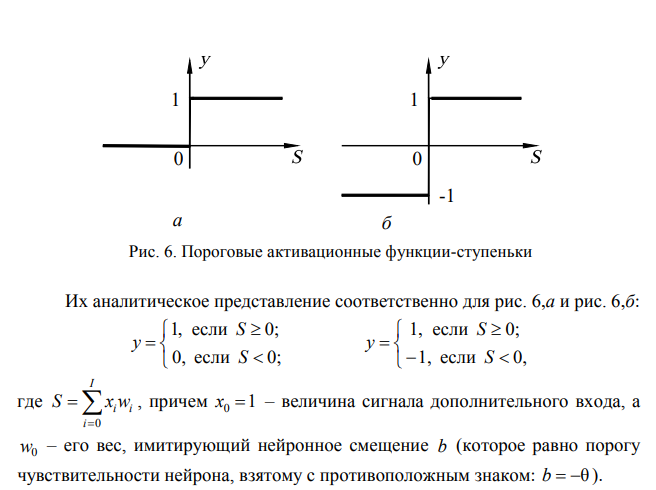

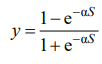

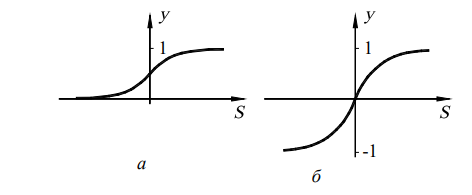

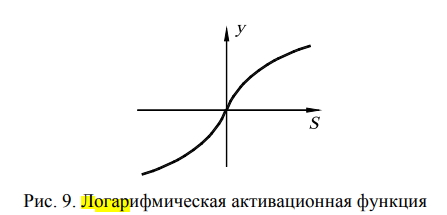

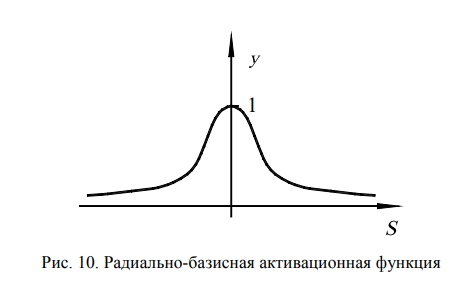

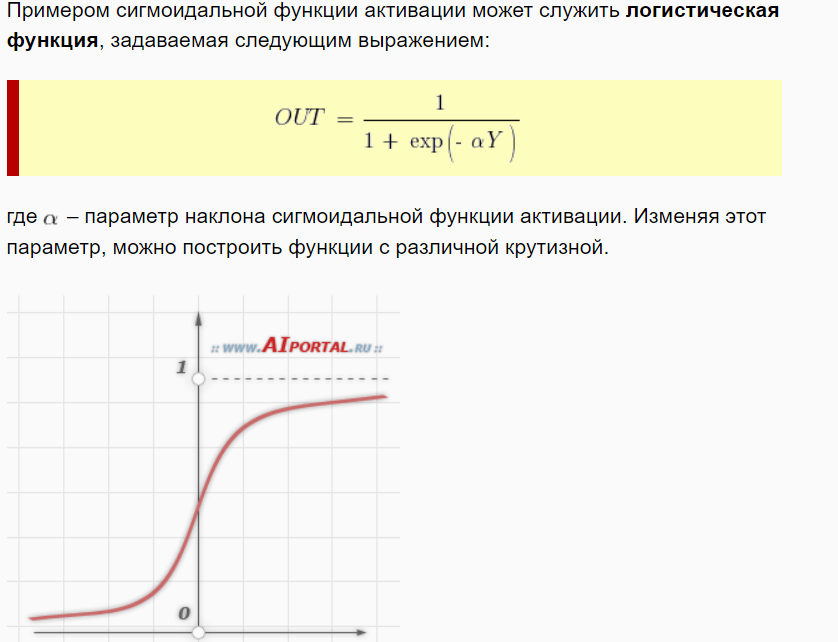

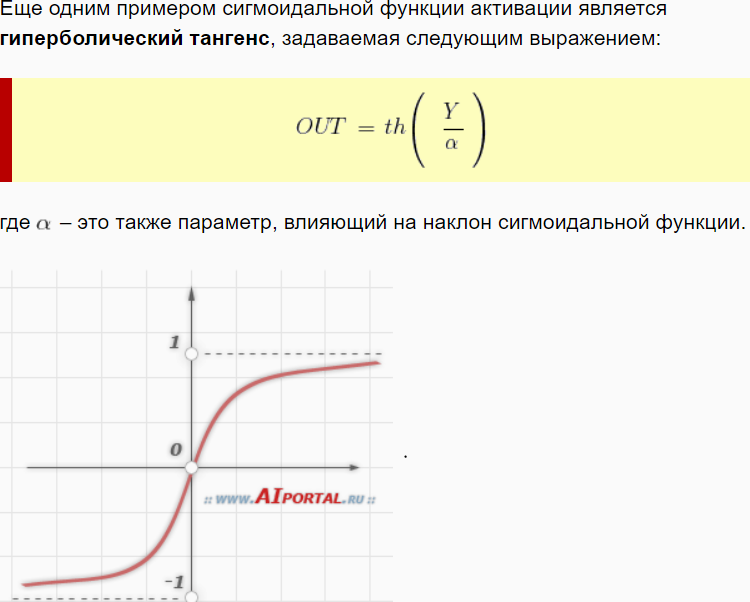

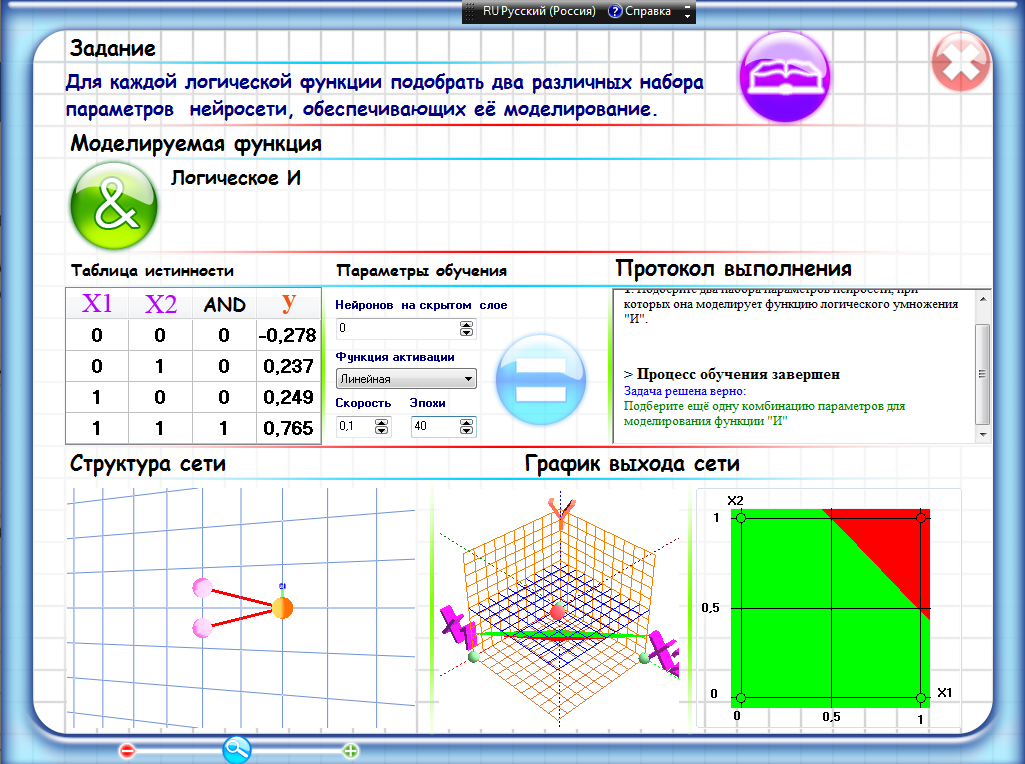

ЛАБОРАТОРНАЯ РАБОТА №5 по дисциплине: «Методы искусственного интеллекта» на тему «Двухслойный персептрон» Цель работы: смоделировать логические операции «конъюнкция», «дизъюнкция» и «исключающее ИЛИ». Требования к лабораторной работе №5: Изучить примеры применения нейронных сетей для решения различных задач. Ответить на вопросы, прилагаемые к лабораторной работе. Выбрать вариант для самостоятельной работы. Сформировать множество обучающих примеров. Выполнить работу, фиксируя в отчете все необходимые данные и полученный результат. Вопросы для самоподготовки: Запишите аналитическое представление линейной функции активации.  Сумматор — элемент, осуществляющий суммирование сигналов, поступающих на его вход: Синапс — элемент, осуществляющий линейную передачу сигнала: где w — «вес» соответствующего синапса. Запишите аналитическое представление пороговой функции активации.  Запишите аналитическое представление сигмоидальной функции активации.    На что влияет и какому множеству принадлежит коэффициент, используемый при задании сигмоидальной функции активации? В этих уравнениях коэффициент α влияет на угол наклона линий к оси S . Запишите аналитическое представление логарифмической функции активации.  Запишите аналитическое представление радиально-базисной функции активации.  где S = X −C – евклидово расстояние между входным вектором X и центром активационной функции C ; σ – параметр гауссовой кривой, называемый шириной окна.  Приведите примеры других функций активации. Гиперболический тангенс.   Чем сигмоидальная функция активации лучше или хуже пороговой функции активации? Функция-ступенька может принимать только два значения: 0 и 1 (иногда 1 и –1), а сигмоидная активационная функция принимает любые значения из интервала (0, 1) (иногда –1, 1). Поэтому с помощью нейросетей с сигмоидными нейронами можно моделировать процессы и явления, характеризующиеся не бинарными, а непрерывными величинами. Например — температура воздуха, курс доллара и т.д. Что представляет собой градиент функции и в какую сторону он направлен? Градиент функции y = y(xi) представляет собой вектор, проекциями которого на оси координат являются производные от y по этим координатным осям. Градиент функции всегда направлен в сторону ее наибольшего возрастания. Опишите метод градиентного спуска. Метод градиентного спуска — это итерационный метод поиска точки минимума функции многих переменных. Направление итерационного движения текущей точки выбирается в сторону антиградиента, а само движение осуществляется со скоростью, пропорциональной его величине. Применяется ли дельта-правило для обучения персептрона с сигмоидальными функциями активации? Да, но обобщенное дельта-правило эффективнее. Какие преимущества и недостатки имеет обобщенное дельта-правило по сравнению с обычным дельта-правилом? Его преимущество по сравнению с обычным дельта-правилом состоит в более быстрой сходимости и в возможности более точной обработки входных и выходных непрерывных сигналов, т.е. в расширении круга решаемых персептронами задач. В качестве недостатка обобщенного дельта-правила можно указать на невозможность его применения для обучения нейросетей, нейроны которых имеют ступенчатые активационные функции. Зарисуйте модель персептрона, реализующего логическую функцию «Исключающее ИЛИ», укажите значения весовых коэффициентов. Геометрическая интерпретация персептрона, моделирующего логическую функцию "ИЛИ"   Опишите алгоритм обратного распространения ошибки. Идея алгоритма обратного распространения ошибки состоит в том, что в качестве нейронных ошибок скрытых слоев используются суммарные нейронные ошибки с последующих слоев, помноженные на силы соответствующих синаптических связей. Таким образом, значения ошибок выходного слоя, которые известны, распространяются вглубь сети от последующих слоев к предыдущим. Алгоритм обратного распространения ошибки, следующий: Инициализировать синаптические веса маленькими случайными значениями. Выбрать очередную обучающую пару из обучающего множества; подать входной вектор на вход сети. Вычислить выход сети. Вычислить разность между выходом сети и требуемым выходом (целевым вектором обучающей пары). Подкорректировать веса сети для минимизации ошибки. Повторять шаги с 2 по 5 для каждого вектора обучающего множества до тех пор, пока ошибка на всем множестве не достигнет приемлемого уровня. Эпоха'>Что такое итерация(эпоха)алгоритма обучения? Эпоха - одна итерация в процессе обучения, включающая предъявление всех примеров из обучающего множества. Эпоха- описывает какое количество раз алгоритм видит полностью набор данных. Итерация- описывает, сколько раз набор данных, передается через алгоритм. Используется ли алгоритм обратного распространения ошибки для обучения персептрона с пороговыми функциями активации? Ступенчатые активационные функции обычно используются в задачах распознавания образов. Персептроны со ступенчатыми активационными функциями могут обучаться с помощью правил Хебба и дельта-правила. Обобщенное дельта правило и алгоритм обратного распространения ошибки для обучения таких персептронов не годятся, так как в эти алгоритмы включают нахождение производных от активационных функций, что невозможно для функций, имеющих разрыв. Какие преимущества и недостатки имеет алгоритм обратного распространения ошибки по сравнению с алгоритмами обучения Хебба и дельта-правилом? Недостатки: длительность, локальные минимумы (использует разновидность градиентного спуска, т. е. осуществляет спуск вниз по поверхности ошибки, непрерывно подстраивая веса в направлении к минимуму. Поверхность ошибки сложной сети сильно изрезана и состоит из холмов, долин, складок и оврагов в пространстве высокой размерности. Сеть может попасть в локальный минимум (неглубокую долину), когда рядом имеется более глубокий минимум. В точке локального минимума все направления ведут вверх, и сеть неспособна из него выбраться. Статистические методы обучения могут помочь избежать этой ловушки, но они медленны.), размер шага(Размер шага должен браться конечным, и в этом вопросе приходится опираться только на опыт. Если размер шага очень мал, то сходимость слишком медленная, если же очень велик, то может возникнуть паралич или постоянная неустойчивость.) Ход работы Первым делом необходимо подобрать параметры обучения нейронной сети для операции логическое «И». Ниже в таблице представлены все необходимые данные. Таблица 1 – Параметры обучения для логического «И»

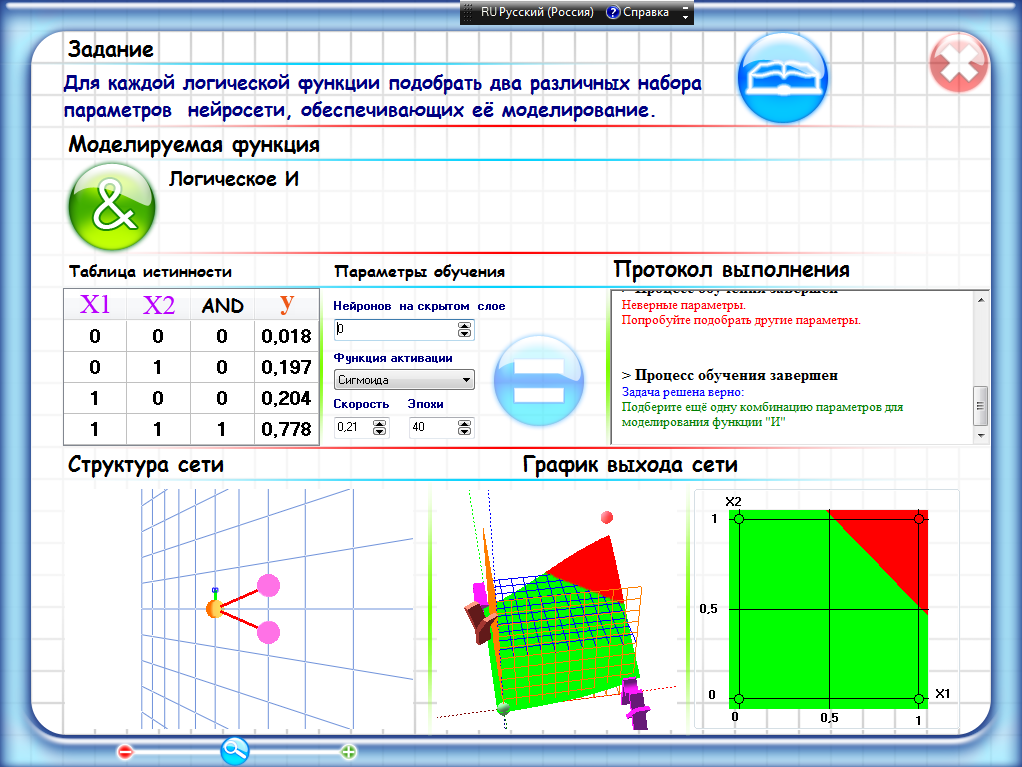

На рисунке 1 изображен протокол выполнения.  Рисунок 1 – Протокол выполнения AND Таблица 2 – Параметры обучения для логического «И»

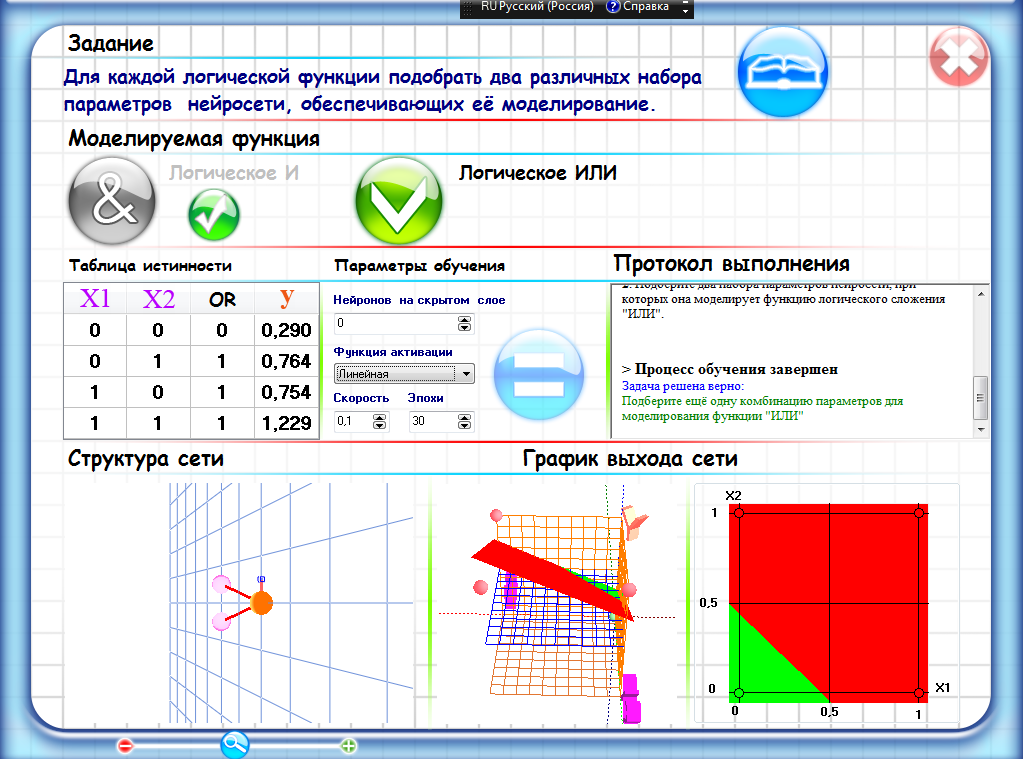

Рисунок 2 – Протокол выполнения AND Ниже представлены таблица и протоколы выполнения для операции логическое «ИЛИ». Таблица 3 – Параметры обучения для логического «ИЛИ»

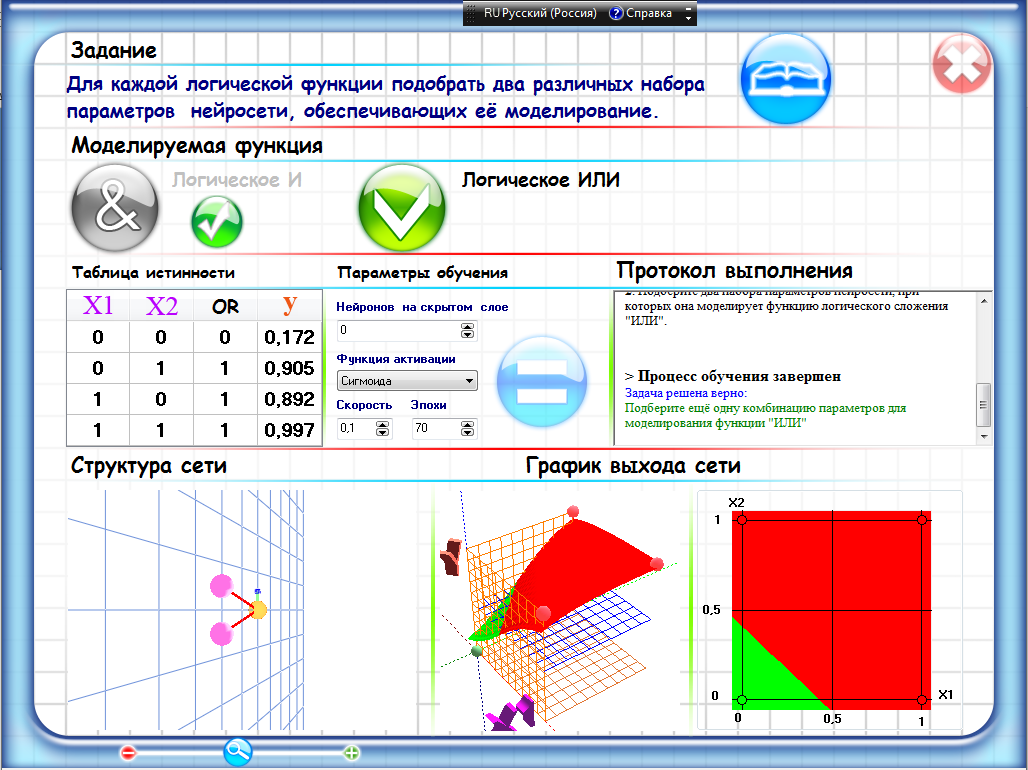

Рисунок 3 – Протокол выполнения OR Таблица 4 – Параметры обучения для логического «ИЛИ»

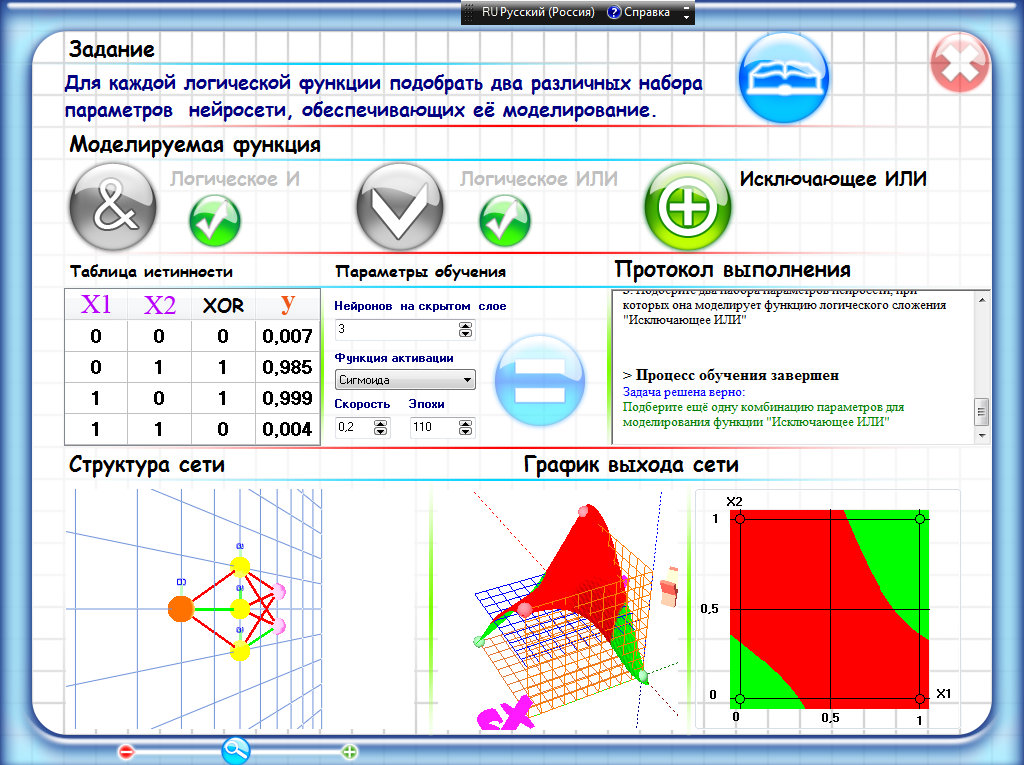

Рисунок 4 – Протокол выполнения OR Данные и протоколы выполнения для исключающего «ИЛИ» представлены ниже. Таблица 5 – Параметры обучения для исключающего «ИЛИ»

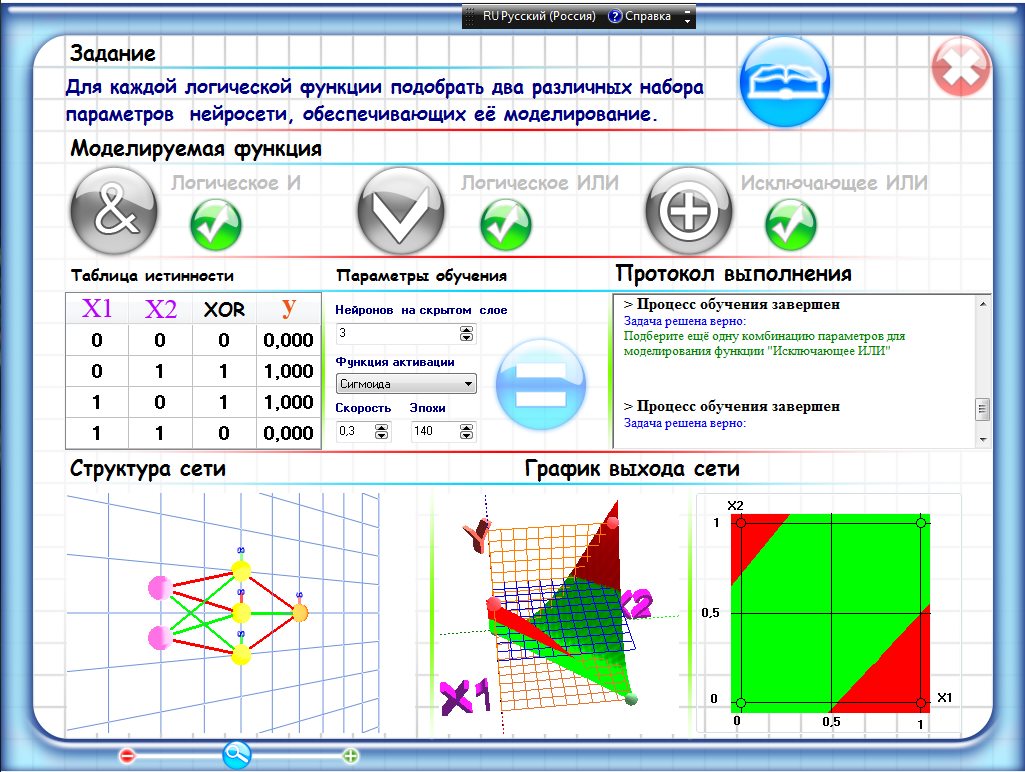

Рисунок 5 – Протокол выполнения XOR Таблица 6 – Параметры обучения для исключающего «ИЛИ»

Рисунок 6 – Протокол выполнения XOR В результате выполнения данной лабораторной работы изучили теоретические сведения и смоделировали логические операции «конъюнкция», «дизъюнкция» и «исключающее ИЛИ». |