Расчетно графическая работа сводный анализ нейронных систем распознавания аудио материалов

Скачать 1.69 Mb. Скачать 1.69 Mb.

|

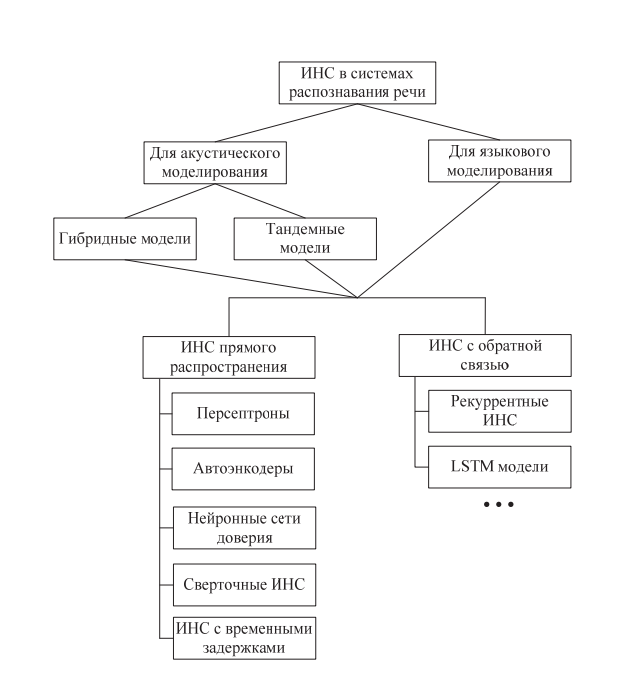

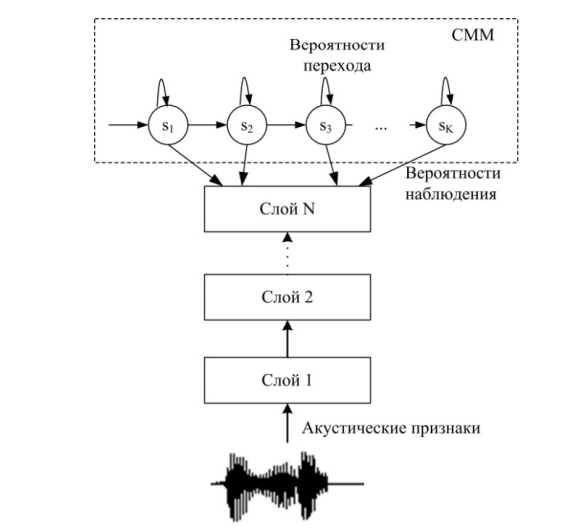

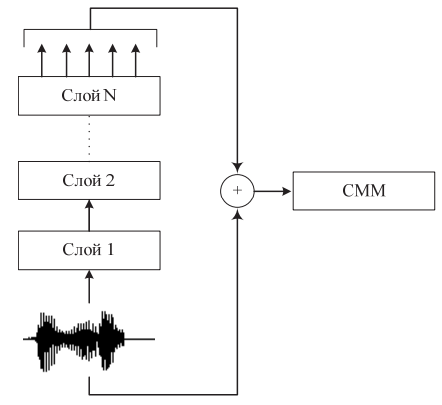

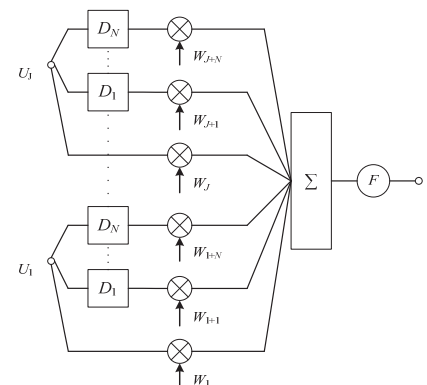

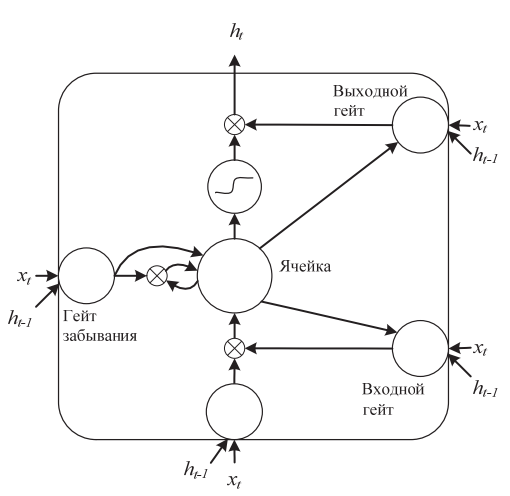

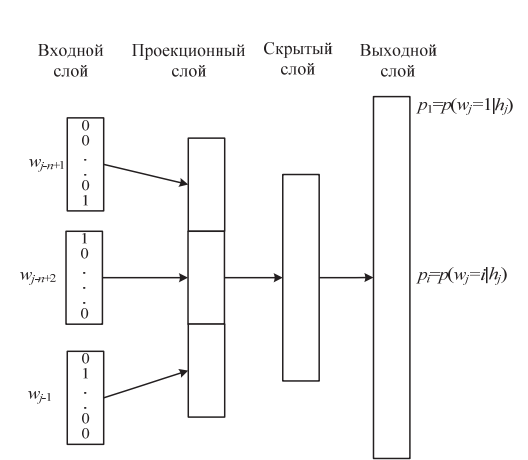

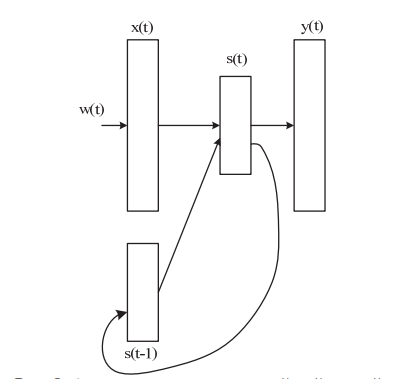

Разновидности нейронных сетей в системах распознавания речиВ последнее время в системах распознавания речи все чаще используются искусственные нейронные сети (НС), которые позволяют повысить точность распознавания речи по сравнению с базовыми моделями (СММ –в качестве акустических моделей; и n-граммы –в качестве моделей языка). Основные типы используемых в системах распознавания речи НС представлены на рисунке 4.  Рис. 4 Классификация НС, применяемых в системах распознавания речи. НС могут применяться как для акустического, так и для языкового моделирования, позволяя повысить точность распознавания. При акустическом моделировании, в зависимости от способа объединения СММ и НС, различают гибридные и тандемные нейросетевые модели. НС можно разделить на сети прямого распространения и сети с обратными связями. Существует достаточно много разновидностей НС, среди которых можно выделить основные виды: персептроны, автоэнкодеры, сверточные НС (convolution neural network; CNN), НС с временными задержками (time delay neural network; TDNN), глубокие нейронные сети доверия (deep belief networks; DBN), НС с длительной кратковременной памятью (Long Short-Term Memory; LSTM). НС для акустического моделирования. Акустические модели обычно строятся на основе глубоких НС (deep neural networks; DNN), которые представляют собой НС прямого распространения, содержащие более одного скрытого слоя между входным и выходным слоями. Для обучения НС обычно используется метод обратного распространения ошибки (backpropagation). Существует множество методов по объединению НС и СММ. Основных методов два: 1) построение гибридных моделей СММ/НС; 2) построение тандемных моделей. В гибридных системах нейронные сети используются для получения апостериорных вероятностей СММ. Архитектура гибридной модели представлена на рисунке 5.  Рис. 5 Архитектура гибридной СММ/НС модели. В методе тандема выходные данные нейронной сети используются как дополнительный поток признаков для обучения СММ. Архитектура модели, использующей метод тандема, представлена на рисунке 6.  Рис. 6 Архитектура модели с использованием тандемного метода. Для увеличения точности распознавания часто используется метод «узкого горла» (bottleneck). Нейронная сеть с «узким горлом» представляет собой многослойную нейронную сеть, в которой средний слой имеет меньшее число элементов. Входными данными для нейронной сети являются стандартные признаки, такие как мелчастотные кепстральные коэффициенты (mel-frequency cepstral coefficients; MFCC) или коэффициенты перцептивного линейного предсказания (perceptual linear prediction; PLP). После обучения слои, находящиеся за слоем «узкого горла», удаляются. Выходные данные нейронов в слое «узкого горла» служат в качестве акустических признаков для стандартных систем распознавания речи, использующих СММ. Зачастую эти признаки применяются совместно со стандартными признаками путем простого объединения соответствующих векторов, т.е. используются в тандемных моделях. Исследования по объединению НС и СММ для акустического моделирования начались еще в конце 1980-х годов. Однако в то время такие исследования не получили широкого распространения, поскольку обучение НС является ресурсоемкой задачей и высокопроизводительных компьютеров. В последнее время в связи с увеличением вычислительной мощности компьютеров применение НС в системах распознавания речи, в том числе и для акустического моделирования, приобретает все большую популярность. Разработка платформы параллельных вычислений с использованием графического процессора Nvidia CUDA позволила существенно сократить время обучения глубоких НС на данных большого объема, что способствовало еще большему распространению нейросетевых моделей в системах распознавания речи. Для акустического моделирования также применяются НС с временными задержками, которые представляет собой многослойную нейронную сеть прямого распространения, узлы которой модифицированы введением временных задержек. Пример узла с N задержками показан на рисунке 5. На рисунке U1…UJ –входы узла; каждый из J входов умножается на соответствующий весовой коэффициент w; D1…Dn –временные задержки F –активационная функция. Таким образом, в НС встраивается кратковременная память. Введение временной задержки позволяет сделать НС инвариантной к временным сдвигам, что позволило получить относительное уменьшение ошибки распознавания слов на 2,6 % (рис. 7)  . .Рис. 7 Пример узла НС с временными задержками Еще одним типом нейронных сетей являются рекуррентные НС. Наличие обратной связи наделяет НС памятью, благодаря чему появляется возможность моделировать динамические процессы. Одним из типов рекуррентных НС, применяемых для акустического моделирования, является сеть LSTM, содержащая специальные элементы, называемые блоками памяти. Блоки памяти содержат ячейки, которые хранят временное состояние сети, а также мультипликативные элементы, называемые гейтами (gates), управляющие потоком информации. Каждый блок памяти содержит входной и выходной гейты, а также гейт забывания. Пример блока памяти сети LSTM показан на рисунке 8. На рисунке xt –входной вектор в момент времени t, ht –выходной вектор. Ячейка сети LSTM может рассматриваться как сложный элемент сети, способный запоминать информацию на длительное время. Гейты определяют, когда входная информация существенна и ее необходимо запомнить, когда следует продолжать запоминать или забыть информацию и когда следует информацию подать на выход.  Рис. 8 Пример блока памяти сети LSTM НС для языкового моделирования. Для моделирования языка используются НС как прямого распространения, так и рекуррентные. Архитектура сети прямого распространения представлена на рисунке 9. В НС прямого распространения входной слой сети представляет собой историю из n-1 слов, предшествующих данному слову. Каждое слово из словаря ассоциировано с вектором длиной V (размер словаря), где только одно значение, соответствующее индексу данного слова в словаре, равно 1, а все остальные значения равны 0. Слой, сформированный путем объединения векторов слов, называется проекционным слоем. Основным недостатком таких сетей является то, что для предсказания слова они используют предшествующий контекст определенной длины.  Рис. 9 Архитектура НС прямого распространения Рекуррентная НС впервые была предложена в работе - Elman J.L. Finding Structure in Time. Cognitive Science. 1990. vol. 14. pp. 179–211. В рекуррентной искусственной нейронной сети (РНС) скрытый слой хранит всю предыдущую историю, таким образом, размер контекста неограничен. Архитектура РНС для языкового моделирования представлена на рисунке 10.  Рис. 10 Архитектура рекуррентной нейронной сети |