ОТВЕТЫ. 1. Издержки производства и их виды. Предельные издержки и предельный доход. Отдача от масштаба производства

Скачать 1.23 Mb. Скачать 1.23 Mb.

|

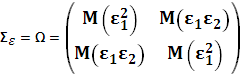

(2.5`) Когда дополнительно к условиям (2.5) (или (2.5`)) постулируют нормальныйхарактер распределения регрессионных остатков = (1,2,..., n)T(что записывается в виде Nn(0;2In)), то говорят, что уи Xсвязаны нормальнойКЛММР. Коренное отличие обобщенной модели от классической состоит только в виде ковариационной квадратной матрицы вектора возмущений: вместо матрицы Σε = σ2En для классической модели имеем матрицу Σε = Ω для обобщенной. Последняя имеет произвольные значения ковариаций и дисперсий. Например, ковариационные матрицы классической и обобщенной моделей для двух наблюдений (п=2) в общем случае будут иметь вид:  Формально обобщенная линейная модель множественной регрессии (ОЛММР) в матричной форме имеет вид: Y = Xβ + ε (1) и описывается системой условий: 1. ε – случайный вектор возмущений с размерностью n; X -неслучайная матрица значений объясняющих переменных (матрица плана) с размерностью nх(р+1); напомним, что 1-й столбец этой матрицы состоит из пединиц; 2. M(ε) = 0n – математическое ожидание вектора возмущений равно ноль-вектору; 3. Σε = M(εε’) = Ω, где Ω – положительно определенная квадратная матрица; заметим, что произведение векторов ε‘ε дает скаляр, а произведение векторов εε’ дает матрицу размерностью nxn; 4. Ранг матрицы X равен р+1, который меньше n; напомним, что р+1 - число объясняющих переменных в модели (вместе с фиктивной переменной), n - число наблюдений за результирующей и объясняющими переменными. Следствие 1. Оценка параметров модели (1) обычным МНК b = (X’X)-1X’Y (2) является несмещенной и состоятельной, но неэффективной (неоптимальной в смысле теоремы Гаусса-Маркова). Для получения эффективной оценки нужно использовать обобщенный метод наименьших квадратов. Следствие 2. Для классической модели ковариационная матрица вектора оценок параметров определялась формулой: Σb = σ2(X’X)-1 (3) Эта оценка для обобщенной модели является смещенной (следовательно, и неэффективной). Следствие 3. Для обобщенной модели ковариационная матрица вектора оценок параметров определяется другой формулой: Σ b* = (X’X)-1X’ΩX(X’X)-1 (4) При оценке параметров уравнения регрессии мы применяем метод наименьших квадратов (МНК). В модели у = + 1х + 2 р + е, случайная составляющая (е) представляет собой «необъясненную или ненаблюдаемую величину». После того, как произведено решение модели, то есть дана оценка параметрам, мы можем определить величину остатков в каждом конкретном случае как разность между фактическими и теоретическими значениями результативного признака еi=yi-  . Поскольку это не есть реальные остатки, то мы их считаем лишь выборочной реализацией неизвестного остатка заданного уравнения. При изменении спецификации модели, добавления в нее новых наблюдений, выборочные оценки остатков могут меняться, поэтому в задачу регрессионного анализа входит не только построение самой модели, но и исследование случайных отклонений, то есть остаточных величин. . Поскольку это не есть реальные остатки, то мы их считаем лишь выборочной реализацией неизвестного остатка заданного уравнения. При изменении спецификации модели, добавления в нее новых наблюдений, выборочные оценки остатков могут меняться, поэтому в задачу регрессионного анализа входит не только построение самой модели, но и исследование случайных отклонений, то есть остаточных величин.В предыдущих разделах мы останавливались на формально-математических проверках статистической достоверности коэффициентов регрессии и корреляции с помощью Т-критерия Стьюдента и критерия Фишера. При использовании этих критериев делаются предположения относительно поведения остатков: предполагают, что 1) остатки представляют собой независимые случайные величины и их среднее значение равно нулю; 2) остатки имеют постоянную дисперсию и подчиняются закону нормального распределения. Пока мы не построим модель, остатки определены быть не могут, и поэтому мы не можем проверить, обладают ли они этими свойствами или нет. Таким образом, проверяя статистическую достоверность параметров связи, мы опираемся всего лишь на непроверенные предпосылки о распределении случайной составляющей уравнения регрессии. Но после построения уравнения регрессии мы уже можем определить остатки и проверить у них наличие тех свойств, которые предполагались вначале. С чем связана необходимость проверки таких свойств? Связано это с тем, что выборочные оценки параметров регрессии должны отвечать определенным критериям. Они должны быть несмещенными, состоятельными и эффективными. Эти свойства оценок, полученных по МНК, имеют важное практическое значение в использование результатов регрессии и корреляции. Несмещенные оценки означают, что математическое ожидание остатков равно нулю. Следовательно, при большом числе выборочных оценок коэффициента регрессии в найденный параметр по результатам одной выборки можно рассматривать как среднее значение из большого числа несмещенных оценок. Оценки считаются эффективными, если они характеризуются меньшей дисперсией (то есть мы имеем минимальную вариацию выборочных оценок). Оценки считаются состоятельными, если их точность увеличивается с увеличением объема выборки. Условия, необходимые для получения несмещенных, состоятельных и эффективных оценок, представляют собой предпосылки МНК, соблюдение которых желательно для получения достоверных результатов регрессии. Предпосылки МНК:

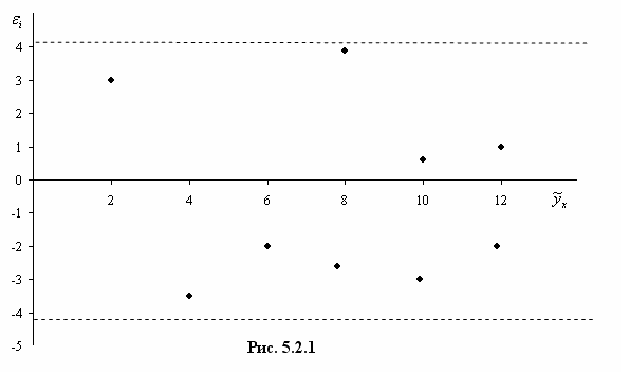

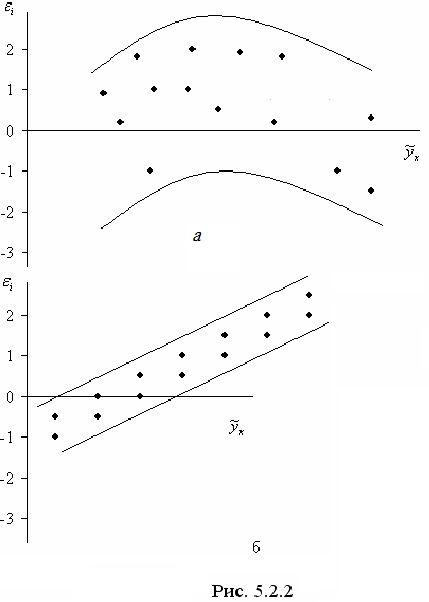

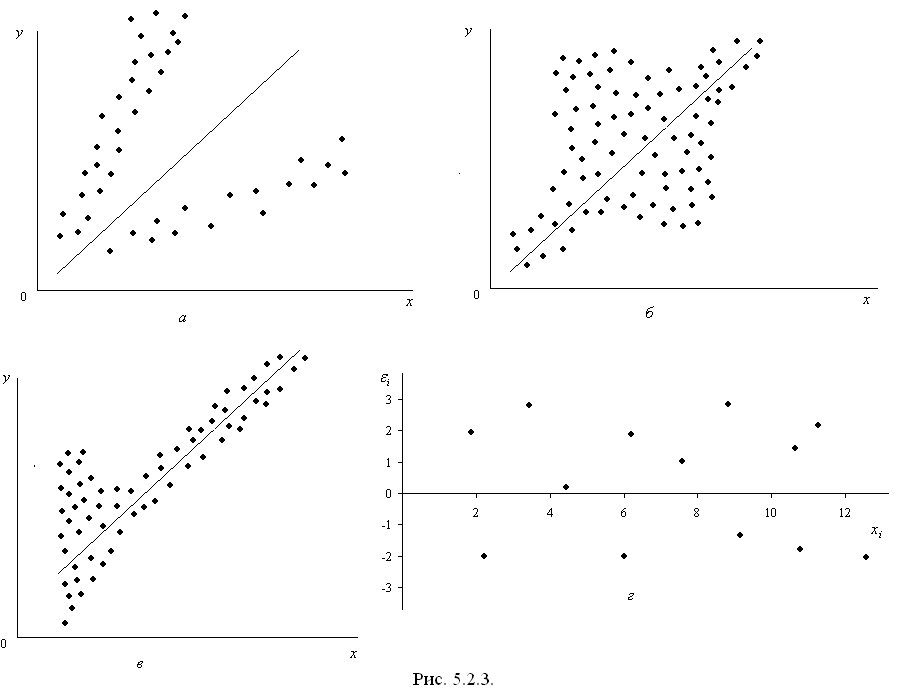

В тех случаях, когда эти предпосылки выполняются, оценки, полученные по МНК, будут обладать вышеназванными свойствами, если же некоторые предпосылки не выполняются, то необходимо корректировать модель. Итак, проверяем случайный характер остатков. С этой целью строится график зависимости остатков от теоретических значений результативного признака (рис.5.2.1.)  Если на графике получена горизонтальная полоса, то остатки представляют собой случайные величины и МНК оправдан. Возможны иные случаи (рис.5.2.2):  а) – остатки носят систематический характер, то есть отрицательные значения соответствуют низким значениям расчетных «у», а положительные – высоким; б) – преобладание положительных остатков над отрицательными. В этих случаях необходимо применять либо другую функцию, либо вводить дополнительную информацию и заново строить уравнение регрессии до тех пор, пока остатки не будут случайными величинами. Вторая предпосылка МНК требует, чтобы дисперсия остатков была гомоскедастичной. Это значит, что для каждого значения фактора остатки имеют одинаковую дисперсию. Если это условие не соблюдается, то имеет место гетероскедастичность. Наличие гомо- или гетероскедастичности можно видеть по графику зависимости остатков от теоретических значений результативного признака (рис. 5.2.3.):  а) большая дисперсия остатков для больших значений «у» (гетероскедастичность); б) большая дисперсия остатков для средних значений «у» (гетероскедастичность); в) – большая дисперсия для меньших значений результата (гетероскедастичность); г) – равная дисперсия (гомоскедастичность). Наличие гетероскедастичности приводит к смещенным оценкам коэффициентов регрессии, а также уменьшает их эффективность. В частности, становится затруднительным использование формулы стандартной ошибки коэффициента регрессии, которая предполагает единую дисперсию остатков. Для множественной регрессии данный вид графиков является наиболее приемлемым визуальным способом изучения гомо- или гетероскедастичности. Однако, чтобы убедиться в наличии этих качеств, обычно не ограничиваются визуальной проверкой гетероскедастичности, а проводят также ее количественное подтверждение. При малом объеме выборки, что характерно для эконометрических исследований для этих целей используется метод Гольдфельда –Квандта, который включает в себя следующие шаги:

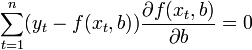

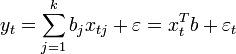

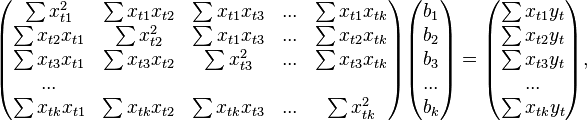

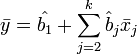

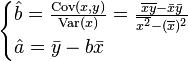

Следующая предпосылка МНК – это отсутствие автокорреляции остатков. Это означает, что остатки распределены независимо друг от друга. Автокорреляция – это наличие тесной корреляционной зависимости между остатками текущих и предшествующих наблюдений, если наблюдения упорядочены по фактору х. Автокорреляционная зависимость определяется по линейному коэффициенту корреляции между текущими и предшествующими наблюдениями (более подробно с этой проблемой мы ознакомимся в теме «Моделирование рядов динамики»). Отсутствие автокорреляции остатков обеспечивает состоятельность и эффективность оценок коэффициентов регрессии. Соответствие распределение остатков нормальному закону распределения можно проверить с помощью критерия Пирсона как критерия согласия (изучалось в курсе «Математическая статистика»). При несоблюдении основных предпосылок МНК приходится корректировать модель, изменяя ее спецификацию, добавлять или исключать некоторые факторы, преобразовывать исходные данные. В частности, при нарушении гомоскедастичности и наличии автокорреляции остатков рекомендуется традиционный МНК, который проводится по исходным данным, заменять обобщенным методом наименьших квадратов, который проводится по преобразованным данным. 22. Прогноз и оценка точности МНК на основе уравнений парной и множественной линейной регрессии Метод наименьших квадратов (МНК, OLS, Ordinary Least Squares) — один из базовых методов регрессионного анализа для оценки неизвестных параметров регрессионных моделей по выборочным данным. Метод основан на минимизации суммы квадратов остатков регрессии. Необходимо отметить, что собственно методом наименьших квадратов можно назвать метод решения задачи в любой области, если решение заключается или удовлетворяет некоторому критерию минимизации суммы квадратов некоторых функций от искомых переменных. Поэтому метод наименьших квадратов может применяться также для приближённого представления (аппроксимации) заданной функции другими (более простыми) функциями, при нахождении совокупности величин, удовлетворяющих уравнениям или ограничениям, количество которых превышает количество этих величин и т. д. Сущность МНК Пусть задана некоторая (параметрическая) модель вероятностной (регрессионной) зависимости между (объясняемой) переменной y и множеством факторов (объясняющих переменных) x где — случайная ошибка модели. Пусть также имеются выборочные наблюдения значений указанных переменных. Пусть — номер наблюдения (). Тогда — значения переменных в -м наблюдении. Тогда при заданных значениях параметров b можно рассчитать теоретические (модельные) значения объясняемой переменной y: Тогда можно рассчитать остатки регрессионной модели — разницу между наблюдаемыми значениями объясняемой переменной и теоретическими (модельными, оцененными): Величина остатков зависит от значений параметров b. Сущность МНК (обычного, классического) заключается в том, чтобы найти такие параметры b, при которых сумма квадратов остатков где: В общем случае решение этой задачи может осуществляться численными методами оптимизации (минимизации). В этом случае говорят о нелинейном МНК (NLS или NLLS — англ. Non-Linear Least Squares). Во многих случаях можно получить аналитическое решение. Для решения задачи минимизации необходимо найти стационарные точки функции  Если случайные ошибки модели имеют нормальное распределение, имеют одинаковую дисперсию и некоррелированы между собой, МНК-оценки параметров совпадают с оценками метода максимального правдоподобия (ММП). МНК в случае линейной модели Пусть регрессионная зависимость является линейной:  Пусть y — вектор-столбец наблюдений объясняемой переменной, а — это -матрица наблюдений факторов (строки матрицы — векторы значений факторов в данном наблюдении, по столбцам — вектор значений данного фактора во всех наблюдениях). Матричное представление линейной модели имеет вид: Тогда вектор оценок объясняемой переменной и вектор остатков регрессии будут равны соответственно сумма квадратов остатков регрессии будет равна Дифференцируя эту функцию по вектору параметров и приравняв производные к нулю, получим систему уравнений (в матричной форме): В расшифрованной матричной форме эта система уравнений выглядит следующим образом:  где все суммы берутся по всем допустимым значениям . где все суммы берутся по всем допустимым значениям .Если в модель включена константа (как обычно), то при всех , поэтому в левом верхнем углу матрицы системы уравнений находится количество наблюдений , а в остальных элементах первой строки и первого столбца — просто суммы значений переменных: и первый элемент правой части системы — . Решение этой системы уравнений и дает общую формулу МНК-оценок для линейной модели: Для аналитических целей оказывается полезным последнее представление этой формулы (в системе уравнений при делении на n, вместо сумм фигурируют средние арифметические). Если в регрессионной модели данные центрированы, то в этом представлении первая матрица имеет смысл выборочной ковариационной матрицы факторов, а вторая — вектор ковариаций факторов с зависимой переменной. Если кроме того данные ещё и нормированы на СКО (то есть в конечном итогестандартизированы), то первая матрица имеет смысл выборочной корреляционной матрицы факторов, второй вектор — вектора выборочных корреляций факторов с зависимой переменной. Немаловажное свойство МНК-оценок для моделей с константой — линия построенной регрессии проходит через центр тяжести выборочных данных, то есть выполняется равенство:  В частности, в крайнем случае, когда единственным регрессором является константа, получаем, что МНК-оценка единственного параметра (собственно константы) равна среднему значению объясняемой переменной. То есть среднее арифметическое, известное своими хорошими свойствами из законов больших чисел, также является МНК-оценкой — удовлетворяет критерию минимума суммы квадратов отклонений от неё. [править]Простейшие частные случаи В случае парной линейной регрессии Отсюда несложно найти оценки коэффициентов:  Несмотря на то что в общем случае модели с константой предпочтительней, в некоторых случаях из теоретических соображений известно, что константа должна быть равна нулю. Например, в физике зависимость между напряжением и силой тока имеет вид ; замеряя напряжение и силу тока, необходимо оценить сопротивление. В таком случае речь идёт о модели . В этом случае вместо системы уравнений имеем единственное уравнение Следовательно, формула оценки единственного коэффициента имеет вид Свойства МНК-оценок В первую очередь, отметим, что для линейных моделей МНК-оценки являются линейными оценками, как это следует из вышеприведённой формулы. Для несмещенностиМНК-оценок необходимо и достаточно выполнения важнейшего условия регрессионного анализа: условное по факторам математическое ожидание случайной ошибки должно быть равно нулю. Данное условие, в частности, выполнено, если

Первое условие можно считать выполненным всегда для моделей с константой, так как константа берёт на себя ненулевое математическое ожидание ошибок (поэтому модели с константой в общем случае предпочтительнее). Второе условие — условие экзогенности факторов — принципиальное. Если это свойство не выполнено, то можно считать, что практически любые оценки будут крайне неудовлетворительными: они не будут даже состоятельными (то есть даже очень большой объём данных не позволяет получить качественные оценки в этом случае). В классическом случае делается более сильное предположение о детерминированности факторов, в отличие от случайной ошибки, что автоматически означает выполнение условия экзогенности. В общем случае для состоятельности оценок достаточно выполнения условия экзогенности вместе со сходимостью матрицы к некоторой невырожденной матрице при увеличении объёма выборки до бесконечности. Для того, чтобы кроме состоятельности и несмещенности, оценки (обычного) МНК были ещё и эффективными (наилучшими в классе линейных несмещенных оценок) необходимо выполнение дополнительных свойств случайной ошибки:

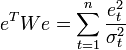

Данные предположения можно сформулировать для ковариационной матрицы вектора случайных ошибок Линейная модель, удовлетворяющая таким условиям, называется классической. МНК-оценки для классической линейной регрессии являются несмещёнными,состоятельными и наиболее эффективными оценками в классе всех линейных несмещённых оценок (в англоязычной литературе иногда употребляют аббревиатуру BLUE(Best Linear Unbaised Estimator) — наилучшая линейная несмещённая оценка; в отечественной литературе чаще приводится теорема Гаусса — Маркова). Как нетрудно показать, ковариационная матрица вектора оценок коэффициентов будет равна: Эффективность означает, что эта ковариационная матрица является «минимальной» (любая линейная комбинация коэффициентов, и в частности сами коэффициенты, имеют минимальную дисперсию), то есть в классе линейных несмещенных оценок оценки МНК-наилучшие. Диагональные элементы этой матрицы — дисперсии оценок коэффициентов — важные параметры качества полученных оценок. Однако рассчитать ковариационную матрицу невозможно, поскольку дисперсия случайных ошибок неизвестна. Можно доказать, что несмещённой и состоятельной (для классической линейной модели) оценкой дисперсии случайных ошибок является величина: Подставив данное значение в формулу для ковариационной матрицы и получим оценку ковариационной матрицы. Полученные оценки также являются несмещёнными исостоятельными. Важно также то, что оценка дисперсии ошибок (а значит и дисперсий коэффициентов) и оценки параметров модели являются независимыми случайными величинами, что позволяет получить тестовые статистики для проверки гипотез о коэффициентах модели. Необходимо отметить, что если классические предположения не выполнены, МНК-оценки параметров не являются наиболее эффективными оценками (оставаясьнесмещёнными и состоятельными). Однако, ещё более ухудшается оценка ковариационной матрицы — она становится смещённой и несостоятельной. Это означает, что статистические выводы о качестве построенной модели в таком случае могут быть крайне недостоверными. Одним из вариантов решения последней проблемы является применение специальных оценок ковариационной матрицы, которые являются состоятельными при нарушениях классических предположений (стандартные ошибки в форме Уайта и стандартные ошибки в форме Ньюи-Уеста). Другой подход заключается в применении так называемого обобщённого МНК. Обобщенный МНК Метод наименьших квадратов допускает широкое обобщение. Вместо минимизации суммы квадратов остатков можно минимизировать некоторую положительно определенную квадратичную форму от вектора остатков , где — некоторая симметрическая положительно определенная весовая матрица. Обычный МНК является частным случаем данного подхода, когда весовая матрица пропорциональна единичной матрице. Как известно из теории симметрических матриц (или операторов) для таких матриц существует разложение . Следовательно, указанный функционал можно представить следующим образом Доказано (теорема Айткена), что для обобщенной линейной регрессионной модели (в которой на ковариационную матрицу случайных ошибок не налагается никаких ограничений) наиболее эффективными (в классе линейных несмещенных оценок) являются оценки т. н. обобщенного МНК (ОМНК, GLS — Generalized Least Squares) — LS-метода с весовой матрицей, равной обратной ковариационной матрице случайных ошибок: . Можно показать, что формула ОМНК-оценок параметров линейной модели имеет вид Ковариационная матрица этих оценок соответственно будет равна Фактически сущность ОМНК заключается в определенном (линейном) преобразовании (P) исходных данных и применении обычного МНК к преобразованным данным. Цель этого преобразования — для преобразованных данных случайные ошибки уже удовлетворяют классическим предположениям. Взвешенный МНК В случае диагональной весовой матрицы (а значит и ковариационной матрицы случайных ошибок) имеем так называемый взвешенный МНК (WLS — Weighted Least Squares). В данном случае минимизируется взвешенная сумма квадратов остатков модели, то есть каждое наблюдение получает «вес», обратно пропорциональный дисперсии случайной ошибки в данном наблюдении:  . Фактически данные преобразуются взвешиванием наблюдений (делением на величину, пропорциональную предполагаемому стандартному отклонению случайных ошибок), а к взвешенным данным применяется обычный МНК. . Фактически данные преобразуются взвешиванием наблюдений (делением на величину, пропорциональную предполагаемому стандартному отклонению случайных ошибок), а к взвешенным данным применяется обычный МНК.23. Нелинейные модели парной и множественной регрессии. Производственные функции. 1. Спецификация модели Эконометрика как система специфических методов начала развиваться с осознания своей главной задачи – отражения связей экономических переменных. Многие экономические процессы наилучшим образом описываются нелинейными соотношениями, например, функциями спроса и производственными функциями. С этой целью в уравнение регрессии начали включаться переменные не только в первой, но и второй степени – с целью отразить свойства оптимальности экономических переменных, то есть наличия значений, при которых достигается минимальное или максимальное воздействие на зависимую переменную. Таково, например, влияние внесения удобрений на урожайность (до определенного уровня насыщение почвы удобрениями способствует росту урожайности, а по достижении оптимального уровня насыщение его дальнейшее наращивание может привести к снижению урожайности). То же можно сказать о воздействии многих социально-экономических переменных, например, влияния дохода на потребление некоторых продуктов питания. В условиях конкретной выборки данных нелинейность влияния переменных может и не подтвердиться, если эти данные варьируют в узких пределах, то есть являются однородными. Предполагая, что ошибки измерения переменных сведены к минимуму, основное внимание в эконометрических исследованиях уделяется ошибкам спецификации модели, то есть ошибкам, вызванным неверным видом уравнения регрессии. В парной регрессии выбор вида математической функции, моделирующей связь переменных, может быть осуществлен тремя методами:

При изучении зависимости между двумя признаками наиболее наглядным является графический метод подбора уравнения. Он основан на построении поля корреляции. Основные типы кривых, используемых при количественной оценке связей, представлены на рис. 4.1. Класс математических функций для описания связи двух переменных достаточно широк. Кроме указанных, используются и другие типы кривых. Значительный интерес представляет аналитический метод выбора типа уравнения регрессии. Он основан на изучении материальной природы связи исследуемых переменных. Пусть, например, изучается потребность предприятия в электроэнергии у в зависимости от объема выпускаемой продукции х. Все потребление электроэнергии можно подразделить на две части:

Тогда зависимость потребления электроэнергии от объема продукции можно выразить уравнением регрессии вида у = а + вх. 4.1. Если затем разделить обе части уравнения на величину объема выпуска продукции (х), то получим выражение зависимости удельного расхода электроэнергии на единицу продукции z = у/х от объема выпущенной продукции (х) в виде уравнения равносторонней гиперболы z = в + а/х. 4.2. Аналогично, текущие производственные затраты предприятия могут быть подразделены на условно-постоянные и условно-переменные, и тогда зависимость себестоимости единицы продукции от объемов производства также характеризуется равносторонней гиперболой. Выбор вида уравнения регрессии экспериментальным методом обычно осуществляется при обработке информации на компьютере путем сравнения величины остаточной дисперсии, рассчитанной при разных моделях. Чем меньше величина остаточной дисперсии, тем в меньшей мере наблюдается влияние прочих, не учитываемых в уравнении регрессии факторов, тем лучше уравнение регрессии подходит к исходным данным. Если остаточная дисперсия оказывается примерно одинаковой для нескольких функций, то на практике предпочтение отдается более простым видам функций, ибо они в лучшей степени поддаются интерпретации и требуют меньшего объема наблюдений. Число наблюдений должно в 6-7 раз превышать число рассчитываемых параметров при переменной х. Значит, если мы выбираем параболу второй степени у = а + вх + сх2 4.3. то требуется объем информации не менее 14 наблюдений. Учитывая, что эконометрические модели часто строятся по данным рядов динамики, ограниченным по протяженности (10, 20, 30 лет), то при выборе спецификации модели предпочтительнее модель с меньшим числом параметров при х. |

.

.