Мат.модель. Режим термообработки Твердость, hrc

Скачать 330.61 Kb. Скачать 330.61 Kb.

|

|

Значения парного коэффициента корреляции свидетельствует о сильной линейной связи между x1 и y. Значения парного коэффициента корреляции свидетельствует о умеренной линейной связи между x2 и y. Значения парного коэффициента корреляции свидетельствует о весьма сильной линейной связи между x3 и y. Значения парного коэффициента корреляции свидетельствует о сильной линейной связи между x2 и x1. Значения парного коэффициента корреляции свидетельствует о умеренной линейной связи между x3 и x1. Значения парного коэффициента корреляции свидетельствует о не сильной линейной связи между x3 и x2.

Дисперсии и среднеквадратические отклонения.

Матрица парных коэффициентов корреляции R:

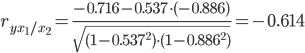

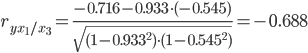

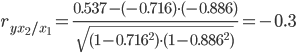

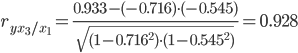

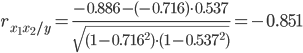

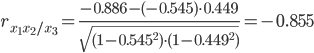

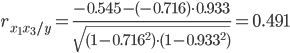

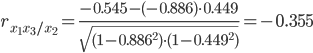

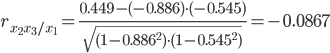

Частные коэффициенты корреляции. Коэффициент частной корреляции отличается от простого коэффициента линейной парной корреляции тем, что он измеряет парную корреляцию соответствующих признаков (y и xi) при условии, что влияние на них остальных факторов (xj) устранено. На основании частных коэффициентов можно сделать вывод об обоснованности включения переменных в регрессионную модель. Если значение коэффициента мало или он незначим, то это означает, что связь между данным фактором и результативной переменной либо очень слаба, либо вовсе отсутствует, поэтому фактор можно исключить из модели. Частные коэффициенты корреляции вычисляются по формуле: где Rij - алгебраическое дополнение элемента rij матрицы R.  Теснота связи умеренная.  Теснота связи умеренная.  Теснота связи не сильная. Теснота связи не сильная.  Теснота связи весьма сильная. Теснота связи весьма сильная.  Теснота связи сильная.  Теснота связи сильная.  Теснота связи не сильная.  Теснота связи не сильная. Теснота связи низкая. Межфакторная связь слабая.  Теснота связи низкая. Межфакторная связь слабая. При сравнении коэффициентов парной и частной корреляции видно, что из-за влияния межфакторной зависимости между xi происходит завышение оценки тесноты связи между переменными. Анализ мультиколлинеарности. Если факторные переменные связаны строгой функциональной зависимостью, то говорят о полной мультиколлинеарности. В этом случае среди столбцов матрицы факторных переменных Х имеются линейно зависимые столбцы, и, по свойству определителей матрицы, det(XTX = 0). Вид мультиколлинеарности, при котором факторные переменные связаны некоторой стохастической зависимостью, называется частичной. Если между факторными переменными имеется высокая степень корреляции, то матрица (XTX) близка к вырожденной, т. е. det(XTX ≧ 0) (чем ближе к 0 определитель матрицы межфакторной корреляции, тем сильнее мультиколлинеарность факторов и ненадежнее результаты множественной регрессии). 1. Анализ мультиколлинеарности на основе матрицы коэффициентов корреляции. Если в матрице есть межфакторный коэффициент корреляции rxjxi>0.7, то в данной модели множественной регрессии существует мультиколлинеарность. В нашем случае r(x1x2) имеют |r|>0.7, что говорит о мультиколлинеарности факторов и о необходимости исключения одного из них из дальнейшего анализа. 2. Ридж-регрессия. Наиболее детальным показателем наличия проблем, связанных с мультиколлинеарностью, является коэффициент увеличения дисперсии, определяемый для каждой переменной как: где Rj2 коэффициент множественной детерминации в регрессии Xj на прочие X. О мультиколлинеарности будет свидетельствовать VIF от 4 и выше хотя бы для одного j. VIF(b1,2)= Поскольку VIF ≥ 4, что говорит о мультиколлинеарности факторов x1, x2 и о необходимости исключения одного из них из дальнейшего анализа. VIF(b1,3)= VIF(b2,3)= 3. Критерием плохой обсуловленности является высокая величина отношения λmax/λmin максимального и минимального собственных чисел матрицы XTX — называемого показателем обусловленности. Это соотношение также позволяет судить о степени серьезности проблем мультиколлинеарности: показатель обусловленности в пределах от 10 до 100 свидетельствует об умеренной коллинеарности, свыше 1000 — об очень серьезной коллинеарности. Модель регрессии в стандартном масштабе. Модель регрессии в стандартном масштабе предполагает, что все значения исследуемых признаков переводятся в стандарты (стандартизованные значения) по формулам:  где хji - значение переменной хji в i-ом наблюдении. Таким образом, начало отсчета каждой стандартизованной переменной совмещается с ее средним значением, а в качестве единицы изменения принимается ее среднее квадратическое отклонение S. Если связь между переменными в естественном масштабе линейная, то изменение начала отсчета и единицы измерения этого свойства не нарушат, так что и стандартизованные переменные будут связаны линейным соотношением: ty = ∑βjtxj Для оценки β-коэффициентов применим МНК. При этом система нормальных уравнений будет иметь вид: rx1y=β1+rx1x2•β2 + ... + rx1xm•βm rx2y=rx2x1•β1 + β2 + ... + rx2xm•βm rxmy=rxmx1•β1 + rxmx2•β2 + ... + βm Для наших данных (берем из матрицы парных коэффициентов корреляции): -0.716 = β1 -0.886β2 -0.545β3 0.537 = -0.886β1 + β2 + 0.449β3 0.933 = -0.545β1 + 0.449β2 + β3 Данную систему линейных уравнений решаем методом Гаусса: β1 = -0.598; β2 = -0.333; β3 = 0.757; Стандартизированная форма уравнения регрессии имеет вид: ty = -0.598x1 -0.333x2 + 0.757x3 Найденные из данной системы β–коэффициенты позволяют определить значения коэффициентов в регрессии в естественном масштабе по формулам: |