Информатика и информация. Лекция 1 Информатика и информация. Понятие информация

Скачать 370 Kb. Скачать 370 Kb.

|

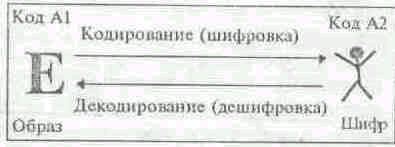

Коды и кодирование дискретных сообщенийС помощью отдельных знаков, наборов знаков и алфавитов (наборов знаков с линейным порядком) можно записывать дискретные сообщения. Поскольку аналоговая информация непрерывна, записать ее с помощью вышеперечисленных понятий нельзя. Пусть имеется предложение некоторого естественного языка, тогда его можно рассматривать как последовательность знаков, по крайней мере, тремя различными способами: а) как последовательность букв, цифр и знаков препинания; б) как последовательность слов, которые в другом контексте могут сами рассматриваться как знаки (например, в стенографии); в) все предложение целиком можно рассматривать как знак (например, при переводе пословицы на другой язык она не переводится дословно, а подбирается аналогичная по смыслу). Таким образом, можно констатировать следующее: дискретные сообщения представляют собой последовательности знаков (конечных или бесконечных). При этом их обычно разбивают на конечные последовательности знаков, называемые словами. На более высоком уровне каждое слово может снова рассматриваться как знак, при этом соответственно набор знаков будет шире первоначального (алфавит - 33 буквы, слов - 150 тысяч). Сформулируем ряд определений. В процессе обмена информацией часто приходится производить операции кодирования и декодирования, поэтому: Кодом называется правило, описывающее отображение одного набора знаков в другой набор знаков (или слов). Кодом также называют и множество образов, то есть конкретных графических изображений знаков. Если каждый образ при кодировании является отдельным знаком (но не словом!), то такое отображение называют шифровкой, а образы - шифрами. Процесс возврата этого отображения к первоначальному виду, если оно однозначно, называется декодированием, или дешифровкой. С  хематично процессы шифровки и дешифровки сообщения изображены на рисунке, где в качестве примера приведена буква «Е», являющаяся образом (то есть отдельным знаком алфавита), представленная соответствующим шифром - шерлок-холмсовским «пляшущим человечком». хематично процессы шифровки и дешифровки сообщения изображены на рисунке, где в качестве примера приведена буква «Е», являющаяся образом (то есть отдельным знаком алфавита), представленная соответствующим шифром - шерлок-холмсовским «пляшущим человечком».Нас, прежде всего, будут интересовать технические коды, так как в ПК информация представлена в двоичном коде, алфавит которого состоит из двух цифр 0 и 1. То есть, чтобы вывести на монитор или записать на жесткий диск какую либо информацию (текстовую, звуковую или графическую) эта информация должна быть закодирована с помощью двоичного алфавита. Технология кодирования и измерения количества информацииСуществует 2 подхода к измерению количества информации: определение К. Шеннона, применяемое в математической теории информации, и определение А. Н. Колмогорова, применяемое в отраслях информатики, связанных с использованием компьютеров (computer science). 1. Содержательный подход - информативность сообщения характеризуется содержащейся в нем полезной информацией - той частью сообщения, которая уменьшает неопределенность какой-либо ситуации. Неопределенность некоторого события - это количество возможных исходов данного события. Так, например, неопределенность погоды на завтра обычно заключается в диапазоне температуры воздуха и возможности выпадения осадков. 2. С позиций computer science носителями информации являются любые последовательности символов, которые хранятся, передаются и обрабатываются с помощью компьютера При алфавитном подходе всякое сообщение можно закодировать с помощью конечной последовательности символов некоторого алфавита. Информативность последовательности символов не зависит от содержания сообщения, а определяется минимально необходимым количеством символов для ее кодирования. Алфавитный подход является объективным, т.е. он не зависит от субъекта, воспринимающего сообщение. Смысл сообщения учитывается на этапе выбора алфавита кодирования либо не учитывается вообще. На первый взгляд содержательный и алфавитный подходы кажутся разными, тем не менее, они хорошо согласуются при выборе единиц измерения. Единицы измерения информации Часто приходится слышать, что сообщение или несет мало информации или, наоборот, содержит исчерпывающую информацию. При этом разные люди, получившие одно и то же сообщение (например, прочитав статью в газете), по-разному оценивают количество информации, содержащейся в нем. Это происходит оттого, что знания людей об этих событиях (явлениях) до получения сообщения были различными. Поэтому те, кто знал об этом мало, сочтут, что получили много информации, те же, кто знал больше, чем написано в статье, скажут, что информации не получили вовсе. Количество информации в сообщении, таким образом, зависит от того, насколько ново это сообщение для получателя. Однако иногда возникает ситуация, когда людям сообщают много новых для них сведений (например, на лекции), а информации при этом они практически не получают (в этом нетрудно убедиться во время опроса или контрольной работы). Происходит это оттого, что сама тема в данный момент слушателям не представляется интересной. Итак, количество информации зависит от новизны сведений об интересном для получателя информации явлении. Иными словами, неопределенность (т.е. неполнота знания) по интересующему нас вопросу с получением информации уменьшается. Если в результате получения сообщения будет достигнута полная ясность в данном вопросе (т.е. неопределенность исчезнет), говорят, что была получена исчерпывающая информация. Это означает, что необходимости в получении дополнительной информации на эту тему нет. Напротив, если после получения сообщения неопределенность осталась прежней (сообщаемые сведения или уже были известны, или не относятся к делу), значит, информации получено не было (нулевая информация). Если подбросить монету и проследить, какой стороной она упадет, то мы получим определенную информацию. Обе стороны монеты "равноправны", поэтому одинаково вероятно, что выпадет как одна, так и другая сторона. В таких случаях говорят, что событие несет информацию в 1 бит. Если положить в мешок два шарика разного цвета, то, вытащив вслепую один шар, мы также получим информацию о цвете шара в 1 бит. Единица измерения информации называется бит (bit) - сокращение от английских слов binary digit, что означает двоичная цифра. Рассмотрим, как можно подсчитать количество информации в сообщении, используя содержательный подход. (формула Хартли) Пусть в некотором сообщении содержатся сведения о том, что произошло одно из N равновероятных событий. Тогда количество информации х, заключенное в этом сообщении, и число событий N связаны формулой: 2x = N. Решение такого уравнения с неизвестной х имеет вид: x=log2N. То есть именно такое количество информации необходимо для устранения неопределенности из N равнозначных вариантов. Эта формула носит название формулы Хартли. Получена она в 1928 г. американским инженером Р. Хартли. Если N равно целой степени двойки (2, 4, 8, 16 и т.д.), то вычисления легко произвести "в уме". В противном случае количество информации становится нецелой величиной, и для решения задачи придется воспользоваться таблицей логарифмов либо определять значение логарифма приблизительно (ближайшее целое число, большее ). При алфавитном подходе, если допустить, что все символы алфавита встречаются в тексте с одинаковой частотой (равновероятно), то количество информации, которое несет каждый символ (информационный вес одного символа), вычисляется по формуле: x=log2N, где N - мощность алфавита (полное количество символов, составляющих алфавит выбранного кодирования). В компьютерной технике бит соответствует физическому состоянию носителя информации: намагничено - не намагничено, есть отверстие - нет отверстия. При этом одно состояние принято обозначать цифрой 0, а другое - цифрой 1. Выбор одного из двух возможных вариантов позволяет также различать логические истину и ложь. Последовательностью битов можно закодировать текст, изображение, звук или какую-либо другую информацию. Такой метод представления информации называется двоичным кодированием (binary encoding). В информатике часто используется величина, называемая байтом (byte) и равная 8 битам. И если бит позволяет выбрать один вариант из двух возможных, то байт, соответственно, 1 из 256 (28). В большинстве современных ЭВМ при кодировании каждому символу соответствует своя последовательность из восьми нулей и единиц, т. е. байт. Соответствие байтов и символов задается с помощью таблицы, в которой для каждого кода указывается свой символ. Так, например, в широко распространенной кодировке Koi8-R буква "М" имеет код 11101101, буква "И" - код 11101001, а пробел - код 00100000. Наряду с байтами для измерения количества информации используются более крупные единицы: 1 Кбайт (один килобайт) = 210 байт = 1024 байта; 1 Мбайт (один мегабайт) = 210 Кбайт = 1024 Кбайта; 1 Гбайт (один гигабайт) = 210 Мбайт = 1024 Мбайта. В последнее время в связи с увеличением объёмов обрабатываемой информации входят в употребление такие производные единицы, как: 1 Терабайт (Тб) = 1024 Гбайта = 240 байта, 1 Петабайт (Пб) = 1024 Тбайта = 250 байта. Для измерения количества информации в вычислительной технике также используется двоичная система счисления. В зависимости от количества разрядов в числе, может быть закодировано разное количество вариантов информации. Рассмотрим сначала одноразрядное двоичное число - бит. Оно может принимать два различных значения: 0 и 1. Если с помощью одноразрядного числа попробовать закодировать какую-либо информацию, например, если мы подкидываем монетку, то на каждый бросок мы получаем вероятность из двух вариантов: орел или решка. То есть количество возможных результатов 2. (результат, либо 1, либо 0). Для того чтобы вычислить количество информации полученной после броска монеты кроме формулы Хартли можно использовать формулу Шеннона: K= 2n Где K - количество возможной информации, n – количество полученной информации. K = 2n =2, n = 1 бит Задача1: Сколько бит потребуется для кодирования больших и маленьких букв латинского алфавита. В общей сложности количество букв составит 52 буквы. К=2n=52, 25=32, 26=64, т.е. 25<52<26. Выбираем большее значение. Следовательно n=6 бит. Задача 1.1 Сколько бит потребуется для кодирования 4-хзначных номеров автомобилей. 1) Определяем количество бит для кодирования одной цифры в 4-хзначном числе. К=2n=4, 22=4, т.е. 1 цифра кодируется двумя битами. (2 бита). 2) Определяем количество бит для кодирования всего 4-хзначного числа. 4*2=8 бит. Следовательно, для кодирования 4-хзначных номеров автомобилей требуется 8 бит. |