2 главы. Введение анализ проблемы и ее современного состояния

Скачать 436.2 Kb. Скачать 436.2 Kb.

|

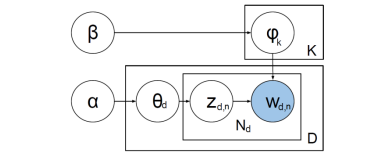

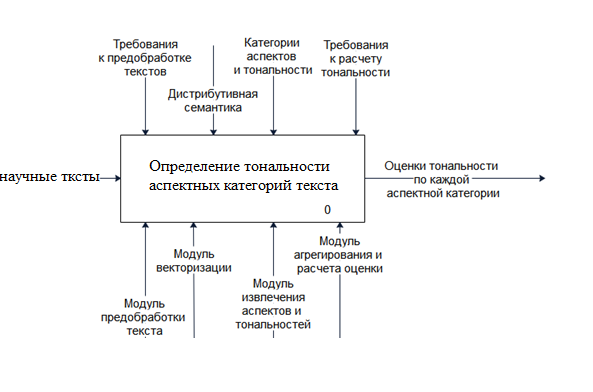

1 2 Тема: Программное обеспечение тематического моделирования научных текстов на основе модели, учитывающей временной фактор как непрерывную величину. ВВЕДЕНИЕ 1. Анализ проблемы и ее современного состояния 1. Анализ предметной области и выявление проблемы 2. Анализ методов в области тематического моделирования 3. Анализ существующих программных решений 4. Цель и задачи 2. Концептуальные положения и формулирование требований к программному решению по реализации тематического моделирования 1. Формальная постановка задачи и структура ее решения 2. Постановка задачи тематического моделирования 3. Концептуальные положения реализации тематического моделирования 4. Требования к программному обеспечению(сюда войдут UMLмодели +Архитектура программного обеспечения и диаграмма размещения, +Диаграмма компонентов, +Диаграмма деятельности) 3. Математическое, (методическое), информационное, программное обеспечение 1. Методика определение тематики текста (Может быть лучше математическое обеспечение) 2. Сбор текстов из открытых источников и хранение данных в озере данных 3. Методика (Алгоритм? Процесс) поиска похожих статей и мониторинга научных публикаций 4. Программное (?и аппаратное?) обеспечение ИС (Выбор технологии реализации ИС и его обоснование, Описание программного продукта, Описание пользовательского интерфейса) 4. Проведение эксперимента и оценка предложенного решения 1.Подготовка обучающего набора данных (+Предварительная обработка данных) 2. Проведение вычислительного эксперимента 3. Интерпретация результатов эксперимента 4. Оценка качества решения ((Тестирование ПО, Метрическая оценка качества программного продукта, Оценка интерпретируемости ПО). ЗАКЛЮЧЕНИЕ СПИСОК ЛИТЕРАТУРЫ ПРИЛОЖЕНИЕ А ПРИЛОЖЕНИЕ Б ПРИЛОЖЕНИЕ В Введение В связи с бурным развитием массовой и деловой коммуникации, ростом информационных потоков, интенсивным накоплением информации, предназначенной для систематизации, хранения и использования, актуальной становится задача извлечения информации (информационного поиска) и ее анализа. Подобный анализ позволяет собирать основную информацию о тематике, направленности и настроении текстов, что в дальнейшем упрощает автоматизированную работу с ними, такую как каталогизация, поиск и сравнение. Наиболее популярным направлением извлечения информации из текстов на данный момент является использование различных статистических методов для обработки текста, например, построение частотных словарей, конкордансов (словарей словосочетаний), сравнение с использованием выделенных сущностей и т. п. Одним из таковых методов является метод тематического моделирования, позволяющий построить модель коллекции текстовых документов, определяющую тематическую направленность каждого из них. В 1958 году Герхард Лисовски и Леонард Рост завершили работу по составлению каталога религиозных текстов на иврите, призванных помочь учёным определить значения терминов, которые были давно утрачены [20]. Путём кропотливой ручной работы они собрали воедино все возможные контексты, в которых появлялся каждый из терминов. Следующей задачей было научиться игнорировать несущественные различия в формах слов и выделять те различия, которые влияют на семантику. Замыслом авторов было дать возможность исследователям языка проанализировать различные отрывки и понять семантику каждого термина в его контексте. Трудности, с которыми столкнулись Лисовски и Рост полвека назад, часто возникают и сегодня при автоматическом анализе текстов. Одна и та же концепция может выражаться любым количеством различных терминов (синонимия), тогда как один термин часто имеет разные смыслы в различных контекстах (полисемия). Таким образом, необходимы способы различать варианты представления одной концепции и определять конкретный смысл многозначных терминов. Кроме того, нужно уметь представлять данные в доступной для человека форме, чтобы дать возможность понять неизвестный ему смысл термина. Теоретически обоснованным и активно развивающимся направлением в анализе текстов на естественном языке, призванным решать перечисленные задачи, является тематическое моделирование коллекций текстовых документов. Построение тематической модели может рассматриваться как задача одновременной кластеризации документов и слов по одному и тому же множеству кластеров, называемых темами. В терминах кластерного анализа тема — это результат би-кластеризации, то есть одновременной кластеризации и слов, и документов по их семантической близости. Обычно выполняется нечёткая кластеризация, то есть документ может принадлежать нескольким темам в различной степени. Таким образом, сжатое семантическое описание слова или документа представляет собой вероятностное распределение на множестве тем. Процесс нахождения этих распределений и называется тематическим моделированием [27]. Как правило, количество тем, встречающихся в документах, меньше количества различных слов во всем наборе. Поэтому скрытые переменные — темы — позволяют представить документ в виде вектора в пространстве скрытых (латентных) тем вместо представления в пространстве слов. В результате документ имеет меньшее число компонент, что позволяет быстрее и эффективнее его обрабатывать. Таким образом, тематическое моделирование тесно связано с другим классом задач, известным как уменьшение размерности данных [14]. Кроме того, найденные темы могут использоваться для семантического анализа текстов. Задача извлечения скрытых тем из коллекции текстовых документов имеет множество применений. Цели и задачи диссертационной работы. Целью диссертационной работы является разработка Программное обеспечение тематического моделирования научных текстов на основе модели, учитывающей временной фактор как непрерывную величину. 1. Анализ проблемы и ее современного состояния 1.1. Анализ предметной области и выявление проблемы Тематическое моделирование — это способ построения модели корпуса текстов, отражающий переход от совокупности документов, совокупности слов в документах к набору тем, характеризующих содержание данных документов. Тематические модели — это модели со скрытыми переменными, для выявления которых лучше всего подходит нечеткая кластеризация, при которой любое слово или документ с некоторой вероятностью относится к нескольким темам [1]. Наиболее популярные в настоящий момент методы тематического моделирования можно разделить на две основных группы — алгебраические и вероятностные (генеративные) [2;4]. К алгебраическим моделям относятся стандартная векторная модель текста VSM (Vector Space Model) и латентно-семантический анализ LSA (Latent Semantic Analysis), а среди вероятностных наиболее популярными являются вероятностный латентно-семантический анализ pLSA (probabilistic LSA) и латентное размещение Дирихле LDA (Latent Dirichlet Allocation). Далее приведен краткий анализ некоторых методов. Векторная модель текстов — это способ представления коллекции документов в виде векторов из общего для всей коллекции векторного пространства. Данная модель используется для решения множества задач быстрого анализа документов, а также для составления таблиц поиска, классификации и кластеризации, и выступает как основа для множества других алгоритмов [2]. В данной модели, документ рассматривается как неупорядоченное множество термов — слов и дополнительных элементов, из которых состоит текст, исключая знаки препинания. Для каждого документа строится матрица терм-документ, где строка — это уникальное слово, а столбец — документ. Значением ячейки данной матрицы является вес данного слова в документе, способ вычисления которого может изменяться в зависимости от алгоритма. Данная модель достаточно популярна для решения задач сравнения текстов между собой, однако в изначальном варианте работает недостаточно быстро для больших объемов документов, а также занимает достаточно много памяти. Развитием данного метода является латентно-семантический анализ [2]. Латентно семантический анализ (ЛСА, LSA) — это статистический метод обработки текстовой информации на естественном языке, позволяющий определить взаимосвязь между коллекциями документов и терминами, в них встречающимися. В основе данного метода лежит принцип факторного анализа, в частности выявление латентных связей изучаемых явлений и объектов. При классификации и кластеризации документов, данный метод позволяет извлечь контекстно-зависимые значения лексических единиц [2]. Основной алгоритм данного метода можно разделить на четыре шага: предобработку, нахождение весов слов любым методом, например, с помощью алгоритма tf-idf, построение весовой матрицы, разложение матрицы методом сингулярного разложения (англ. singular value decomposition, SVD). Результатом работы алгоритма будет являться матрица, визуализация которой позволит отразить общую семантическую близость документов друг к другу. Основными достоинствами данного метода можно считать высокое качество определения тематик в случае, если корпус текстов достаточно большой, а также возможность нахождения неочевидных семантических зависимостей между словами. К недостаткам данного алгоритма относятся высокая вычислительная сложность и низкая скорость работы, требующая повторного вычисления всех метрик для всего корпуса в случае добавления нового документа, а также высокие требования к корпусу, который должен состоять из множества разнообразных по тематикам текстов. Вероятностный латентно-семантический анализ — это статистический метод анализа корреляций двух типов данных. В общем смысле, данный метод является развитием латентно-семантического анализа, однако в отличие от своего предшественника, который по своей сути являлся алгоритмом построения векторного представления с последующим снижением его размерности, вероятностной латентно-семантический анализ основан на смешанном разложении и использовании вероятностной модели, что позволяет более качественно определять возможные тематики документов [4]. К достоинствам данной модели относительно алгебраических можно отнести возможность нахождения вероятности отношения каждого документа к каждой из представленных тем, с последующей группировкой, что является достаточно трудоемкой задачей для алгоритма LSA. Недостатками данной модели являются те же недостатки, присущие и LSA, к которым относится необходимость перестройки всех модели в случае добавления нового документа, а также линейная зависимость количества параметров от количества документов. Латентное размещение Дирихле — применяемая в информационном поиске порождающая модель, позволяющая объяснить результаты наблюдений с помощью неявных (латентных) групп. Данная модель является расширением модели pLSA, и устраняет основные ее недостатки путем использования распределения Дирихле в качестве априори распределения, в результате чего набор тематик получается более конкретный и четкий [1]. Данная модель позволяет уйти от недостатков pLSA, таких как «переобучаемость» и отсутствие закономерности при генерации документов из набора полученных тем, что значительно улучшает итоговую выборку [2]. В результате рассмотрения некоторых основных методов тематического моделирования можно прийти к выводу, что методы, основанные на вероятностных моделях наилучшим образом пригодны для решения поставленной задачи, однако требуют высоких вычислительных затрат при реализации в исходном виде. Метод LDA является наиболее сложным, и при этом позволяет достичь наилучших результатов, и избежать основных недостатков обычного pLSA. Результатом вероятностного тематического моделирования является конечное множество тем, каждая из которых описывается вероятностным распределением на множестве слов. Важным свойством темы является её интерпретируемость. Слова, имеющие большую вероятность в данной теме, должны относиться к одной предметной области и быть семантически связанными. Тема считается интерпретируемой, если, рассматривая наиболее частотные слова темы, эксперт может сказать, о чём эта тема, и дать ей определённое название [1]. Если все темы (или почти все) интерпретируемые, то о такой модели говорят, что она в целом является интерпретируемой. В таком случае модель может быть полезна для понимания тематической структуры коллекции. Интерпретируемость является трудно формализуемой характеристикой. Существуют различные экспертные и вычислительные методики её количественного оценивания [2]. Развитие вероятностного тематического моделирования началось с работы Т.Хофманна [3], в которой была предложена модель вероятностного латентного семантического анализа (Probabilistic Latent Semantic Analysis, PLSA). Построение тематической модели является некорректно поставленной задачей стохастического матричного разложения, которая имеет бесконечное множество решений. Для 7 доопределения постановки задачи и выбора наиболее подходящего решения необходимо вводить дополнительные ограничения на модель. Следующей важной вехой стала модель латентного размещения Дирихле (Latent Dirichlet Allocation, LDA) [4], основанная на байесовской регуляризации искомых дискретных распределений с помощью априорных распределений Дирихле. В последующие годы на основе PLSA и LDA были разработаны сотни специализированных моделей, отличающихся способами регуляризации, структурой исходных данных и матричного разложения [5—7]. Аддитивная регуляризация тематических моделей (ARTM) позволяет комбинировать регуляризаторы для создания моделей с заданными свойствами [8; 9]. Это многокритериальный подход, основанный на оптимизации взвешенной суммы основного критерия (логарифма правдоподобия) и некоторого количества дополнительных критериев-регуляризаторов. Многокритериальный подход является ответом на практическую потребность строить модели, обладающие целым рядом необходимых свойств одновременно [10]. Соответственно, в каждой конкретной задаче тематического моделирования может быть много не только оптимизационных критериев, но и метрик качества, с помощью которых валидируется (оценивается) построенная модель. В частности, в [9] было показано, что комбинирование регуляризаторов сглаживания, разреживания, декоррелирования и отбора тем позволяет одновременно улучшить несколько метрик качества (разреженность, различность и интерпретируемость тем) без заметного ухудшения основного критерия правдоподобия (или перплексии) модели. Тематические модели для разведочного информационного поиска, в дополнение к этим свойствам, должны быть также мультимодальными (учитывать не только слова, но и биграммы, теги, категории, авторство документов) и иерархическими (разделять крупные темы на более мелкие подтемы) [11]. Построение таких моделей требует не только выбора множества модальностей и регуляризаторов, но и подбора различных гиперпараметров. На основе теории аддитивной регуляризации тематических моделей была разработана библиотека тематического моделирования с открытым кодом BigARTM [12; 13]. Свойство аддитивности регуляризаторов позволило реализовать в BigARTM модульный подход, когда пользователь выбирает из библиотеки нужный ему набор регуляризаторов для построения модели с требуемыми свойствами. Возможность конструирования новых композитных моделей из «готовых блоков» существенно отличает BigARTM от других средств тематического моделирования, 8 основанных на теории байесовского обучения, в которой каждая новая модель требует проведения уникальных математических выкладок (байесовского вывода) и, как следствие, разработки нового программного кода. Несмотря на модульность, гибкость, масштабируемость и высокую производительность [10], практическое применение библиотеки BigARTM наталкивается на ряд трудностей. Пользователь должен хорошо разбираться в теории ARTM, чтобы грамотно выбрать стратегию регуляризации, то есть последовательность включения регуляризаторов, затем подобрать число тем, коэффициенты регуляризации для каждого регуляризатора и другие гиперпараметры. Эта работа связана с проведением серий вычислительных экспериментов, которые требуют тщательного планирования, журнализации, валидации, визуализации и критического осмысления промежуточных результатов. Таким образом, BigARTM перекладывает на пользователя значительный объём работы, требующей пристального внимания и высокой квалификации. Актуальной задачей является создание технических средств для автоматизации экспериментов по построению аддитивно регуляризованных тематических моделей, их валидации и выбора лучшей модели по заданной совокупности метрик качества. Тематическое моделирование является полезным инструментом в цифровых гуманитарных исследованиях (digital humanities) [14; 15]. Однако процессы построения, валидации и выбора тематических моделей практически не алгоритмизированы [15]. Большое прикладное значение имеет разработка новых методов визуализации, автоматической валидации и выбора моделей [16]. Также исследователи сталкиваются с неустойчивостью [17] и неинтерпретируемостью тем [18]. Известно, что настройка гиперпараметров модели может повысить её устойчивость [19], однако на практике она выполняется редко, и для неё нет единой принятой методологии [19; 20]. Настройка гиперпараметров может помочь и с интерпретируемостью тем, особенно в рамках подхода ARTM. Известные регуляризаторы, такие как регуляризатор декоррелирования, способствуют повышению различности и интерпретируемости тем [21]; также можно использовать регуляризатор, напрямую оптимизирующий заданный критерий, как это было сделано в [22] для критерия средней когерентности тем. К сожалению, интерпретируемости трудно дать формальное определение. Попытки определить плохие темы через расстояние до известных «мусорных» 9 тем или через низкие значения когерентности дают лишь срез проблематичных тем и имеют ограниченную область применимости [18]. Системный подход к измерению интерпретируемости предполагает оценивание каждой темы по нескольким критериям качества [23]. Таким образом, принятые методологии перекладывают ответственность за подбор гиперпараметров на исследователя; при этом процедура подбора остаётся нерегламентированной, что создаёт высокий барьер входа для неспециалистов. В обзорной монографии [7] подчёркивается важность снижения порога входа и более жёсткой регламентации процесса моделирования: «первоочередная исследовательская задача в тематическом моделировании... сделать его более доступным». Мы видим, что важными нерешёнными проблемами являются: обеспечение интерпретируемости моделей, подбор гиперпараметров и стандартизация процесса построения тематической модели для широкого класса пользовательских прикладных задач Тематическая модель описывается двумя распределениями: (𝑝(𝑤|𝑡) (вероятность того, что тема t породит токен w) и 𝑝(𝑡|𝑑) (пропорция темы t в документе d). Часто используется обозначения φ𝑤𝑡 = 𝑝(𝑤|𝑡), θ𝑡𝑑 = 𝑝(𝑡|𝑑). Два искомых распределения можно тогда представить в виде стохастических матриц Φ и Θ. С точки зрения тематического моделирования, корпус документов представляет собой последовательность трёхэлементных кортежей Ω𝑛 = {︀ (𝑤𝑖 ,𝑑𝑖 ,𝑡𝑖) ⃒ ⃒ 𝑖 = 1, . . . ,𝑛}︀ . Токены wi и документы di являются наблюдаемыми переменными, а темы ti являются скрытыми переменными. Тематическое моделирование основано на формализации двух наблюдений лингвистической природы. 1. Существуют естественные кластеры слов, употребляемых вместе (темы). 2. В разных документах эти темы встречаются с разной частотой. Главное допущение, лежащее в основе тематического моделирования, проще всего сформулировать через процесс генерации документов. Тематическая модель «считает», что каждый документ порождается следующим образом: 1. Для каждой словопозиции i автор документа di выбирает случайную тему t из распределения 𝑝(𝑡|𝑑𝑖) 2. Из распределения 𝑝(di|t) выбирается случайное слово wi Кажущаясся нереалистичность этого допущения на практике смягчается тем, что порядок слов в документе не важен для определения его тематики. Модель оперирует только с величинами ndw, обозначающими число вхождений слова w в документ d. Это предположение, называемое гипотезой мешка слов, сильно упрощает математический аппарат и поэтому часто используется в анализе текстов. Ещё одно важное допущение, связанное с постановкой задачи, называется гипотезой условной независимости. Частота токена зависит только от его темы, но не зависит от документа: 𝑝(𝑤|𝑑,𝑡) = 𝑝(𝑤|𝑡). (1.1) Тема может описывать множество терминов из какой-либо области: например, тема «театр» включает в себя слова «зритель», «опера», «премьера» и не включает в себя слова «космонавтика», «эмпиризм», «кредит» или «гемоглобин». Однако темы могут иметь и более гибкую природу. Например, при анализе художественных текстов можно выделить темы, связанные с определённым персонажем; при анализе обращений в техподдержку можно выделить темы, связанные с конкретными проблемами; в анализе тональности текста (sentiment analysis) можно выделять темы, связанные с определёнными эмоциями. Несмотря на то что тематическое моделирование предназначалось в первую очередь для поиска скрытых тем в текстовых документах, существуют и более экзотические сферы его применения: – Анализ видеозаписей. Видеозапись является документом, в качестве токенов выступают признаки на его кадрах, а в качестве тем – события; например, проезд автомобиля через перекрёсток [28]. – Анализ изображений. Документ — это одно изображение, его токены — признаковое описание этого изображения, темы — находящиесся на изображении объекты [29]. – Судовые журналы кораблей. Документ — это одно путешествие, токен — координаты корабля в определённый день, а темы — различные «миссии», такие как перевозка грузов в определённый порт или китобойный промысел [16]. – Банковские транзакции. Документ — история покупок одного клиента, токен — код продавца, темы — типы потребительского поведения людей (например, «ремонт квартиры») [24]. 16 – Анализ электрокардиосигналов. Документ — одна кардиограмма, токены — кодограммы (полученные на основе амплитуд и интервалов), темы — отдельные заболевания [30] – Анализ музыкальных произведений. Документ — одно произведение, токены — последовательность тональных высотных классов (tonal pitchclasses), темы — тональные профили [31] Для общности изложения далее мы будем использовать понятие токена вместо понятий термина или слова. Приложения тематического моделирования в различных областях наталкиваются на проблемы плохой интерпретируемости тем, дублирующих, «мусорных» и вводящих в заблуждение тем, неустойчивости результатов моделирования. Темы должна удовлетворять одновременно многим критериям, что вызывает необходимость как измерения, так и улучшения качества тематических моделей одновременно по множеству критериев. Неинтерпретируемые темы Не все построенные темы можно однозначно проинтерпретировать. Это ожидаемо: коллекции реальных текстов содержат в себе аномальные документы, неинформативные слова (к числу которых относятся как стоп-слова или слова общей лексики, так и слова, широко распространённые в конкретном корпусе), опечатки и другие артефакты. При этом тематическая модель должна успешно описывать весь корпус, и поэтому таким артефактам нужно найти место. Тем не менее на практике важно минимизировать количество неинтерпретируемых тем и постараться сделать так, чтобы «хорошие» темы не перемешивались с «плохими» и не засорялись «мусорными словами». В работе [74] были отмечены некоторые частые проблемы, связанные с темами низкого качества. 1. Смешанные темы (mixed topics): набор слов, которые трудно проинтерпретировать вместе, но который содержит хорошо интерпретируемые подмножества слов. Можно сказать, что смешанные темы — это несколько «хороших» тем, которые слиплись вместе. 2. Темы-химеры (chained topics): смешанные темы, объединённые общими словами. В качестве примера такой темы можно привести тему из слов «старение - человек - глобин». Пары «старение человек» и «глобин человек» имеют смысл, но пару «старение глобин» объединяет лишь то, что оба слова часто встречаются рядом со словом «человек». Темы-химеры часто возникают из-за слов-омонимов. Например, тема «reagan, roosevelt, clinton, lincoln, honda, chevrolet, bmw» объединяет в себе имена президентов США и марки автомобилей, слипшихся из-за неоднозначного слова «Линкольн») или из-за иерархических отношений между словами (общее понятие «налог» включает в себя «налог на автомобиль» и «налог на прибыль», из-за чего может появиться тема, содержащая в себе редкое сочетание «автомобиль прибыль». 3. Темы с посторонними словами (intruded topics): в целом осмысленные темы, внутри которых есть слова, не имеющие ничего общего с остальными словами. 4. Случайные темы: набор слов, не имеющих отношения друг к другу. 5. Несбалансированные по охвату темы: содержат внутри себя термины как широкой направленности, так и крайне специфические. Например, «сигнальная трансдукция» (общее название передачи сигнала в молекулярной биологии) и «сигнальный путь Notch» (один из многих сигнальных путей, которые, в свою очередь, являются одним из аспектов сигнальной трансдукции). Отметим, что многие из перечисленных здесь пунктов могут делать потенциально информативные темы некачественными. Этот список проблем далее был уточнён и переработан в работе [18], в которой дополнительно описываются темы с излишней общностью (состоящие из слишком частых и/или неспецифичных токенов), темы с избыточной специфичностью (состоящие из слишком редких и/или специфичных токенов), идентичные темы и темы, «испорченные» неполным списком стоп-слов. Другой класс явных проблем можно определить через расстояние до известных «мусорных» тем: D-Background, W-Vacuous, W-Uniform, среднее геометрическое, равномерное распределение 𝑝(𝑡); или по другим мерам качества (более подробно эти меры качества изложены в следующей главе). Несмотря на то что суммарное качество для модели хорошо коррелирует с общей интерпретируемостью, разбиение мер качества по отдельным темам не всегда коррелирует с экспертной оценкой интерпретируемости индивидуальных тем. В ряде случаев экстремальные по каким-либо мерам качества темы (то есть как «самые хорошие», так и «самые плохие») являются неинтерпретируемыми или низкокачественными с точки зрения экспертов. В противовес явным проблемам, изложенным выше, работа [16] предостерегает исследователей от ряда возможных неявных проблем: «Упрощение тематических моделей для ученых-гуманитариев, которые не будут (и не должны) изучать лежащие в их основе алгоритмы, создаёт огромный потенциал для необоснованных — или даже вводящих в заблуждение — “инсайтов”». Примером такого проблематичного применения может служить исследователь, изучающий график зависимости вероятности темы от времени и рассматривающий одну тему отдельно от всех остальных. Взлёты и падения этой темы он интерпретирует в терминах изменения частоты понятия, характеризуемого её множеством из 10 верхних (наиболее частотных, «топовых», top-10) слов. Автор работы призывает этого исследователя к осторожности и обосновывает свой тезис рядом демонстраций. Первая демонстрация изучает роль верхних токенов в описании темы. Для этого тематическое моделирование применяется в экзотической области анализа географических данных: роль корпуса документов играют судовые журналы, токены которых — координаты корабля в один из дней его путешествия. Главной особенностью этого эксперимента является возможность визуализации всего распределения целиком — задача, которая, как правило, нереалистична в большинстве практических приложений. Автор демонстрирует нерепрезентативность верхних токенов при помощи карты Земли с нанесёнными на неё точками (визуализация заданной темы состоит из линий, соответствующих документам/путешествиям, и из точек, соответствующих верхним токенам/самым частым местоположениям). В большинстве случаев видно, что верхние токены дают очень плохое представление о теме; большинство верхних токенов расположено на границах маршрута и не несёт никакой информации о его форме. Вторая демонстрация проверяет темы на однородность по времени. Коллекция статей журнала Proceedings of the Modern Language Association растянута по времени с 1889 года по 2006 год. Это даёт возможность «разбить построенную тему на две части»: отметить все отнесённые к ней слова во всех документах, затем поделить документы на две хронологические группы (с 1889 по 1959 год и с 1959 по 2006 год) и вычислить частоты этих слов отдельно внутри каждой группы. Полученные таким образом пары списков верхних слов можно сравнить. Около четверти всех тем имеет существенные различия и может иметь две несовместимые интерпретации для этих двух временных периодов. На основании этих рассуждений автор заключает, что для популяризации тематического моделирования среди учёных-гуманитариев требуются средства визуализации, выходящие за рамки списка верхних слов, а также что инструментарий тематического моделирования должен быть обогащён множеством автоматических проверок. Сформированная в работе критика остаётся актуальной и в настоящее время [15]. Различные реализации тематических моделей могут использовать стохастические элементы в своей инициализации и обучении. Многопоточные реализации алгоритмов обучения могут быть подвержены состоянию гонки (race condition), что делает результат обучения недетерминированным даже в условиях переиспользования одной и той же фиксированной последовательности случайных чисел. Также известно, что многие реализации тематического моделирования неустойчивы относительно порядка документов в корпусе [19]. Более половины из 57 рассмотренных в работе [19] статей в том или ином виде упоминает проблему неустойчивости латентного размещения Дирихле. Это проблематично по ряду причин. Например, затрудняет применение тематических моделей для анализа того, как тематики корпуса эволюционируют во времени или при добавлении новых документов [75]. Если тематическая модель используется для принятия каких-то решений, то неустойчивость может привести к ошибочным выводам, основанным не на объективной структуре корпуса, а на случайных шумоподобных эффектах [17]. Это может ввести пользователя в заблуждение и понизить эффективность других автоматических классификаторов, использующих выход тематической модели как обучающую выборку или дополнительные признаки [19]. 2. Анализ методов в области тематического моделирования Наиболее популярные в настоящий момент методы тематического моделирования можно разделить на две основных группы — алгебраические и вероятностные (генеративные) [2;4]. К алгебраическим моделям относятся стандартная векторная модель текста VSM (Vector Space Model) и латентно-семантический анализ LSA (Latent Semantic Analysis), а среди вероятностных наиболее популярными являются вероятностный латентно-семантический анализ pLSA (probabilistic LSA) и латентное размещение Дирихле LDA (Latent Dirichlet Allocation). Далее приведен краткий анализ некоторых методов. Векторная модель текстов — это способ представления коллекции документов в виде векторов из общего для всей коллекции векторного пространства. Данная модель используется для решения множества задач быстрого анализа документов, а также для составления таблиц поиска, классификации и кластеризации, и выступает как основа для множества других алгоритмов [2]. В данной модели, документ рассматривается как неупорядоченное множество термов — слов и дополнительных элементов, из которых состоит текст, исключая знаки препинания. Для каждого документа строится матрица терм-документ, где строка — это уникальное слово, а столбец — документ. Значением ячейки данной матрицы является вес данного слова в документе, способ вычисления которого может изменяться в зависимости от алгоритма. Данная модель достаточно популярна для решения задач сравнения текстов между собой, однако в изначальном варианте работает недостаточно быстро для больших объемов документов, а также занимает достаточно много памяти. Развитием данного метода является латентно-семантический анализ [2]. Латентно семантический анализ (ЛСА, LSA) — это статистический метод обработки текстовой информации на естественном языке, позволяющий определить взаимосвязь между коллекциями документов и терминами, в них встречающимися. В основе данного метода лежит принцип факторного анализа, в частности выявление латентных связей изучаемых явлений и объектов. При классификации и кластеризации документов, данный метод позволяет извлечь контекстно-зависимые значения лексических единиц [2]. Основной алгоритм данного метода можно разделить на четыре шага: предобработку, нахождение весов слов любым методом, например, с помощью алгоритма tf-idf, построение весовой матрицы, разложение матрицы методом сингулярного разложения (англ. singular value decomposition, SVD). Результатом работы алгоритма будет являться матрица, визуализация которой позволит отразить общую семантическую близость документов друг к другу. Основными достоинствами данного метода можно считать высокое качество определения тематик в случае, если корпус текстов достаточно большой, а также возможность нахождения неочевидных семантических зависимостей между словами. К недостаткам данного алгоритма относятся высокая вычислительная сложность и низкая скорость работы, требующая повторного вычисления всех метрик для всего корпуса в случае добавления нового документа, а также высокие требования к корпусу, который должен состоять из множества разнообразных по тематикам текстов. Вероятностный латентно-семантический анализ — это статистический метод анализа корреляций двух типов данных. В общем смысле, данный метод является развитием латентно-семантического анализа, однако в отличие от своего предшественника, который по своей сути являлся алгоритмом построения векторного представления с последующим снижением его размерности, вероятностной латентно-семантический анализ основан на смешанном разложении и использовании вероятностной модели, что позволяет более качественно определять возможные тематики документов [4]. К достоинствам данной модели относительно алгебраических можно отнести возможность нахождения вероятности отношения каждого документа к каждой из представленных тем, с последующей группировкой, что является достаточно трудоемкой задачей для алгоритма LSA. Недостатками данной модели являются те же недостатки, присущие и LSA, к которым относится необходимость перестройки всех модели в случае добавления нового документа, а также линейная зависимость количества параметров от количества документов. Латентное размещение Дирихле — применяемая в информационном поиске порождающая модель, позволяющая объяснить результаты наблюдений с помощью неявных (латентных) групп. Данная модель является расширением модели pLSA, и устраняет основные ее недостатки путем использования распределения Дирихле в качестве априори распределения, в результате чего набор тематик получается более конкретный и четкий [1]. Данная модель позволяет уйти от недостатков pLSA, таких как «переобучаемость» и отсутствие закономерности при генерации документов из набора полученных тем, что значительно улучшает итоговую выборку [2]. Скрытое размещение Дирихле (Latent Dirichlet Allocation, LDA) — генеративная графическая вероятностная модель, предложенная Дэвидом Блеем и соавторами в 2003 году [9]. Процесс генерации документа похож на генеративный процесс в PLSI. Каждый документ генерируется независимо: 1. Случайно выбрать для документа его распределение по темам θd 2. Для каждого слова в документе: a. Случайно выбрать тему из распределения θd, полученного на 1- м шаге b. Случайно выбрать слово из распределения слов в выбранной теме φt Схема модели скрытого размещения Дирихле изображена на рис. 1.  Рис. 1. Графическое представление модели скрытого размещения Дирихле. Имеется набор из D документов. Каждый документ состоит из Nd слов, wdn соответствует наблюдаемым переменным — словам в документе. Это единственные наблюдаемые переменные в модели, остальные переменные — скрытые. Переменная zdn принимает значение темы, выбранной на шаге 2а для слова wdn. Для каждого документа d переменная θd представляет собой распределение тем в этом документе. В классической модели LDA количество тем фиксировано изначально и задаётся в явном виде параметром K. φk — распределение слов в теме k. Можно подобрать оптимальное значение K, варьируя его и измеряя способность модели предсказывать неизвестные данные, например, документы из тестовой выборки. Однако для того чтобы определять оптимальное количество тем в документе автоматически, были предложены более совершенные способы. Из Байесовской теории вероятностей известно, что распределение Дирихле является сопряжённым априорным к мультиномиальному распределению, которое обычно используется для моделирования текстов. Знание сопряжённых семейств распределений существенно упрощает вычисление апостериорных вероятностей при оценке параметров модели. Предложеные подходы, позволяющие восстановить оптимальные значения гиперпараметров модели по обучающей выборке [10, 24]. На практике, как правило, используются значения, наиболее характерные для конкретных данных. К примеру, значение параметра, близкое к нулю, позволяет после оценивания параметров модели получить мультиномиальное распределение, в котором в котором большая часть плотности вероятности сосредоточена на небольшом наборе значений. Это хорошо соотносится со степенным распределением, которое часто наблюдается в текстах на естественном языке. В результате рассмотрения некоторых основных методов тематического моделирования можно прийти к выводу, что методы, основанные на вероятностных моделях наилучшим образом пригодны для решения поставленной задачи, однако требуют высоких вычислительных затрат при реализации в исходном виде. Метод LDA является наиболее сложным, и при этом позволяет достичь наилучших результатов, и избежать основных недостатков обычного pLSA. 1. 3. Анализ существующих программных решений Тематическое моделирование также применяется для анализа программных артефактов [20; 59]. Два самых популярных приложения охватывают около половины всех работ в этой области [20]. Первое из них — восстановление прослеживаемости (traceability link recovery), предназначенное для автоматического выявления связей между парами разнородных программных артефактов, таких как документы с исходным кодом и документы с требованиями [60]. Возможность ответить на вопрос «Какой файл (какие файлы) с исходным кодом реализует требование (функционал) X?» важна как для разработчиков, так и для заказчика. Близкой является задача локализации ошибок (bug localization), при которой ищется связь между баг-репортами и исходным кодом. Второе приложение — локализация функционала (concept location/feature location), предназначенная для идентификации кусков исходного кода, связанных с реализацией данного функционала программной системы [61]. Здесь, в отличие от восстановления прослеживаемости, от модели требуется построить связи между однородными программными артефактами (т.е. между исходными кодами, 22 лежащими в одном и том же репозитории). Эта задача в первую очередь актуальна для разработчиков, желающих отладить или улучшить данную функцию. Также стоит отметить: кластеризацию и визуализацию кода (Source Code Comprehension) для помощи в понимании и ориентировании в неструктурированном массиве текстов, основой которого служат идентификаторы переменных и комментарии; автоматическую разметку программных артефактов (software artifact labeling), предназначенную для характеризации большого документа коротким множеством ключевых слов [62]; прогнозирование возможных дефектов (Software Defects Prediction) посредством анализа исходников или логов выполнения; помощь в устранении дефектов посредством статистической отладки и анализа причин (Statistical Debugging и Root Cause Analysis), включающую в себя интеллектуальную фильтрацию логов исполнения. К прочим применениям можно отнести анализ истории изменений (Software History Comprehension), маршрутизацию задач к наиболее подходящему разработчику (Developer Recommendation/Bug Triaging), помощь в рефакторинге, приоритизацию исполнения тестовых кейсов, измерение дополнительных мер качества и так далее [20; 59]. 1.4.2 Разведочный информационный поиск Разведочный поиск включает в себя большой класс задач, связанных с систематизацией информации, суммаризацией текстов, переработкой знаний. Разведочный поиск — это итерационный процесс, в котором пользователь несколько раз переформулирует свой запрос с целью разобраться в новой для себя предметной области. Тематические модели оказываются наиболее актуальными для обработки длинных или сложных поисковых запросов, которые трудно или невозможно сформулировать в виде короткого списка ключевых слов (в том числе и для поиска документов, семантически близких к данному). В недавних работах [11; 63] показано, что аддитивно регуляризованные тематические модели по качеству поиска превосходят как асессоров, так и конкурирующие модели. 2. Концептуальные положения и формулирование требований к программному решению по реализации тематического моделирования 2.1. Формальная постановка задачи и структура ее решения В предыдущей главе было описано, для каких целей исследователи применяют тематические модели. Математический аппарат тематического моделирования всё чаще используется для того, чтобы сделать какие-либо выводы, рассмотрев темы сами по себе. Строго говоря, это не является использованием тематического моделирования по прямому назначению., поскольку изначально тематическое моделирование было всего лишь промежуточным шагом для последующей машинной обработки. Главным приложением семантической индексации был информационный поиск: - показ пользователю документа, наиболее релевантного его запросу, либо поиск документов, похожих на данный. В ранних работах, посвящённых тематическому моделированию, вопрос содержательной интерпретации тем не ставился. Главными критериями качества были либо основанные на правдоподобии метрики (такие как перплексия на обучающей или проверочной выборке), либо метрики, основанные на внешней задаче (точность нахождения документа в информационном поиске; качество классификации документа по его тематическому векторному представлению. Как правило, исследователи изучали несколько наиболее частотных токенов из каждой темы (.верхние 10 токенов., 10 top-tokens), но это было лишь способом убедиться в общей адекватности модели; никаких строго сформулированных требований к семантической состоятельности тем в этот процесс не закладывалось. Первая работа, в которой был поднят вопрос изучения внутренней структуры тематических моделей [1], появилась лишь в 2009 году. В ней приглашённые эксперты различными способами оценивали 10 верхних слов каждой темы, а также соответствие документа и тем, которые приписывает ему модель. Одним из важных результатов этой работы оказалось то, что перплексия отрицательно коррелирует с оценками экспертов. В частности, обнаружилось что Correlated Topic Model [77], традиционно считавшаяся лучшей моделью с точки зрения перплексии, предсказаний и правдоподобия, показывает наихудшую интерпретируемость по сравнению с остальными моделями. Это поставило перед сообществом новую задачу: найти критерии для автоматического оценивания интерпретируемости тем без участия экспертов. 2.2. Постановка задачи тематического моделирования постановку задачи представляет контекстная диаграмма IDEF0 (рис.4). На вход подаются тексты отзывов, на выходе – оценки тональности по каждой аспектной категории.  Рисунок 2.1 Постановка задачи 1 2 |