Надежность. надежность учебник. Задачи и исходные положения теории надежности 3 3 Причины и характер отказов объектов 8

Скачать 1.16 Mb. Скачать 1.16 Mb.

|

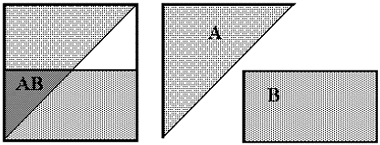

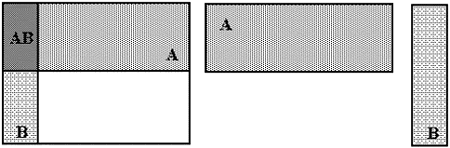

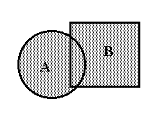

Приложение АОбщие понятия теории вероятности Понятие события - первичное понятие теории - строго не определяется. Событие - это то, что при определенных условиях может произойти или не произойти. В общем случае событие - это множество элементов. (Иногда - один, иногда - бесконечное множество) Событие, которое нельзя разбить на элементы называется элементарным. Событие, которое в данных условиях всегда происходит называется достоверным(U). Событие, которое в данных условиях никогда не происходит называется невозможным (V). Рассматривая события как множества, можно определить действия над событиями. Объединение событий или сумма событий A U B или А + В - событие, содержащее все элементы А и В

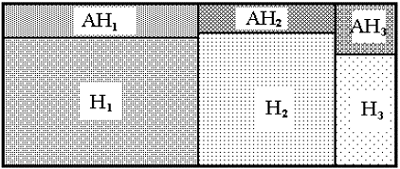

Пересечение событий или произведение событий – Если СЕ = V, т.е. пересечение С и Е - пустое множество, события С и Е не имеют общих элементов, то такие события называются несовместными. Говорят, что событие А влечет за собой событие В (обозначение А Если А Все элементарные события, в сумме составляют достоверное пространство элементарных событий. Событие, дополняющее данное (А) до достоверного, называется противоположным данному и обозначается чертой сверху (Ā). Т.е. А + Ā = U. Попарно несовместные события, в сумме составляющие достоверное образуют полную группу событий.

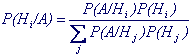

Прежде, чем определить вероятность на данном пространстве элементарных событий, строят поле событий. Поле событий - это множество событий, которое включает в качестве элементов : 1. достоверное событие, 2. невозможное событие, 3. все элементарные события данного пространства, 4. все события, которые на этом пространстве можно построить путем сложения (объединения) событий, путем перемножения (пересечения) событий, а также путем взятия противоположных событий от любого уже построенного. Таким образом, никакая операция алгебры событий над заданным пространством элементарных событий не порождает события, не принадлежащего полю событий. Поле событий может содержать конечное число элементов (если конечно число элементарных событий) или бесконечное множество событий. Наиболее строгое и общее определение понятия вероятность дал русский математик В.Н. Колмогоров. Оно гласит : Каждому событию А из поля событий сопоставляется неотрицательное число Р(А), называемое вероятностью этого события и удовлетворяющее следующим аксиомам: 1. Р(А) ≥ 0 ; 2. Р(U) = 1, U - достоверное событие ; 3. Р(А+В) = Р(А) + Р(В) , если А и В - несовместны. Основные формулы - следствия из аксиом о вероятностиИз аксиом о вероятности следует: 1 . Р( V ) = 0 ; 2 . Р(А) = 1 - Р(А) ; 3 . Р(А+В) = Р(А) + Р(В) - Р(АВ) - формула "сложения вероятностей", справедливая для любых событий ; 4 . Если А ≥ В , то Р(В) ≥ Р(А) ; 5 . Если все элементарные события равновероятны и их число конечно и равно n, а событие А включает в себя m элементарных событий, то Р(А) = m/n ; Следствие 5 из аксиом о вероятности исключительно важное, оно наиболее часто используется при решении задач и его некоторые называют "классическим определением вероятности". Однако, это ни в коем случае не является определением понятия вероятность, т.к. в качестве определения оно логически противоречиво и область его применения ограничена частным случаем конечного числа равновероятных элементарных событий. (т.е. само определение ссылается на определяемое понятие Условная вероятность. Независимые события. | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||

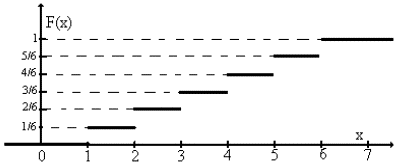

| Пример 1: число очков при бросании кости | ||||||

| Значения хi: | 1 | 2 | 3 | 4 | 5 | 6 |

| Вероятности р(хi) | 1/6 | 1/6 | 1/6 | 1/6 | 1/6 | 1/6 |

Функция распределения:

Функция распределения числа очков при бросании кости

Обратите внимание: Хотя случайная величина принимает только дискретные значения ее функция распределения определена для любых х.

Например: F(-1) = 0, F(0) = 0, F(0.999) = 0, F(1.001) = 1/6, F(3.5) = 3/6, F(7) = 1.

Для непрерывных случайных величин вводится понятие плотности распределения р(х), которая есть производная от функци распределения.

Вероятность того, что случайная величина ξ примет значение, лежащее в интервале (а,b) равна разности значений функции распределения на концах интервала

P{ a≤ ξ

Для непрерывных случайных величин

Важно помнить, что всегда для дискретных распределений сумма р(хi) по всем возможным значениям хi равна 1;

для непрерывных распределений

Типичные законы распределения и числовые характеристики случайных величин

Вид функций F(x), р(х), или перечисление р(хi) называют законом распределения случайной величины. Хотя можно представить себе бесконечное разнообразие случайных величин, законов распределения гораздо меньше. Во-первых, различные случайные величины могут иметь совершенно одинаковые законы распределения.

Во-вторых, очень часто случайные величины имеют подобные законы распределения, т.е., например, р(х) для них выражается формулами одинакового вида, отличающимися только одной или несколькими постоянными. Эти постоянные называются параметрами распределения.

Хотя в принципе возможны самые разные законы распределения, здесь будут рассмотрены несколько наиболее типичных законов. Важно обратить внимание на условия, в которых они возникают, параметры и свойства этих распределений.

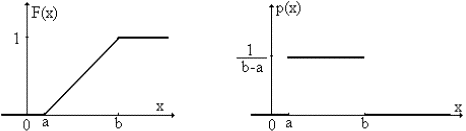

1 . Равномерное распределение

Так называют распределение случайной величины, которая может принимать любые значения в интервале (a,b), причем вероятность попадания ее в любой отрезок внутри (a,b) пропорциональна длине отрезка и не зависит от его положения, а вероятность значений вне (a,b) равна 0.

Функция и плотность равномерного распределения

Параметры распределения: a , b

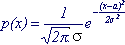

2 . Нормальное распределение

Распределение с плотностью, описываемой формулой

называется нормальным.

Параметры распределения: a , σ

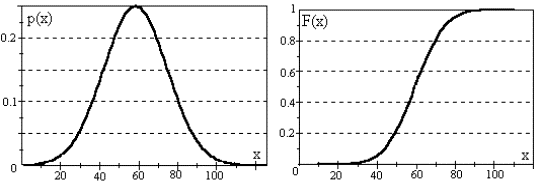

Типичный вид плотности и функции нормального распределения

3 . Распределение Бернулли

Если производится серия независимых испытаний, в каждом из который событие А может появиться с одинаковой вероятностью р, то число появлений события есть случайная величина, распределенная по закону Бернулли, или по биномиальному закону (другое название распределения).

Здесь n - число испытаний в серии, m - случайная величина (число появлений события А), Рn(m) - вероятность того, что А произойдет именно m раз, q = 1 - р (вероятность того, что А не появится в испытании).

Параметры распределения: n , р

4 . Распределение Пуассона

Распределение Пуассона получается как предельный случай распределения Бернулли, если устремить р к нулю, а n к бесконечности, но так, чтобы их произведение оставалось постоянным: nр = а. Формально такой предельный переход приводит к формуле

Параметр распределения: a

Распределению Пуассона подчиняются очень многие случайные величины, встречающиеся в науке и практической жизни.

Числовые характеристики случайных величин

1 . Математическое ожидание (среднее значение)

Определение:

Математическим ожиданием называется

- для дискретной случайной величины:

Сумма берется по всем значениям, которые принимает случайная величина. Ряд должен быть абсолютно сходящимся (в противном случае говорят, что случайная величина не имеет математического ожидания)

- для непрерывной случайной величины: ;

Интеграл должен быть абсолютно сходящимся (в противном случае говорят, что случайная величина не имеет математического ожидания)

Свойства математического ожидания:

a . Если С - постоянная величина, то МС = С

b . МСх = СМх

c . Математическое ожидание суммы случайных величин всегда равно сумме их математических ожиданий: М(х+y) = Мх + Мy d . Вводится понятие условного математического ожидания. Если случайная величина принимает свои значения хi с различными вероятностями p(xi/Hj) при разных условиях Hj, то условное математическое ожидание определяется

как или ;

Если известны вероятности событий Hj, может быть найдено полное

математическое ожидание: ;

.

e . Если f(x) - есть функция случайной величины х, то определено понятие математического ожидания функции случайной величины:

- для дискретной случайной величины: ;

Сумма берется по всем значениям, которые принимает случайная величина. Ряд должен быть абсолютно сходящимся.

-для непрерывной случайной величины: ; )

Интеграл должен быть абсолютно сходящимся.

2 . Дисперсия случайной величины

Определение:

Дисперсией случайной величины х называется математическое ожидание квадрата отклонения значения величины от ее математического ожидания: Dx = M(x-Mx)2

- для дискретной случайной величины: ;

Сумма берется по всем значениям, которые принимает случайная величина. Ряд должен быть сходящимся (в противном случае говорят, что случайная величина не имеет дисперсии)

- для непрерывной случайной величины: ;

Интеграл должен быть сходящимся (в противном случае говорят, что случайная величина не имеет дисперсии)

Свойства дисперсии:

a . Если С - постоянная величина, то DС = 0

b . DСх = С2Dх

c . Дисперсия суммы случайных величин всегда равно сумме их дисперсий только, если эти величины независимы (определение независимых величин)

d . Для вычисления дисперсии удобно использовать формулу:

Dx = Mx2 - (Mx)2

Связь числовых характеристик

и параметров типичных распределений

| распределение | параметры | формула | Mx | Dx |

| равномерное | a , b | | (b+a) / 2 | (b-a)2 / 12 |

| нормальное | a , σ | | a | σ2 |

| Бернулли | n , p | | np | npq |

| Пуассона | a | | a | a |