теория информации. ТИ (Best). Лекции по предмету "Теория информации" Красноярск 2002

Скачать 1.06 Mb. Скачать 1.06 Mb.

|

|

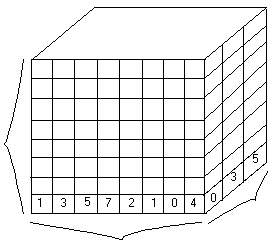

Кафедра ИУС Лекции по предмету "Теория информации" Красноярск 2002 Информация. Язык. ОбществоВсякий организм, в том числе и общ-й скрепляется наличием средств использования, хранения и передачи информации. Очень мало стабилизирующих процессов. Теория информации развивалась как наука в конце 40-х г.г. В её основу положены труды Шеннона, Винера, Колмогорова, Котельникова. Это полуматематическая наука, т.е. прикладное приложение к математике. Измерение информацииВажным вопросом в теории информации является установленные меры информации. В качестве меры информации выделяют структурные и статические меры. Структурные меры рассматривают дискретное строение массивов информации и измеряют информацию подсчётом числа возможных информационных измерений. Статические методы учитывают вероятность появления информационных символов и в качестве меры информации используют понятие энтропия – мера неопределённости состояния систем. Структурный методСтруктурные методы имеют дело с информационными массивами. Массив информации представим в виде кубика.  n – длина передаваемого числа; m – глубина числа; Поле – набор из элементов чисел m из гнезда выдвигаются нужное число, а число определено.

m - гнездо n Все ячейки называются числовой грядой (один слой). Совокупность слоев – это поле. Количество чисел, которое может быть представлено с помощью одной числовой гряды: В 1928г американец Хартли предложил использовать логическую меру: Статический методОбычно элементы сообщений не равновероятны, и это обстоятельство влияет на количество переданной информации. Пусть имеется алфавит из m элементов h1, h2, …,hm – элементы алфавита. Вероятности появления символов равны p1, p2, …,pm. Составим из этих элементов сообщения, содержащее n элементов. Среди них будут n1 элементов h1, n2 элементов h2, … nm элементов hm . Предположим, что появление каждого элемента независимое событие. Тогда вероятность появления определённой комбинации выражается произведением единичных вероятностей отдельных элементов и эту вероятность можно записать: При достаточно большой длине числа n, можно считать, что ni определяется как pi*n. Кроме того можно считать, что все сообщения равновероятны, тогда вероятность отдельного сообщения:  I = log2N – количество информации = Кол-во информации, отнесённое к одному символу Такая мера информации была введена Шенноном. Количество информации по Шеннону определяется как I. Измеряется [бит/символ]. Она характеризует количество переданной информации при неравновероятности появления символов и характеризует неопределённость состояния сообщения. |