теория информации. ТИ (Best). Лекции по предмету "Теория информации" Красноярск 2002

Скачать 1.06 Mb. Скачать 1.06 Mb.

|

Частная информация о системеПусть имеется две системы X и Y и они взаимосвязаны. Определим частную информацию о системе X, содержащуюся в отдельном сообщении. По теореме умножения вероятностей: pi,j = rj * p(xi / yj) – подставим в Частная информация как и полная, не может быть отрицательной величиной. Для вычисления частной информации через совместные вероятности используют преобразования. Пример: Система X и Y характеризуется таблицей вероятностей.

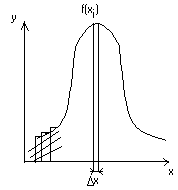

Частная информация о событии, получаемая в результате сообщения о другом событии. Если вероятность события pi увеличивает вероятность, т.е. p(xi, yj) больше pi, то информация больше нуля ( Энтропия и информация для систем с непрерывным множеством состояний Существуют непрерывные системы. Например, время безотказной работы прибора, координаты точки попадания при выстреле. Рассмотрим систему х, которая определяется непрерывной случайной величиной х с плотностью распределения f(x). Определим энтропию системы. Заменим непрерывную кривую f(x) ступенчатой. Площади прямоугольников f(xi)*x – вероятности попадания в них случайных величин.  Энтропия системы:  При достаточно малых Когда величина Условная энтропия непрерывной системы Пусть имеется две системы: X и Y, они взаимозависимы и непрерывны. f(x, y) – плотность распределения для состояния определнной системы. f1(x) – плотность распределения системы X. f2(y) – плотность распределения системы Y. f(y/x), f(x/y) – условная плотность распределения. Имея эти плотности, можно определить условную энтропию. Частная условная энтропия Полная средняя условная энтропия получившаяся в результате осреднения Для непрерывных систем – энтропия совместимых систем равна сумме энтропий. H(x, y) = H(x) + H(y / x) Пример: Найти энтропию непрерывной системы X, все состояния которой на участке от  H* =  H(x) = Подставляем f(x) и log в интеграл, получим после вычисления Проводимые исследования различных законов распределения показали, что наилучшим законом распределения является равномерный закон. Если накладываются ограничения - мощность сигнала равная постоянной величине, - наилучшим законом распределения является нормальный. |